우리 삶을 혁신적으로 바꾸고 있는 인공지능(Artificial Intelligence, AI). AI를 알고, 이해하고 또 활용하고 싶은 이들을 위해 <AAA – All Around AI>에서 AI 기술에 대한 모든 것을 알려드립니다. 앞선 회차에서 머신러닝(Machine Learning, 기계 학습)이 기존의 규칙 기반 인공지능에 비해 가지는 강점과 차이점을 알아보았습니다. 이번에는 딥러닝(Deep Learning, 심층 학습)의 개념과 대표적인 신경망 구조 등에 대해 살펴봅니다.

<시리즈 순서>

① AI의 시작과 발전 과정, 미래 전망

② AI 알고리즘의 기본 개념과 작동 원리

③ 머신러닝의 이해

④ 딥러닝의 이해

⑤ 스마트폰과 온디바이스(on-device) AI의 미래

⑥ 생성형 AI의 개념과 모델

딥러닝의 개념

▲ 머신 러닝과 딥러닝의 차이

딥러닝은 머신 러닝의 한 분야지만, 전통적인 머신 러닝 기법들과는 접근법에서 큰 차이를 보인다. 전통적인 머신 러닝은 도메인 지식*을 활용해 데이터의 특징(Feature)을 추출하고 이를 디자인한다. 이 과정은 사람의 시행착오와 노력이 필요했다. 다만, 훈련 과정은 비교적 쉬운 작업으로 디자인한 특징들에 적용할 가중치(Weight)만 학습하면 훈련이 완료되었다.

* 도메인 지식(Domain Knowledge): 특정 분야나 문제에 대한 전문적인 지식과 이해를 의미한다. 머신 러닝에서 도메인 지식은 해당 데이터의 특징(Feature)을 이해하고, 설계하는 과정에서 중요한 역할을 한다.

이와 달리 딥러닝은 심층 신경망(Deep Neural Network, DNN)을 사용해 복잡한 데이터 특성을 스스로 학습하고 추출한다. 여러 층(Layer)으로 이루어진 심층 신경망은 이전 층의 출력을 입력으로 받아 특정한 변환을 수행한 후 이를 그 다음 층으로 전달한다. 이 변환 과정은 뉴런* 간의 연결선에 할당되는 학습 가능한 파라미터*들과 활성화 함수*로 이뤄지며, 이 파라미터 값을 적절히 설정하는 것이 학습의 핵심이다.

* 뉴런(Neuron): 입력 신호를 받아 처리하고 출력을 생성하는 기본 단위. 노드(node)라고도 한다.

* 학습 가능한 파라미터(Learnable Parameter): 뉴런 간의 연결 강도를 나타내는 값으로, 주로 가중치(weight)와 편향(Bias)이 포함된다. 이 파라미터들은 학습 과정에서 최적화 알고리즘에 의해 조정되어 모델이 주어진 데이터에 대해 최적의 예측을 할 수 있도록 한다.

* 활성화 함수(Activation Function): 입력 신호의 총합을 비선형적으로 변환하여 뉴런의 최종 출력을 결정하는 함수

물론, 딥러닝에도 단점은 있다. 첫째, 많은 파라미터와 데이터가 필요해 상당한 연산량과 시간이 소요된다. 둘째, 심층 신경망을 잘 훈련시키기 위해 필요한 하이퍼파라미터(Hyperparameter)*를 찾기 위해서는 여전히 많은 시행착오가 필요하다. 마지막으로 딥러닝 모델은 그 작동 방식이 복잡해 어떤 요소가 예측에 중요한 역할을 하는지 파악하기 어렵다. 이는 딥러닝에 대한 신뢰성 문제로 이어져 실생활에 AI 모델을 적용하는 데 여러 법적, 제도적 걸림돌을 초래하고 있다.

* 하이퍼파라미터(Hyperparameter): 학습 가능한 파라미터와는 달리 학습 과정에서 자동으로 조정되지 않고 사전에 정의되는 값

그럼에도 딥러닝은 스스로 특징을 추출하는 성능 때문에 기존의 머신 러닝 방법론에 비해 월등히 우수한 성능을 보이며, 오늘날 인공지능 방법론의 대표 주자로 자리매김했다.

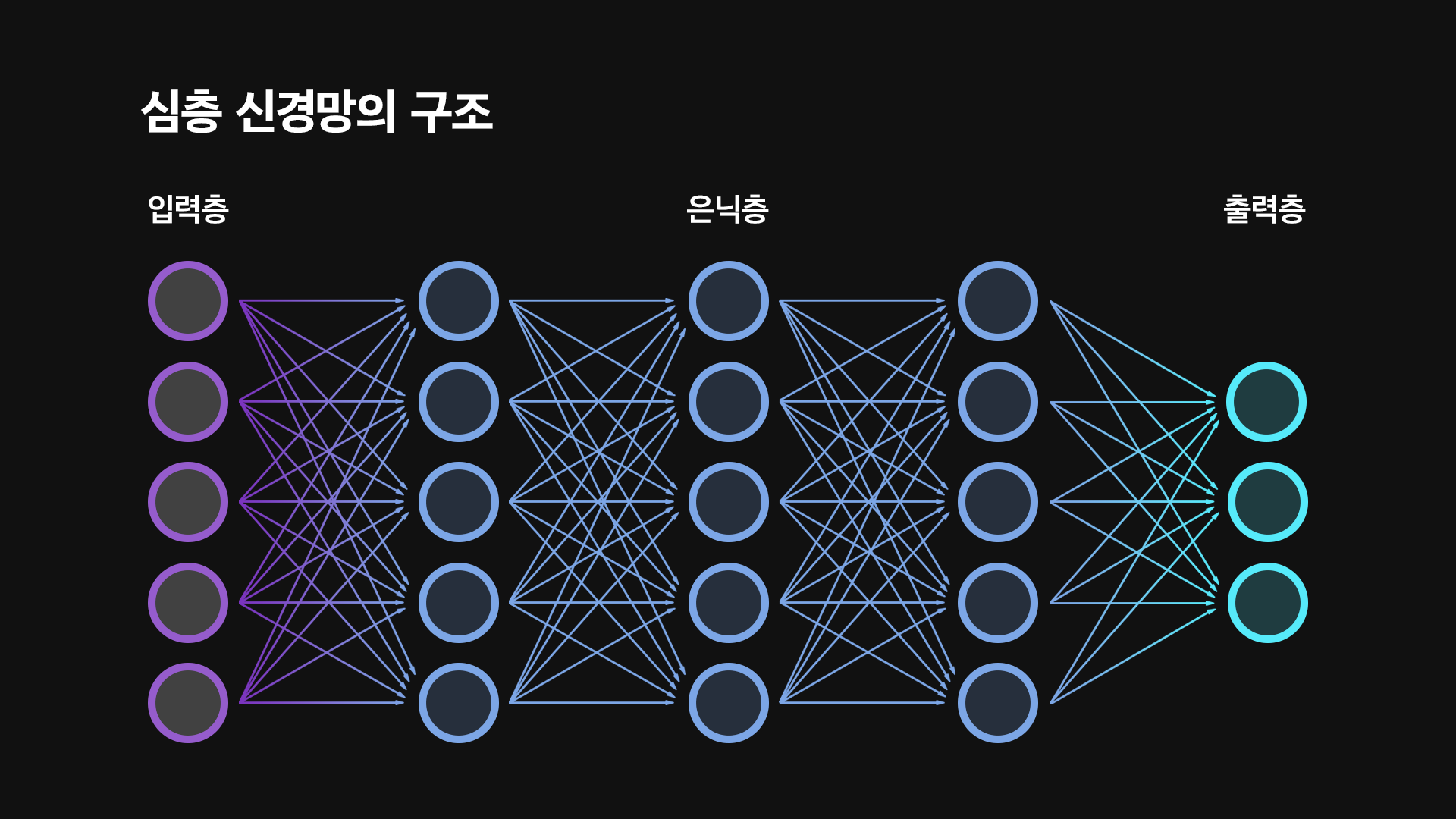

심층 신경망의 구조

딥러닝에서 사용되는 심층 신경망은 크게 세 가지 주요 층으로 구성되며, 각 층의 역할과 기능은 다음과 같다.

입력층(Input Layer)

입력층은 신경망에 데이터를 제공하는 첫 번째 층이다. 이 층은 외부로부터 데이터를 받아 신경망의 내부로 전달하는 역할을 한다. 예를 들어 이미지 처리에서는 각 픽셀의 값이 입력층으로 들어가며, 자연어 처리에서는 단어 또는 문자의 숫자화된 형태가 입력층으로 입력된다.

은닉층 (Hidden Layer)

은닉층은 데이터의 패턴이나 특징을 학습하는 층이다. 각 은닉층은 이전 층으로부터의 입력값을 받아 처리하고 다음 층으로 결과를 전달한다. 이 과정에서 각 입력값에 특정 가중치를 곱하여 중요한 특징을 더 잘 인식할 수 있게 한다. 은닉층의 수는 문제의 복잡성, 데이터의 양, 그리고 모델의 성능 요구 사항에 따라 다르게 설정된다.

출력층 (Output Layer)

출력층은 신경망의 마지막 층으로 결과나 예측을 나타낸다. 출력층에서는 가능한 답들의 확률을 계산해, 가장 높은 확률을 가진 답을 최종적으로 선택한다.

심층 신경망은 이 구조를 기본으로 다양한 모델을 개발하고 개선하며 발전해 왔다. 대표적으로 ▲모든 뉴런이 서로 연결된 기본 신경망 구조인 ‘완전 연결 신경망(Fully-Connected Network)’ ▲이미지 처리에 최적화된 ‘합성곱 신경망(Convolutional Neural Network)’ ▲문장 번역이나 음성 인식 같은 연속된 데이터 처리에 적합한 ‘순환 신경망(Recurrent Neural Network)’ ▲복잡한 이미지 분류 작업에 사용되는 ‘잔차 신경망(Residual Network)’ ▲자연어 처리 분야에서 처음 제안되어 챗GPT(ChatGPT)를 비롯한 거대 언어 모델(Large Language Model, LLM) 등 최신 AI 모델의 근간이 되는 ‘트랜스포머(Transformer)’ 등이 있다.

이와 같은 신경망 구조들은 각각의 특성에 맞춰 다양한 분야에서 활용되며, 딥러닝의 예측 성능을 높이는 데 기여하고 있다.

심층 신경망의 학습 과정

심층 신경망의 학습 과정은 크게 순전파와 역전파 과정으로 구성된다. 순전파는 입력 데이터를 신경망에 정방향으로 통과시켜 예측값을 얻는 과정이다. 즉, 입력 데이터가 신경망에 주어지면, 각 층의 뉴런이 이를 처리하여 다음 층으로 전달하고, 이 과정을 반복하여 출력층에서 최종 예측값을 생성한다.

예를 들어, 손으로 쓴 숫자를 인식하는 신경망을 구성했다고 가정해 보자. 입력층에 숫자 이미지가 제공되면, 첫 번째 은닉층은 이미지의 간단한 특징들(예: 선의 방향, 모서리)을 추출하여, 이를 다음 층으로 전달한다. 마지막 은닉층은 훨씬 더 복잡한 특징들을 결합하여 숫자를 판별하는 데 필요한 정보를 형성한다. 이렇게 순전파를 통해 최종적으로 예측 결과를 얻게 되는 것이다.

이후 이 예측값과 실제값(라벨)을 비교하여 손실 함수로 예측의 정확도를 평가한다. 손실이 크다는 것은 예측이 실제값과 많이 다르다는 뜻이다. 손실이 계산되면 역전파 과정이 시작된다. 역전파는 손실값을 최소화하기 위해 신경망의 파라미터 값을 조정하는 과정이다. 이 과정은 순전파와는 반대로, 출력층에서 입력층 방향으로 진행된다.

출력층에서 손실 함수의 변화에 따른 기울기(Gradient)를 계산하고, 이 기울기와 각 뉴런의 활성화 함수 기울기를 바탕으로 각 파라미터가 손실 함수에 미치는 영향을 평가한다. 이렇게 파라미터에 대한 손실 함수의 기울기가 계산되면, 경사 하강법* 등의 최적화 알고리즘을 사용해 파라미터 값을 손실 함수가 작아지는 방향으로 업데이트한다. 신경망은 이 과정을 여러 번 반복해 점점 더 정확한 예측을 하는 모델로 발전하게 된다.

* 경사 하강법(Gradient Descent: 비용 함수를 최소화하기 위해 기울기를 따라 매개변수를 업데이트하는 최적화 알고리즘

한편, 일반적으로 신경망의 출력 층은 마지막 은닉층 뉴런들의 출력값에 가중치(Weight)를 곱한 후 이들을 더해 예측값을 출력한다. 때문에 맨 마지막 은닉층 뉴런의 출력값은 신경망이 데이터로부터 학습하고 추출해 낸 특징으로 간주할 수 있다.

딥러닝의 역사를 바꾼 대표 사례

최근 10여 년간 딥러닝은 수많은 성공 사례를 보여주면서 인공지능의 양적/질적 성장을 주도해 왔다. 대표 사례를 몇 가지 꼽자면 아래와 같다.

1)합성곱 신경망과 이미지넷(ImageNet)

이미지 인식 분야는 딥러닝이 크게 발전시킨 분야 중 하나로, 여기에는 합성곱 신경망의 역할이 컸다. 합성곱 신경망은 이미지의 지엽적인 부분에서 패턴을 추출하는 데 특화된 구조로, 여러 합성곱 층을 쌓아 이미지의 계층적 구조를 효과적으로 파악하고 특성을 추출하는 모델을 만들 수 있다.

이러한 딥러닝 방법론의 우수성을 널리 알린 대표적인 사례는 2012년의 이미지넷 대규모 시각 인식 챌린지(ImageNet Large Scale Visual Recognition Challenge, ILSVRC)이다. 이 대회에서 토론토 대학의 제프리 힌튼(Geoffrey E. Hinton) 교수의 연구팀이 개발한 AlexNet이라는 딥러닝 모델은 기존의 전통적인 기계 학습 방법론들을 크게 능가하는 성능을 보이며 우승을 차지했다. 당시 AlexNet의 에러율은 15.3%로, 2등을 차지한 모델인 26.2%에 비교하면 매우 낮은 수치다. 이러한 성과는 컴퓨터 비전 분야에 큰 충격을 안겨주었고, 이후 딥러닝은 컴퓨터 비전의 다양한 분야에서 뛰어난 성능을 보여주고 있다.

2) 알파고, 바둑을 마스터하다

바둑은 경우의 수가 워낙 많아 AI가 정복하기 불가능한 게임이라 여겨왔다. 그러나 구글 딥마인드에서 개발한 알파고는 이런 믿음을 완전히 깨부수며 AI의 능력에 대한 대중의 관심을 불러일으켰다.

2016년, 알파고는 프로바둑기사 이세돌 선수와 대결을 펼쳤다. 실제 대국이 이뤄지기 전까지는 인공지능이 정상의 프로기사를 넘어서기에는 아직 부족하다는 예상이 지배적이었으나, 실제 이뤄진 대국에서는 4:1로 알파고가 이세돌 선수를 압도하며 세계를 놀라게 했다. 이처럼 놀라운 성능의 바둑 AI를 만들기 위한 딥마인드의 접근법은 딥러닝, 강화 학습 그리고 확률적 탐색 알고리즘을 접목시키는 것이었다. 인간의 기보를 통해 바둑판의 돌의 배열 상태와 수에 대한 ‘점수’를 심층 신경망으로 학습하고, 강화 학습을 사용해 스스로 대국을 반복하며 전략을 정교하게 다듬어 뛰어난 실력을 연마할 수 있었다.

3) 또 다른 딥마인드의 혁신, 알파폴드

▲ 알파폴드는 오랫동안 난제로 여겨져온 ‘단백질 접힘 문제’를 AI라는 새로운 접근법을 통해 효율적으로 풀어가고 있다.

알파고 이후 구글 딥마인드가 2018년에 처음 발표한 알파폴드(AlphaFold)는 단백질의 3차원 구조를 높은 정확도로 예측할 수 있는 딥러닝 모델이다. 단백질의 접힘 구조는 신약 개발 등 의학, 생명과학 연구에서 중요한 역할을 하지만, 구조를 파악하는 데는 비용과 시간이 많이 소모된다. 알파폴드는 이 문제를 아미노산의 배열에서 3차원 구조를 예측할 수 있는 신경망을 훈련시키는 방법으로 접근했고, 단백질 구조 예측(Critical Assessment of Protein Structure Prediction, CASP) 대회에서 기존에 방법을 능가하는 성능으로 1등을 차지했다. 이후 딥마인드는 현재까지도 꾸준히 알파폴드를 업데이트하며 신약 개발에 더욱 효과적으로 활용될 수 있도록 개선하고 있다.

4) 점점 다가오는 완전자율주행시대

▲ 웨이모 드라이버가 소개하는 완전 자율주행 기술

딥러닝은 꿈으로만 여겨져 왔던 완전 자율주행을 현실로 만드는 데 핵심적인 역할을 하고 있다. 신경망을 사용해 카메라, 라이다(LiDAR), 레이더, GPS 등 다양한 센서로부터의 입력을 처리하고, 강화 학습 알고리즘을 사용해 차량의 조작 방법을 결정하는 것이다. 알파벳이 소유한 웨이모는 이미 미국 일부 지역에서 운전기사 없이 완전히 자동으로 운영되는 택시를 운행하고 있다.

또 테슬라는 오토파일럿 시스템을 중심으로 한 첨단 운전자 보조 시스템(Advanced Driver Assistance System, ADAS)을 제공하며 궁극적으로 운전자 없는 완전 자율 주행을 목표로 하고 있다. 테슬라는 라이다와 레이더 센서에 대한 의존도를 최소화하고, 차량에 장착된 다수의 카메라로 주변을 인식해 판단한다. 테슬라는 방대한 실제 주행 데이터를 활용하여 지속적으로 모델을 개선하고 있다. 이러한 기술적 진보는 완전 자율주행 시대에 대한 기대감을 불러왔지만, 기술의 안정성에 대한 법적·제도적 승인 등 여전히 극복해야 할 장애물은 남아 있다.

5) GPT 시리즈의 등장

오픈AI(OpenAI)가 개발한 GPT(Generative Pre-trained Transformer) 시리즈는 트랜스포머 구조를 기반으로 한 대형 언어 모델(Large Language Model, LLM)의 일종이다. 이 대형 언어 모델이 하는 일은 생각 외로 간단한데, 주어진 맥락을 바탕으로 다음에 올 자연스러운 단어를 예측하는 것이다. 모델의 크기가 커지고 데이터가 많아질수록, 처리할 수 있는 맥락의 길이도 길어지고, 번역, 질의응답, 작문까지도 수행할 수 있다.

2022년, GPT-3.5를 기반으로 한 챗봇인 챗GPT가 발표되었고 곧 GPT-4로 업데이트 되었는데, 자연스러운 대화 기능과 작문 능력으로 사회 전반에 엄청난 충격을 주었다. 교육, 사무, 작문, 개발 등 실생활 전반에서 생산성을 비약적으로 향상시켜줄 수 있는 대형 언어 모델의 잠재성을 증명했기 때문에, 챗GPT의 성공은 인공지능 업계에 큰 변화를 불러일으켰다.

※ 본 칼럼은 반도체/ICT에 관한 인사이트를 제공하는 외부 전문가 칼럼으로, SK하이닉스의 공식 입장과는 다를 수 있습니다.