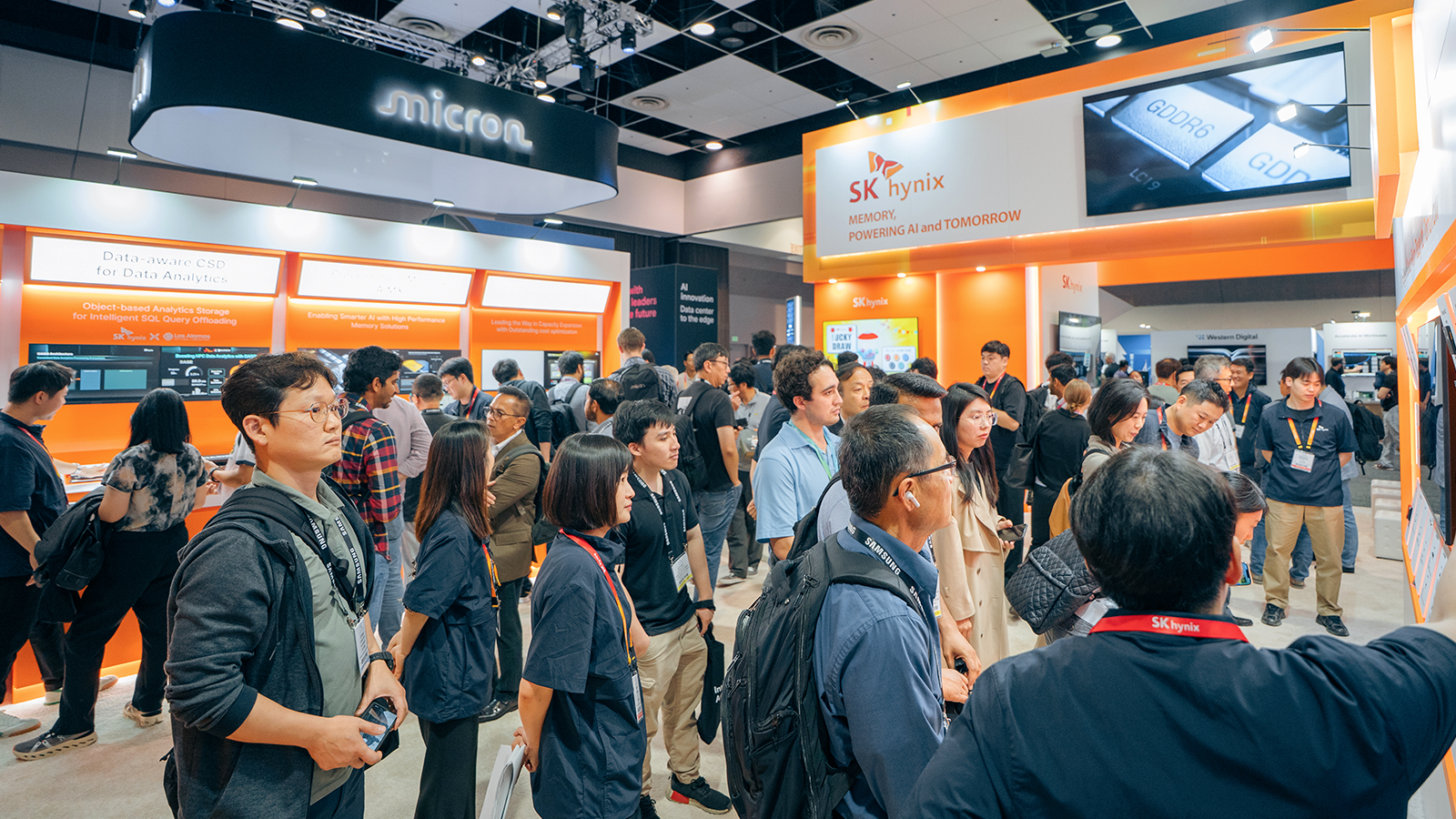

▲ FMS 2025 SK하이닉스 부스 전경

SK하이닉스가 지난 5일부터 7일까지(미국시간) 3일간 미국 캘리포니아주 산타 클라라(Santa Clara)에서 열린 FMS(Future of Memory and Storage) 2025에 참가해 D램 및 낸드 제품과 AI 메모리 설루션을 선보이며 글로벌 메모리 시장에서의 리더십을 재확인했다.

올해로 19주년을 맞이한 FMS는 기존 Flash Memory Summit(플래시 메모리 서밋)에서 AI 시대에 발맞춰 지난해부터 행사명을 the Future of Memory and Storage(미래 메모리 및 저장장치, 이하 FMS)로 새롭게 정의하고, D램을 포함한 메모리 및 스토리지 전 영역으로 분야를 확대했다.

SK하이닉스는 ‘풀스택 AI 메모리 프로바이더(Full Stack AI Memory Provider)’로서 차세대 AI 혁신을 이끌 다양한 메모리 제품과 미래 기술을 선보였다. 특히, 기조연설과 발표 세션, 부스 전시를 유기적으로 연계하여 회사의 메모리 및 스토리지 설루션을 효과적으로 알리고, 글로벌 파트너사들이 SK하이닉스의 선도적인 기술 리더십을 직접 체감할 수 있도록 하며 교류를 한층 강화했다.

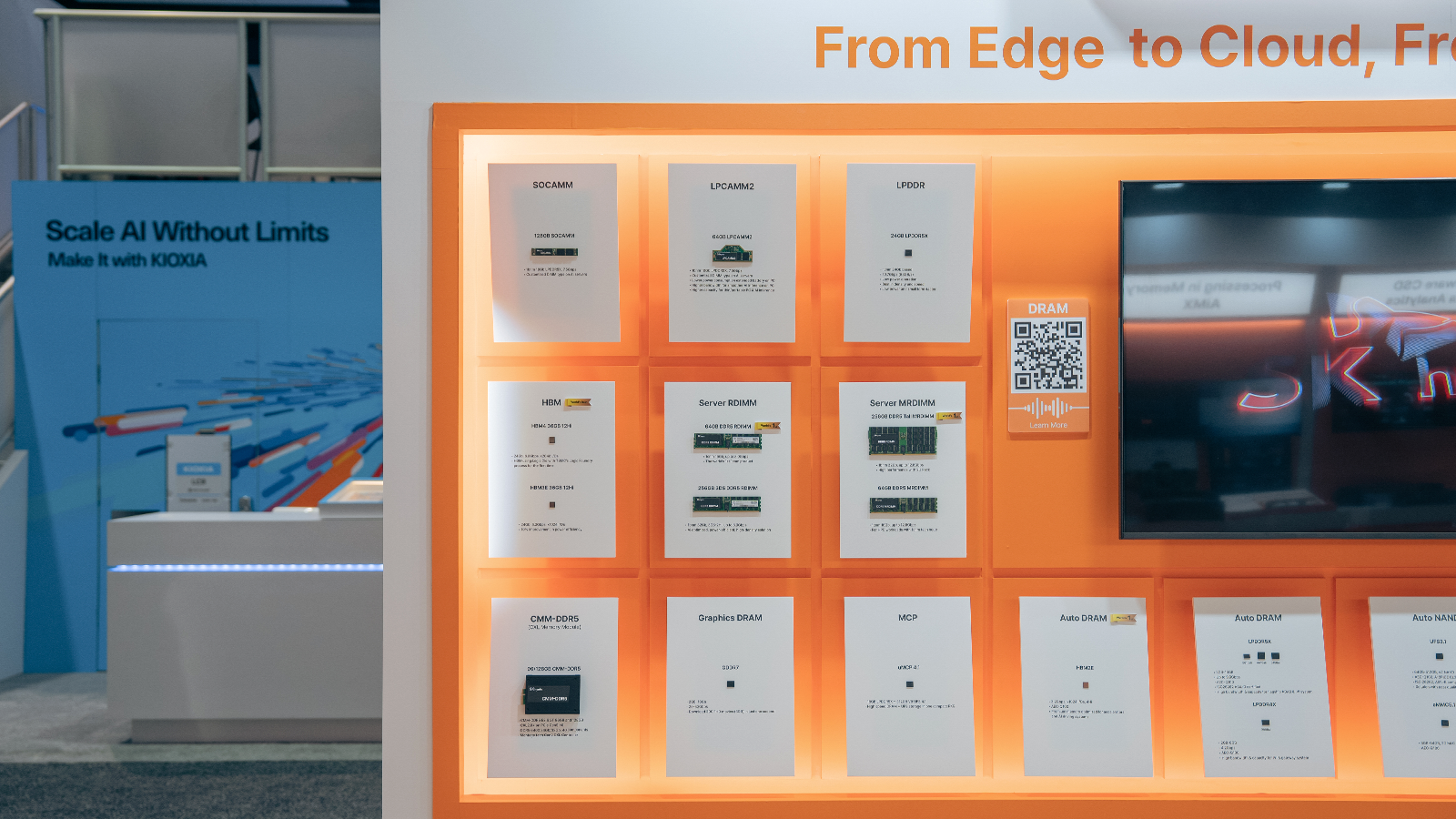

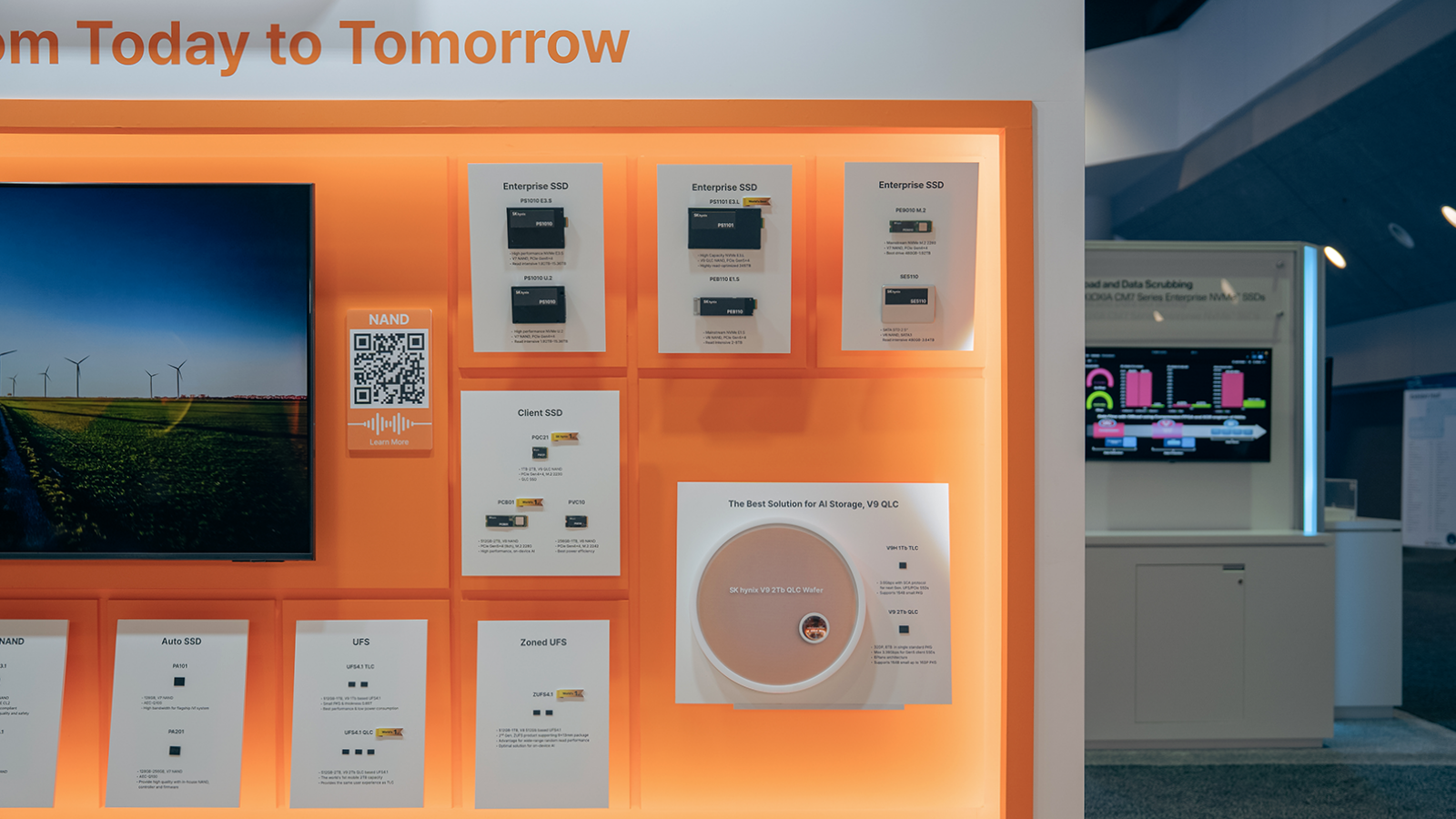

AI 시대를 겨냥한 메모리 라인업 총출동

이번 행사에서 SK하이닉스는 D램과 낸드 전 영역에서 글로벌 AI 메모리 시장을 이끌 차세대 제품을 대거 전시했다. 업계 최초로 주요 고객사들에 샘플을 공급한 ▲HBM4 12단을 비롯해 ▲LPDDR5X ▲CMM(CXL* Memory Module)-DDR5 ▲3DS* RDIMM ▲Tall MRDIMM* 등의 차세대 D램 14종과 176단 4D 낸드 기반의 데이터센터 eSSD인 ▲PS1010 E3.S, 238단 4D 낸드 기반의 ▲PEB110 E1.S는 물론, 회사의 첫 QLC* PC 향 SSD인 PQC21 및 최고 용량 데이터센터 eSSD 245TB PS1101 E3.L를 새롭게 선보이는 등 총 19종의 낸드 설루션 제품들도 만나볼 수 있었다.

* CXL(Compute Express Link): 고성능 컴퓨팅 시스템에서 CPU/GPU, 메모리 등을 효율적으로 연결해 대용량, 초고속 연산을 지원하는 차세대 인터페이스

* 3DS(3D Stacked Memory): 2개 이상의 D램칩을 TSV(수직관통전극)로 연결해 패키징을 완료한 고대역폭 메모리 제품

* MRDIMM(Multiplexed Rank Dual In-line Memory Module): 여러 개의 D램이 기판에 결합된 서버용 모듈 제품으로, 모듈의 기본 동작 단위인 랭크(Rank) 2개가 동시 작동되어 속도가 향상된 제품

* QLC: 낸드플래시는 한 개의 셀(Cell)에 몇 개의 정보(비트 단위)를 저장하느냐에 따라 SLC(Single Level Cell, 1개)-MLC(Multi Level Cell, 2개)-TLC(Triple Level Cell, 3개)-QLC(Quadruple Level Cell, 4개)-PLC(Penta Level Cell, 5개) 등으로 규격이 나뉨. 정보 저장량이 늘어날수록 같은 면적에 더 많은 데이터를 저장할 수 있음

▲ SK하이닉스가 전시한 CMM-DDR5 데모

SK하이닉스는 제품 전시와 함께 성능 시연을 진행하며, 회사의 앞선 기술력과 차별성을 현장에서 생생하게 보여주었다. 먼저, 기존의 기본 서버 시스템을 기반으로 최대 50% 확장된 용량과 30% 향상된 메모리 대역폭을 제공하는 CMM-DDR5가 장착된 Intel Xeon 6 시연을 통해 실제 운용 환경에서의 활용 가능성과 시스템 확장성을 동시에 보여주었으며, 기존 단일 메모리 구성에 비해 성능과 비용 효율 측면에서 뛰어난 경쟁력을 갖추고 있음을 강조했다.

SK하이닉스는 미국 로스앨러모스 국립연구소*와 HPC 환경에서의 데이터 분석 성능 향상을 위한 차세대 스토리지 기술을 공동 연구하고 있다. 이번 데모에서는 데이터를 스스로 인지하고 분석 처리할 수 있는 Data-aware CSD* 기반의 Computational Storage(OASIS)를 개발해 실제 HPC 워크로드를 통해 데이터 분석 성능이 향상되는 효과를 시연하면서 관람객들의 큰 주목을 받았다.

* 로스앨러모스 국립연구소(Los Alamos National Laboratory, LANL): 미국 에너지부 산하 국립연구소이며, 국가 안보와 핵융합 분야를 비롯해 우주 탐사 등 다양한 연구를 수행한다. 특히, 2차 세계대전 당시 맨해튼 프로젝트에 참여해 세계 최초로 핵무기를 개발한 곳으로 알려짐

* CSD(Computational Storage Drive): 데이터를 직접 연산하는 저장장치

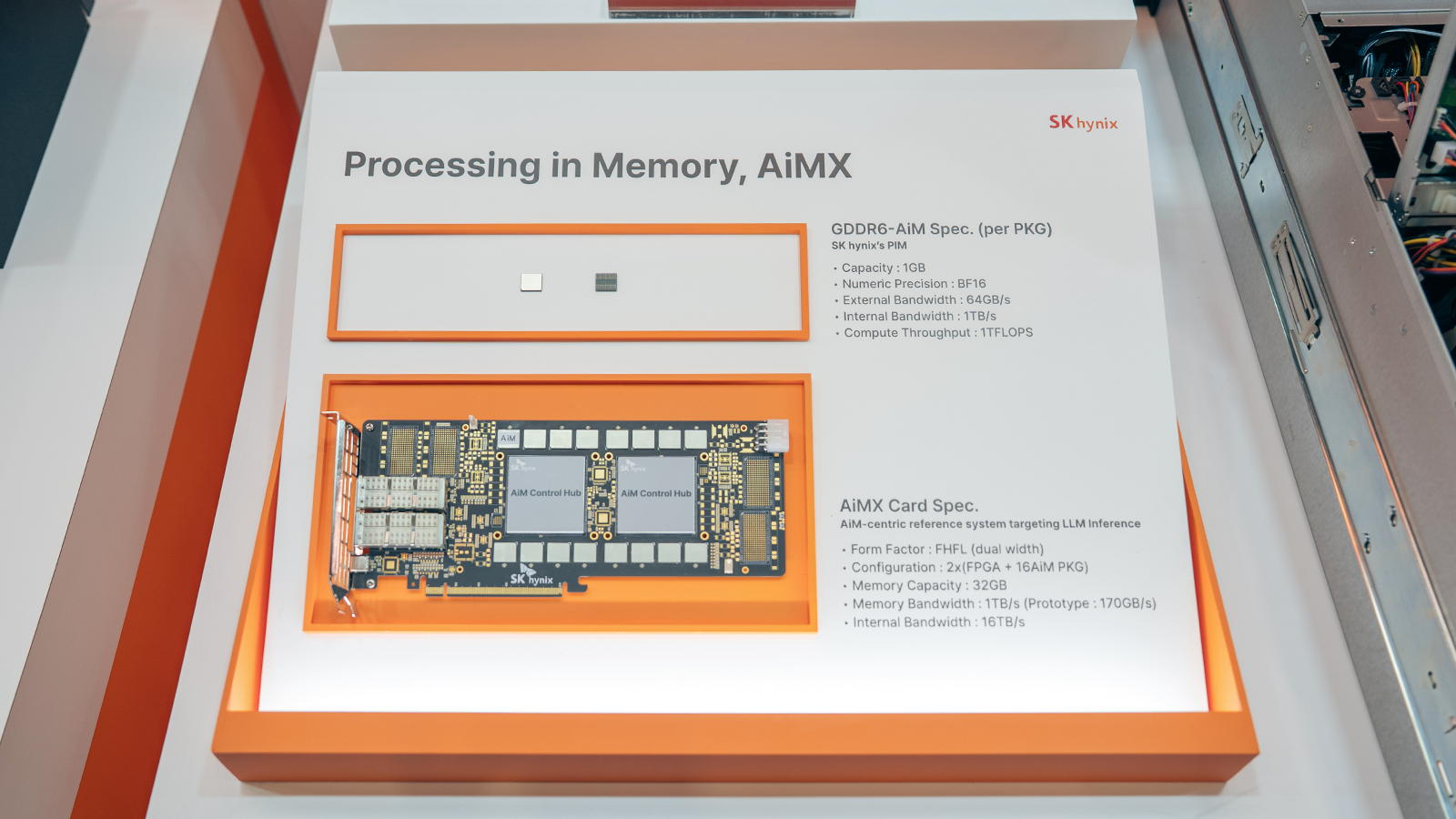

이번 데모에서는 SK하이닉스의 PIM* 제품군도 직접 확인할 수 있었다. 초당 16Gb(기가비트)의 속도로 데이터를 처리하는 GDDR6에 연산기능이 추가된 ▲GDDR6-AiM은 CPU/GPU와 함께 사용할 경우, 특정 조건에서 연산 속도가 최대 16배 이상 향상되는 제품이다. 또한 가속기 카드인 ▲AiMX*는 연산 처리 속도를 가속화하고 전력 소모를 줄여 대용량 데이터를 효율적으로 처리할 수 있는 고성능 저전력 설루션 제품이다.

* PIM(Processing-In-Memory): 메모리 반도체에 연산 기능을 더해 인공지능(AI)과 빅데이터 처리 분야에서 데이터 이동 정체 문제를 풀 수 있는 차세대 기술

* AiMX(AiM based Accelerator): GDDR6-AiM 칩을 사용해 대규모 언어 모델(Large Language Model, 대량의 텍스트 데이터로 학습하는 인공지능으로 챗GPT가 이에 해당)에 특화된 SK하이닉스의 가속기 카드 제품

▲ CXL Pooled Memory 설루션을 활용해 시연 중인 Memory Centric AI Machine 데모

마지막으로 Memory Centric AI Machine 데모에서는 Pooled Memory*를 활용하여 복수의 서버와 GPU들을 연결한 분산 LLM 추론 시스템을 선보였다. 네트워크 통신을 이용하는 LLM 추론 시스템 대비 CXL Pooled Memory 기반 데이터 통신을 사용할 경우 LLM 추론 시스템의 성능이 대폭 향상될 수 있음을 입증했다.

* Pooled Memory: 여러 개의 CXL 메모리를 묶어 풀(Pool)을 만들어 여러 호스트가 효과적으로 용량을 나누어 사용하여 전반적인 메모리 사용률을 높이는 기술

FMS 2025의 주요 연사로 참여해 차세대 AI 인프라 리더십 강조

SK하이닉스는 기조연설과 Executive AI 특별패널 참여 그리고 총 13번의 세션 발표 등 FMS 2025의 주요 연사로 참여해 차세대 AI 메모리 시장을 이끄는 글로벌 리더의 면모를 보여줬다.

SK하이닉스 김천성 부사장(eSSD PD 담당)과 최준용 부사장(HBM사업기획 담당)은 ‘Where AI begins: Full-Stack Memory Redefining the future’라는 주제로 기조연설을 진행했다. 김천성 부사장은 이번 기조연설에서 “AI 산업이 AI 학습에서 AI 추론으로 빠르게 전환됨에 따라 메모리 기술의 진화가 필수적”이라고 전하며 “SK하이닉스의 스토리지 설루션은 AI 추론 시나리오에서 데이터 집약적인 워크로드에 빠르고 안정적으로 액세스할 수 있도록 설계되어 있다”고 설명했다.

이어 최준용 부사장은 “높은 대역폭과 낮은 전력 소모라는 구조적 장점을 갖춘 HBM은 고객들의 다양한 요구를 충족할 수 있다”라며, “AI 시스템의 확장성과 TCO를 형성하는 두 가지 핵심 요소인 성능과 전력 효율성을 충족하기 위해 다양한 AI 환경에 최적화된 포괄적인 메모리 포트폴리오를 제공할 것”이라고 전했다.

3일간 이어진 세션 발표에서는 회사의 구성원들이 주요 강연자로 참석해 메모리 기술과 인프라 확장, 비휘발성 및 고효율 메모리 기술, AI 인프라와 LLM 학습 최적화, 데이터 분석 및 거버넌스, AI 기반 인재 관리 등에 대해 발표하며 차세대 AI 시장에 대한 인사이트를 공유했다.

또한, SK하이닉스 강선국 부사장(미주DRAM기술 담당)은 NVIDIA가 주관한 Memory and Storage Scaling for AI Inferencing에 대한 특별패널 토론에 참여해 AI 기술 동향과 산업 간 협력 방안에 대해 깊이 있게 논의했다. 그는 “AI 학습에는 원시 대역폭이 중요하지만, AI 추론에는 이를 넘어선 지능형 메모리와 스토리지 설루션이 필요하다”며, 초고성능 네트워킹과 스마트 메모리 기술이 AI 추론 처리량을 획기적으로 높일 수 있다고 강조했다.

이번 행사를 통해 SK하이닉스는 혁신적인 제품들을 다양하게 선보이며, 메모리 및 스토리지 분야에서의 뛰어난 기술 역량을 널리 알렸다. 앞으로도 AI 시대의 변화하는 요구에 부응하여 끊임없는 연구개발을 이어가고, D램과 낸드 전 영역에서 독보적인 AI 메모리 리더로서의 입지를 더욱 확고히 다져 나갈 계획이다.