0과 1로 움직이는 디지털 세상 속에서 ‘반도체가 이끄는 산업의 현재와 미래’를 조망하는 다큐멘터리 시리즈, [세미의 시대; 세상을 설계하는 작은 조각]을 새롭게 선보입니다.

SK하이닉스 뉴스룸이 깊이 있게 준비한 이번 시리즈에서는 산업별 최신 이슈를 심층적으로 분석하고, 전문가와 함께 해법 및 발전 방향을 모색합니다. 이 과정에서 작지만 혁신적인 반도체 기술이 어떤 돌파구를 제시하는지도 살펴봅니다. 1편에서는 AI 데이터센터가 불러온 기후위기의 실태를 짚어보고, 그 해결책으로 주목받는 반도체 기술을 조명합니다.

“챗GPT(ChatGPT)에 ‘고맙다’는 말을 자제해 주세요.”

– 샘 올트먼(Samuel H. Altman) 오픈AI 최고경영자

모든 것을 알고 있고 무엇이든 답하는 생성형 AI이지만, 유독 ‘인사’만은 자제 해달라고 당부한다. 우리가 AI에게 건네는 짧은 인사 한마디가 전력 소비를 증가시키고 지구를 더 뜨겁게 만들어 기후위기를 앞당기고 있기 때문이다. AI를 쓰면 쓸수록 지구가 뜨거워진다는 역설적인 현실 속에서 뉴스룸은 AI가 환경에 미치는 영향을 구조적으로 살펴보고 해결책을 모색해 봤다.

급증하는 데이터센터 전력 소비… 원인은 ‘AI 서버’

지난 2023년 챗GPT의 등장과 함께 생성형 AI가 확산되면서 일상과 산업 전반은 큰 변화를 맞았다. 가장 큰 영향을 받은 분야는 ‘데이터센터(Data Center)’였다. AI 서비스가 급증하면서 AI 연산량도 기하급수적으로 늘었는데, 이로 인해 전력 소비와 탄소 배출도 급격히 증가했다.

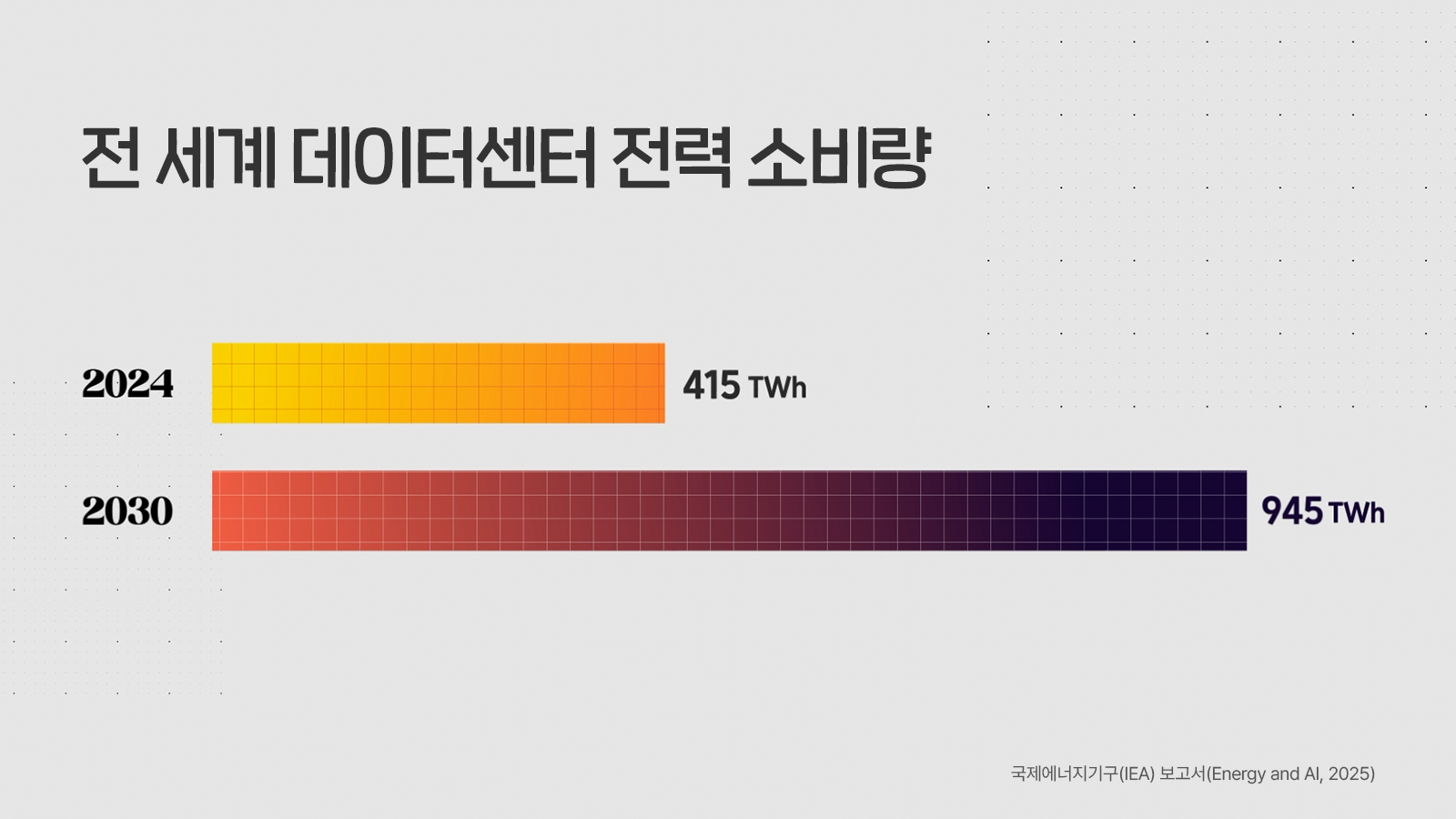

국제에너지기구(IEA) 보고서(Energy and AI, 2025)에 따르면, 2024년 전 세계 데이터센터 전력 소비량은 약 415TWh(테라와트시)에 달할 것으로 추정된다. 이는 주행거리 약 500km의 전기차 55억 대를 충전할 수 있는 막대한 양이다. 더 심각한 문제는 이 수치가 앞으로 더욱 증가한다는 사실이다. IEA는 2030년 데이터센터 전력 소비량이 약 945TWh를 기록할 것으로 전망했다.

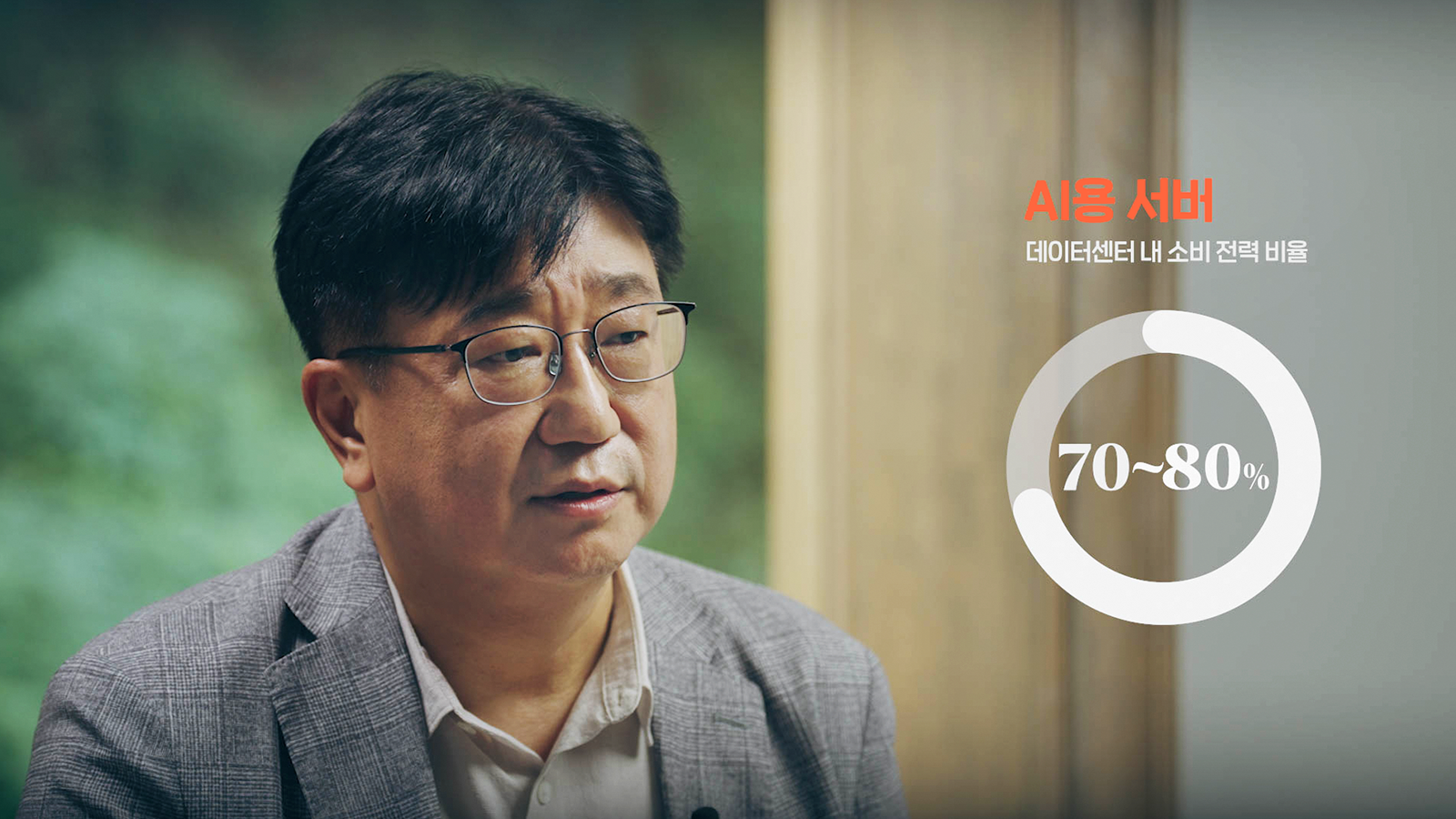

▲ 이병훈 교수(포스텍 반도체공학과)가 AI 서버의 전력 소비량에 관해 설명하고 있다.

원인은 AI 연산을 담당하는 가속 서버(Accelerated Server), 즉 AI 서버에 있다. 이 서버의 GPU는 CPU 기반의 일반 서버보다 월등히 많은 전력을 소비한다. 이병훈 교수(포스텍 반도체공학과)는 “AI 서버는 일반 서버보다 약 7~8배 많은 전력을 사용하며, 특히 CPU 중심의 AI 연산 과정에서 막대한 전력이 소모된다”고 설명했다.

데이터센터 전력 소비의 상당 부분을 AI 서버가 차지한다는 사실은 IEA 보고서에서도 엿볼 수 있다. IEA에 따르면 2030년 AI 서버의 전력 소비량은 약 300TWh에 이를 전망이다. 이는 전체 소비량의 약 1/3에 해당한다. 정리하자면 AI 활용이 늘수록 AI 서버의 전력 소비량과 탄소 배출도 급격히 증가할 수밖에 없는 것이다.

탄소 배출과 기후변화 우려… 다각적 해결책 필요

정수종 교수(서울대학교 기후테크센터 센터장)는 “2030년 데이터센터 전력 소비량인 945TWh는 일본 전체 전력 소비량과 비슷한 수준”이라며 “이러한 데이터센터 전력 소비로 인해 약 25억 톤의 탄소가 배출될 가능성이 있다”고 경고했다.

▲ 정수종 교수(서울대 기후테크센터 센터장)가 AI 데이터센터의 탄소 배출 문제를 지적하고 있다.

데이터센터에서 촉발된 기후변화 원인 물질이 지구온난화를 가속화해 다양한 부작용을 초래할 수 있다는 게 그의 설명이다.

하지만 AI 발전을 멈출 수 없기에 전문가들은 탄소 배출 최소화를 위한 다각적 해결책을 모색해야 한다고 입을 모은다. IEA에 따르면 AI 기반 에너지 관리와 워크로드 스케줄링 등 소프트웨어 최적화만으로도 최대 15%의 에너지를 절약할 수 있다. 또 데이터센터 효율 개선, 친환경 재생에너지 활용, 소형모듈원자로* 및 탄소포집* 등 새로운 대체 에너지 개발도 검토되고 있다.

* 탄소포집(Carbon Capture Utilization and Storage, CCUS): 발전소나 산업시설에서 나오는 이산화탄소를 포집해 지하 저장하거나 재활용하는 기술

근본적인 해결책은 반도체 기술 혁신이다. 데이터센터 주요 전력 소모원이 AI 서버인 만큼, 이 서버의 핵심 부품인 반도체의 성능과 효율을 높이는 것은 가장 효과적인 해결책일 수밖에 없다. 관련해 이병훈 교수는 “새로운 반도체 기술로 전력 소모를 기존 대비 1/100 수준까지 줄이는 연구가 진행 중”이라며 “데이터 이동량 감소를 위한 새로운 아키텍처도 고려되고 있다”고 밝혔다.

SK하이닉스, AI 메모리 기술로 데이터센터 전력 문제 해결

SK하이닉스 역시 데이터센터의 전력 효율을 높이기 위해 다양한 AI 메모리를 개발하고 있다.

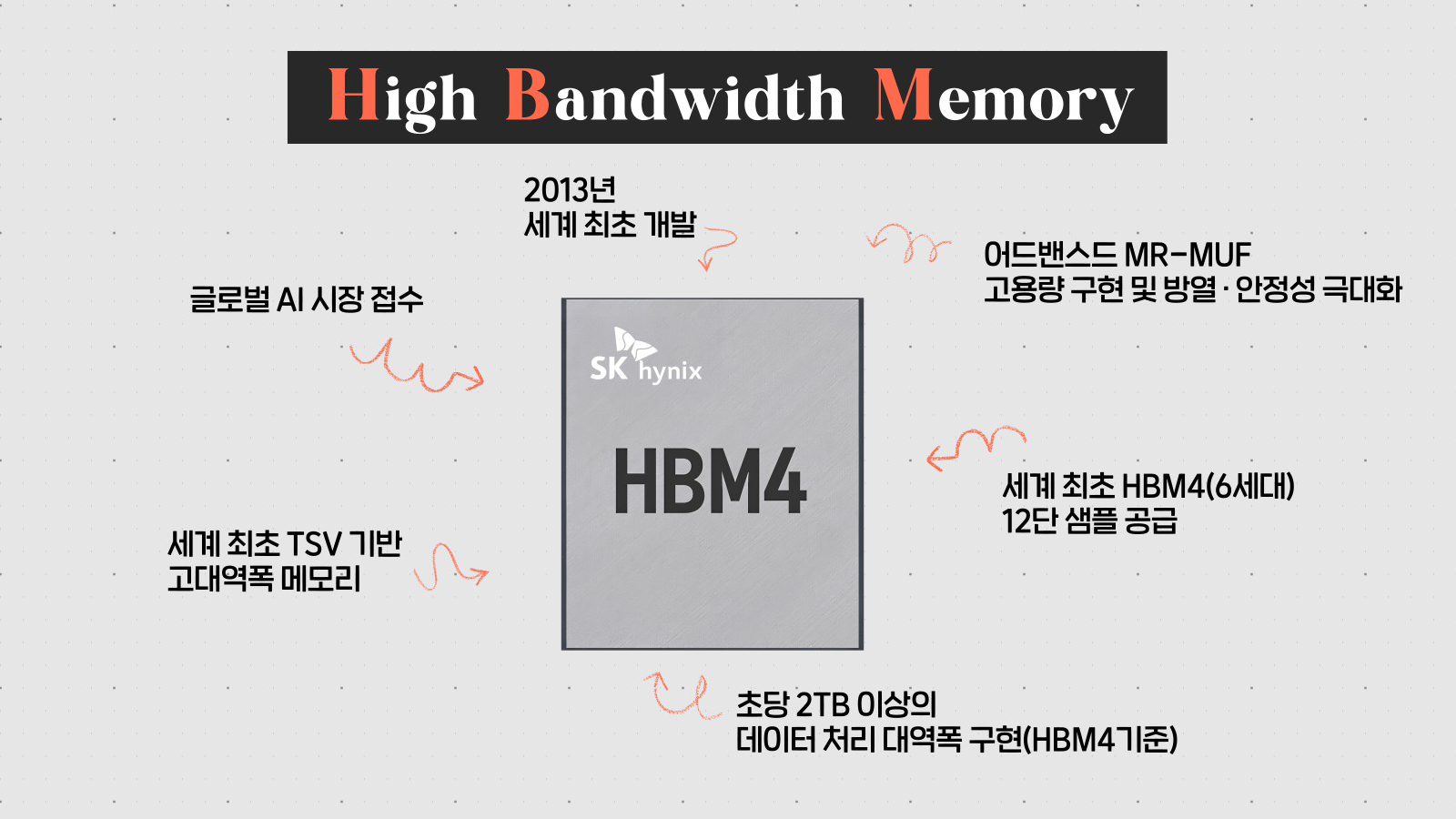

고대역폭 메모리 HBM(High Bandwidth Memory)에는 어드밴스드 MR-MUF* 기술을 적용해 방열성과 안정성을 높였다. 최근에는 베이스다이(Base Die) 성능과 전력 효율을 개선한 HBM4 샘플도 선보였다.

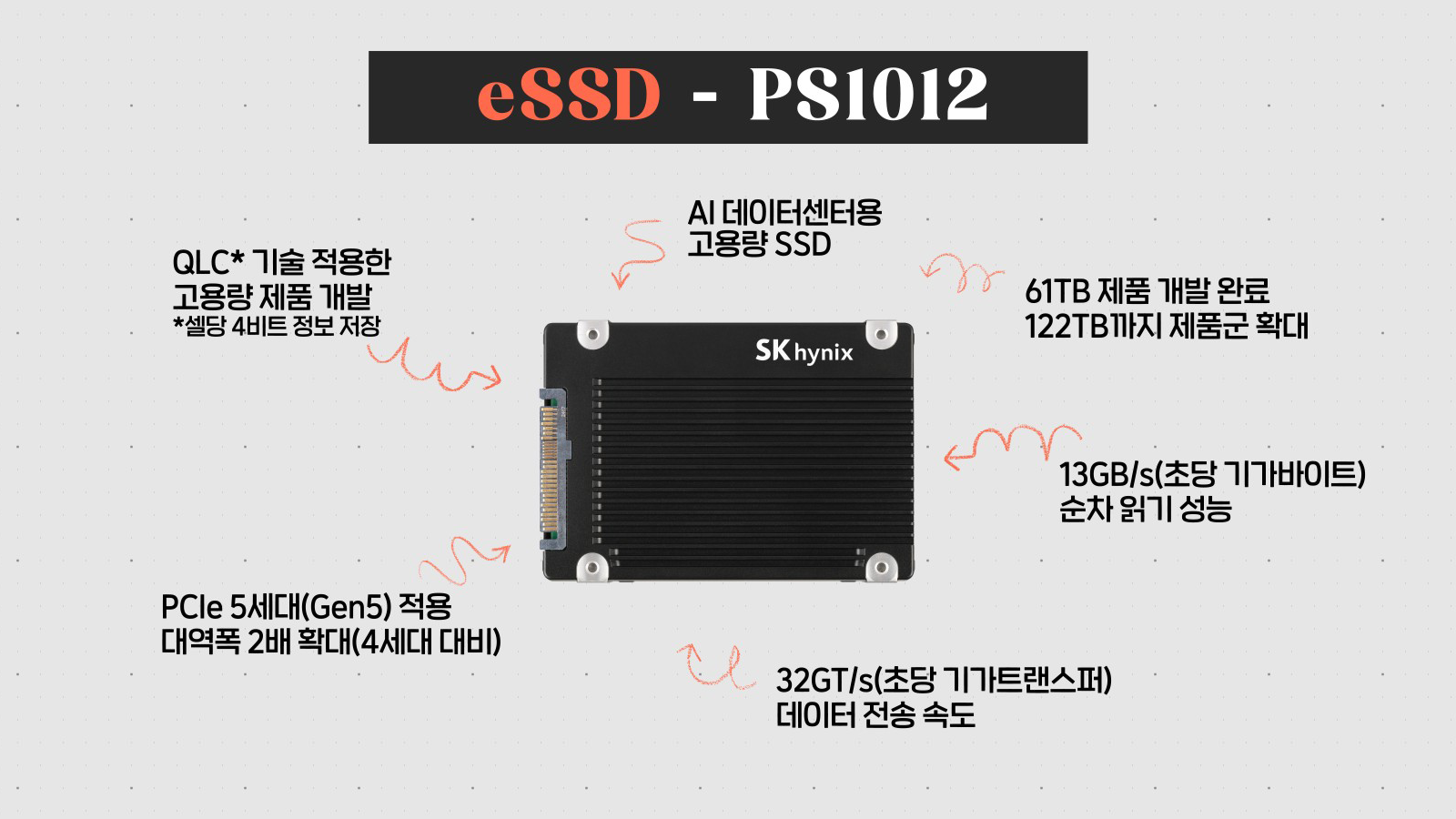

전력 소모를 줄여주는 AI 데이터센터용 고용량 eSSD(기업용 SSD) 개발도 지속적으로 이뤄지고 있다. QLC* 기반 PS1012는 제한된 공간에 더 많은 데이터를 담고, 빠른 전송 속도로 AI 학습 시간을 줄여 전력 소비를 낮추는 데 기여할 수 있다.

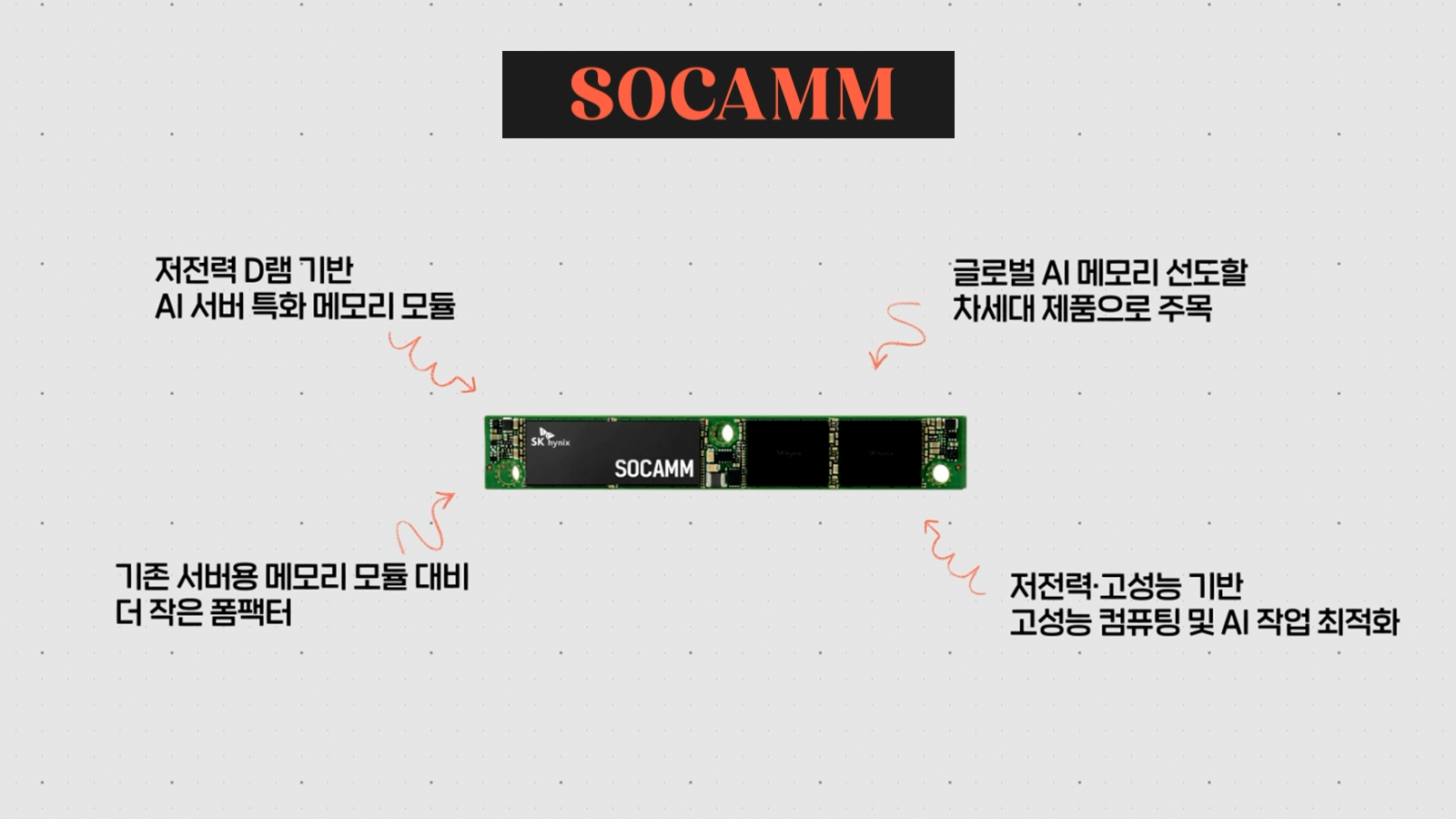

저전력 D램 기반의 AI 서버 특화 메모리 모듈 SOCAMM*도 개발 중이다. 기존 서버용 메모리 대비 작은 폼팩터를 갖춘 이 제품은 AI 데이터센터의 에너지 효율을 높이는 데 기여할 것으로 기대된다.

이와 같이 SK하이닉스는 다양한 고효율 메모리 기술을 개발하며, 데이터센터 문제에 직접적인 해법을 제시하는 중이다.

* QLC: 낸드플래시는 한 개의 셀(Cell)에 몇 개의 정보(비트 단위)를 저장하느냐에 따라 SLC(Single Level Cell, 1개)-MLC(Multi Level Cell, 2개)-TLC(Triple Level Cell, 3개)-QLC(Quadruple Level Cell, 4개)-PLC(Penta Level Cell, 5개) 등으로 규격이 나뉨. 정보 저장량이 늘어날수록 같은 면적에 더 많은 데이터를 저장할 수 있음

* SOCAMM(Small Outline Compression Attached Memory Module): 기존의 서버용 메모리 모듈보다 더 작은 폼팩터를 가지면서 전력 효율이 높은 저전력 D램 기반의 AI 서버 특화 메모리 모듈

AI 메모리 기술과 함께 AI의 발전은 앞으로도 계속될 전망이다. 투자 또한 계속된다. 스타게이트 사(社)는 2029년까지 수 GW(기가와트)급 데이터센터를 건설할 계획이며, 대만도 엔비디아와 협력해 AI 데이터센터를 건립한다고 밝혔다. 한국의 경우 SK가 AWS와 협력해 울산에 100MW(메가와트)급 친환경 AI 데이터센터를 건설하며, 장기적으로 1GW 규모로 확대한다는 계획이다.

이처럼 세계 곳곳에서 데이터센터의 수가 빠르게 증가하는 가운데, AI의 발전 속도는 결국 얼마나 효율적으로 에너지를 관리하느냐에 달려 있다고 해도 과언이 아니다. 어쩌면 그 시작은 작은 반도체 칩 하나에 달려 있을지도 모른다.