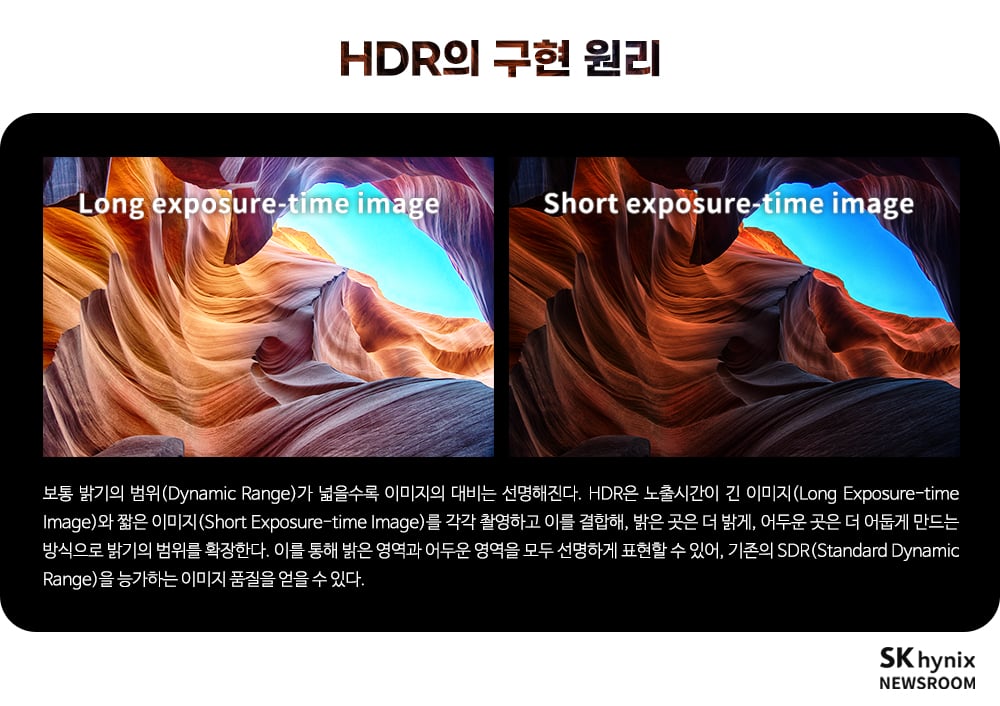

사진을 찍을 때 뚜렷한 대비를 사용하면 실제로 보이는 것을 완전히 담아내지 못할 때가 많다. 이럴 때 기술과 현실 사이의 격차를 줄여주는 기술이 바로 HDR(High Dynamic Range)이다. HDR 센서를 설계하는 엔지니어들은 일종의 화가가 돼, 실험실을 작업실로 삼고 반도체를 붓과 물감으로 사용해 카메라라는 캔버스 위에 가장 풍부한 색상을 담아낸다.

카메라를 사용해본 사람 중 대부분은 이미 HDR 기능을 사용해봤을 것이다. 하지만 이 기능의 원리를 정확하게 이해하고 이 기능을 사용하는 사람은 아마도 극소수에 불과할 것이다. HDR은 정확히 어떤 기능일까? HDR은 어떻게 더 실물에 가까운 이미지를 생성할까? 이 같은 궁금증에 대한 해답을 찾아 HDR이 구현하는 완벽한 실사 이미지의 비밀을 파헤쳐봤다.

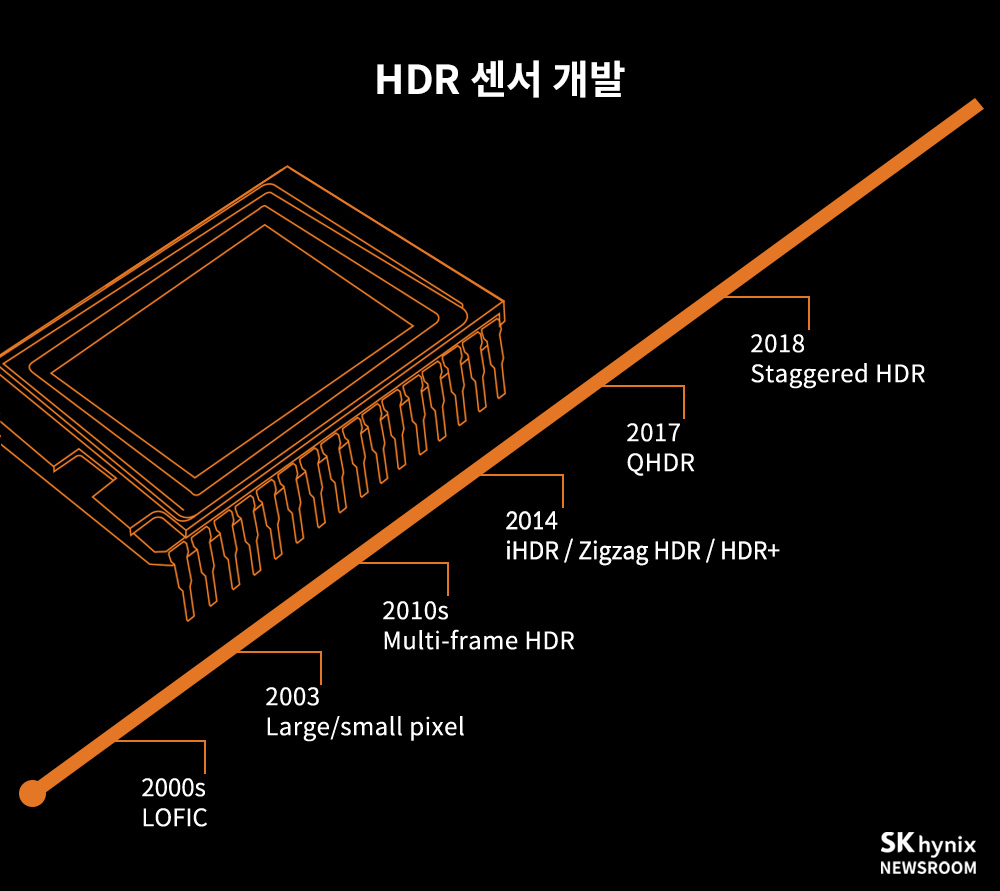

길고 긴 HDR 센서 개발의 여정, 어디까지 왔나?

HDR 기술을 구현하는 핵심 기술은 센서 기술이다. 센서 없이는 프레임에 담긴 풍경을 카메라에 실시간으로 기록할 수 없기 때문. 그렇기에 HDR에 대해 제대로 이해하기 위해서는 이미지 센서 기술이 어떻게 발전해왔는지, 또 이러한 발전이 HDR 기술의 탄생과 발전에 어떤 영향을 미쳤는지 먼저 살펴볼 필요가 있다.

▶ 2000년대 – LOFIC

![]()

이미지 센서의 픽셀(Pixel)은 빛을 전기 신호로 변환해 이미지를 생성하는데, 센서가 너무 밝은 물체를 감지하면 너무 많은 전하가 단일 픽셀에 결집돼 과도하게 노출된 이미지가 생성된다.

‘LOFIC(Lateral Overflow Integration Capacitor)’의 구조는 중국의 훠궈(火鍋) 냄비와 유사한 구조로, 이처럼 전하가 픽셀의 최대 부하(FWC, Full Well Capacity)를 초과하면 인접한 픽셀(포트)로 흘러 들어가 넘쳐흐르지 않는다. 이러한 원리로 밝은 이미지를 선명하게 표현해낼 수 있다.

하지만 LOFIC은 그 구조가 정교해 오늘날의 얇고 가벼운 전자장치에는 적용하기 어렵다. 이 때문에 최신 카메라나 스마트폰에서는 LOFIC을 탑재한 사례를 찾아보기 어렵다.

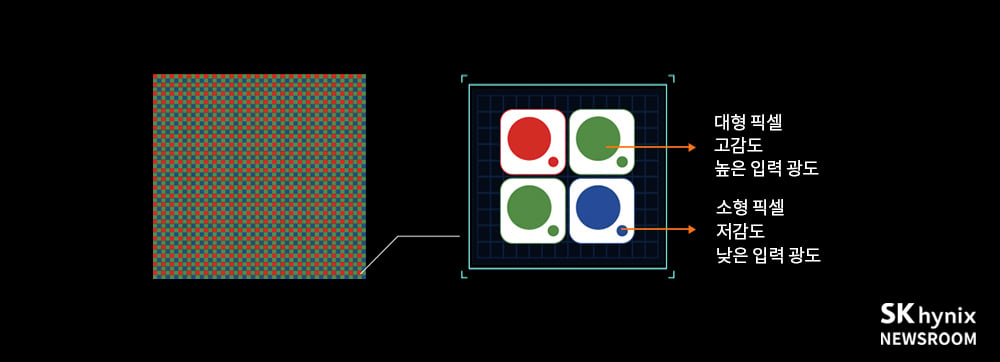

▶ 2003년 – Large/Small Pixel

일본의 IT 기업 후지쯔(Fujitsu)는 2003년 각 색상의 픽셀에 크고 작은 포토다이오드(Photodiode)1)를 사용해 픽셀을 차별화함으로써 HDR을 구현한 센서인 ‘Super CCD SR’을 출시했다. 이 센서는 각 프레임에서 큰 픽셀과 작은 픽셀의 사진을 동시에 촬영한 다음 노출이 많은 이미지와 노출이 적은 이미지를 각각 생성한다. 이 이미지들은 HDR 이미지로 결합돼 다양한 동적 범위를 포함할 수 있지만, 이미지 결함률이 높아 대규모로 채택되지 못했다.

1) Photodiode: 빛 에너지를 전기 에너지로 변환하는 광(光) 센서.

▶ 2010년대 – Multi-frame HDR

HDR 기술의 가장 일반적인 적용 사례는 노출 수준이 다른 여러 이미지를 촬영하고 이를 결합해 완벽한 HDR 이미지를 생성하는 것이다. ‘Multi-frame HDR’은 이러한 사례 중 가장 오래된 접근 방식 중 하나다. 사진마다 각기 다른 노출 시간을 적용하고 여러 장의 사진을 연속적으로 찍어 겹친 다음, 최상의 사진 구역(Segment)을 선택한 후 결합해 최종 사진을 만든다.

하지만 움직이는 물체를 촬영하거나 촬영 중 카메라가 흔들리면 모션 아티팩트(Motion Artifact)2)가 발생해 위 사진에서 보듯이 다리가 8개인 말이 나타날 수가 있다.

2) Motion Artifact: 촬영 시 피사체의 움직임으로 인해 촬영된 실제로는 없는 잔상.

▶ 2014년 – iHDR

‘iHDR(Interlaced HDR)’은 모션 아티팩트를 제거하기 위해 센서를 여러 줄로 나누고 두 선마다 노출을 길고 짧게 설정한다. 셔터를 누르면 긴 노출과 짧은 노출이 동시에 시작돼 노출이 다르게 적용된 두 개의 이미지가 만들어지고, 이를 활용해 HDR 이미지를 생성한다.

하지만 iHDR 기술이 적용되면 해상도가 절반으로 떨어져, 종종 부자연스러운 이미지를 생성했다. 이러한 문제와 여러 단점으로 인해 결국 iHDR 장치는 양산되지 못했다.

▶ 2014년 – Zigzag HDR

소니(Sony)는 iHDR의 업그레이드 버전인 ‘Zigzag HDR’을 통해 픽셀 배열의 또 다른 가능성을 제안했다. 이 센서는 iHDR과 마찬가지로 긴 노출과 짧은 노출을 동시에 사용하지만, 노출 패턴을 지그재그(Zigzag)로 배열했다. 이 같은 접근 방식으로 해상도 손실을 효과적으로 방지해 더 자연스러운 이미지를 생성할 수 있다. 양산에 실패한 iHDR과 달리, Zigzag HDR은 비디오 촬영에는 적용이 가능했다.

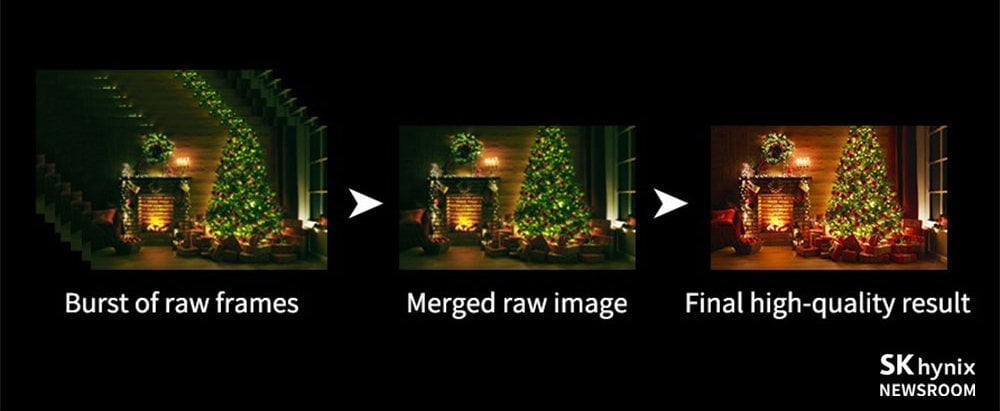

▶ 2014년 – HDR+

구글(Google)은 같은 해 HDR+를 출시했다. HDR+에서는 HDR 이미지를 얻기 위해 동일한 노출로 이미지를 최소 8번 연속 촬영해 중첩하고, 어두운 영역의 세부 사항과 이미지 노이즈를 식별하는 알고리즘을 사용한다. 구글 카메라의 ‘버스트 모드(Burst Mode)’3)를 사용하면 셔터를 누르기 전에 자동으로 사전 촬영을 수행해 HDR 이미지 촬영(Capture)을 가속화할 수 있다. 이는 Multi-frame HDR에 비하면 크게 향상된 기법이다.

3) Burst Mode: 연사를 통해 짧은 시간에 여러 장의 고화질의 이미지를 촬영하는 촬영 모드

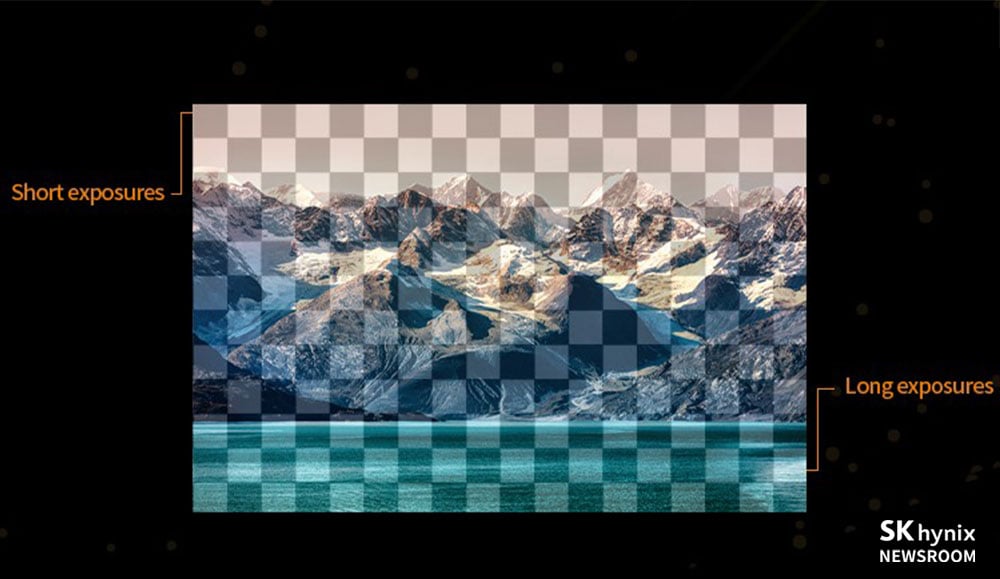

▶ 2017년 – QHDR

‘QHDR(Quad HDR)’은 라인 정렬 방식과 픽셀 배열 방법이 Zigzag HDR과 다르다. QHDR은 각 2×2 픽셀 영역 단위마다 노출 설정을 다르게 할 수 있도록 지원한다. 이 기술은 효과와 속도 면에서 비디오 촬영에 이상적이다.

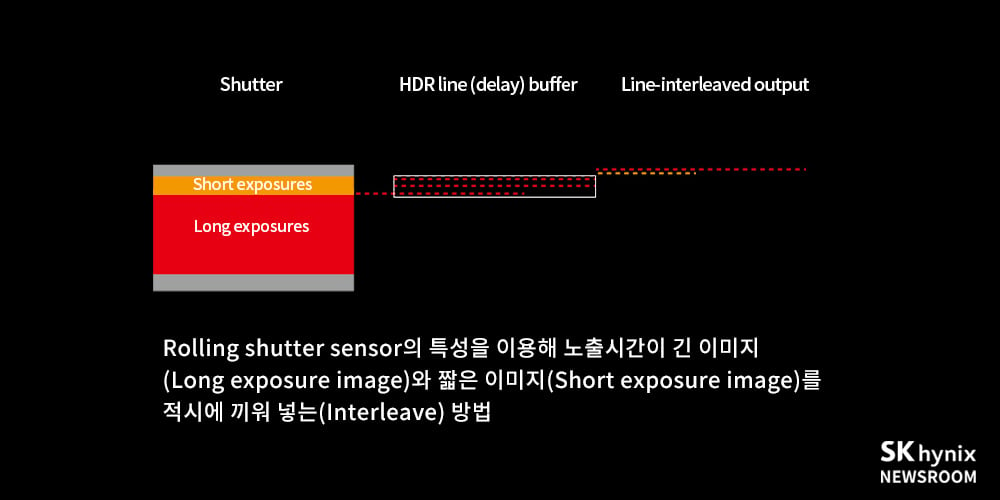

▶ 2018년 – Staggered HDR

‘Staggered HDR’은 셔터를 위에서 아래로 스크롤해 한 줄씩 정보를 읽은 다음 긴 노출과 짧은 노출 데이터를 출력한다. 긴 노출 라인의 출력 프로세스는 동시에 짧은 노출 라인의 이미지를 생성해 두 라인 사이의 이미지를 밀접하게 연결한다. 이 방법을 사용하면 iHDR 이미지의 부자연스러운 모양을 제거할 수 있고, 모션 아티팩트를 효과적으로 감소시킬 수 있다.

SK하이닉스 CIS(CMOS Image Sensor) 기술의 현재와 미래

그간 카메라 기술은 인체의 시각 시스템을 모방하는 방향으로 진화해왔다. 기술 진화의 목표는 소비자가 보고 느끼는 것과 디지털 미디어에 저장된 이미지가 제공하는 결과물 사이의 간격을 줄이는 것이다. 이를 실현하기 위해 기존 개발 과정에서 설정한 중요한 방향성은 픽셀 크기를 줄여 고해상도를 달성함으로써 선명한 이미지를 담아내는 것이었다.

또한 최근에는 각 픽셀의 색상 표현 측면에서도 HDR 기술의 중요성이 강조되고 있다. SK하이닉스는 QHDR와 Staggered HDR 기술 개발을 모두 완료하고, 고객에게 제공할 준비를 갖췄다.

특히 고해상도 제품에 적용되는 QHDR은 센서가 내장된 ISP(Image Signal Processor)를 이용해 실시간 이미지 처리가 가능하고, 움직이는 물체의 경우에도 고해상도의 선명한 이미지를 제공할 수 있다.

앞으로 관련 기술이 더 발전해 정확한 색상과 풍부한 조명 표현이 가능하게 되면 HDR 기술은 카메라 기술의 중추가 될 것이다. 또한 CIS 센서에 AI를 적용하면 HDR 기술이 한 단계 더 진보될 것으로 기대된다.

아울러 HDR 기술은 인간의 신경망을 이용해 시각 인식 특성을 모델링하는 방식으로도 발전할 것이다. 이는 저조도 노이즈를 제거하고 채도 영역에서 발생하는 손실된 정보를 복원하기 위한 것이다.

이런 노력들을 통해 HDR 기술은 앞으로도 계속해서 인간의 눈에 더욱 가까워지기 위해 발전해나갈 것이다.