불리한 환경 속에서도 악의 세력에 맞서 싸운 제다이 기사와 소수 저항군의 용기와 희생, 그리고 결국에는 훌륭한 작전으로 승리하는 스타워즈 시리즈의 감동은 오래도록 많은 사람들에게 깊은 감동을 안겨줬다. 특히 이 영화의 하이라이트인 광선검 결투 장면 못지않게 R2-D2와 C-3PO, BB-8 등 안드로이드 로봇들의 활약도 인상 깊었는데, 이들이 없었다면 짜릿한 대역전극은 절대 연출될 수 없었을 것이다.

올해 CES1)의 최대의 화두는 로봇과 메타버스라고 볼 수 있다. CES를 통해 미뤄볼 때, 스타워즈와 같은 SF영화에 나올 법한 로봇들을 한 가정에 최소 하나씩 보유하는 시대가 조만간 도래할 것으로 보인다. 이미 주변에서 배달용 로봇2)과 자율주행차, 로봇청소기 그리고 하늘을 날아다니는 드론 등 단지 사람의 모습이 아닐 뿐 사람의 역할을 대신 수행하는 기계들을 쉽게 찾아볼 수 있다.

한편, 코로나19와 같은 팬데믹 시대 속에 비대면 생활방식이 우리 일상에 깊숙이 자리 잡으며, 가상과 현실의 경계를 허무는 메타버스(Metaverse) 서비스도 폭발적인 인기와 수요를 일으켰다. 이에 따라 AR/VR3) 기술에 대한 관심도 폭증하고 있다. 지금의 스마트폰처럼 모든 사람들이 AR/VR 기기를 갖고 다니면서 은행, 관공서를 직접 방문하거나 공장에 들어가지 않고도 자기 자리에서 업무를 보거나 제품을 생산하고 유지보수하는 것이 가능한 시대가 올 것이다.

▲ (그림 1)로봇과 메타버스의 실생활 활용 예시 – Ocado 배달로봇

1) CES: 세계 최대 가전 박람회 행사, 미국 라스베가스에서 개최되며 현재는 가전만이 아니라, 로봇, 모빌리티 등 전 산업에 들어가는 전자제품들의 신기술이 발표되고 있다.

2) 배달용 로봇: 애플리케이션 기업이나 일부 편의점에서 시범 운행 중이다.

3) AR: 증강 현실(Augmented Reality), VR: 가상 현실(Virtual Reality).

기계의 눈(Machine Vision)

반도체 공정과 영상 처리 기술이 눈부시게 발달하면서 ‘CMOS(Complementary Metal Oxide Semiconductor) Image Sensor(이하 CIS)’ 기술은 저렴한 가격과 함께 높은 해상도와 뛰어난 성능을 바탕으로 스마트폰뿐만 아니라 다양한 기기들의 눈으로 채택되고 있다. 특히 카메라 성능의 잣대가 되고 있는 화소(畵素, Pixel) 경쟁이 치열해지면서, 최근에는 사람의 눈을 능가하는 6억 화소가 언급되고 있을 정도로 관련 기술의 발전 속도가 빨라지고 있다.

▲ (그림 2) 기계의 눈이 되기 위한 필요 기능

그런데 고해상도만 만족하면 기계의 눈에 적합하다고 할 수 있을까? 아무리 선명하다고 해도 2D 이미지 정보만으로는 사람의 일을 대신해주고 안전과 보안을 책임질 첨단 기기의 눈으로는 뭔가 부족하다. 영화 속 R2-D2처럼 적진에 침투해 임무를 수행할 안드로이드가 아니더라도 고속주행 중 정확한 제동이 필요한 자율주행차나 드론, 사진이 아닌 실제 사람의 얼굴을 스캔해야 되는 안면 인식 기술, 넓은 공간을 실시간으로 스캔해 증강현실을 구현하는 AR기기 등을 구현하기 위해서는 2D 이미지뿐만 아니라 3D 이미지 정보가 필수적이다.

카메라 없이도 초음파, 레이저 기기 등 부수적인 도구들로 복잡한 연산 과정을 거쳐 3D 정보를 얻을 수 있겠지만, 여러 부속품이 덕지덕지 붙어 있는 기기가 디자인 측면에서나 가격 면에서 소비자들의 눈길을 끌기는 쉽지 않을 것이다.

Time-of-Flight

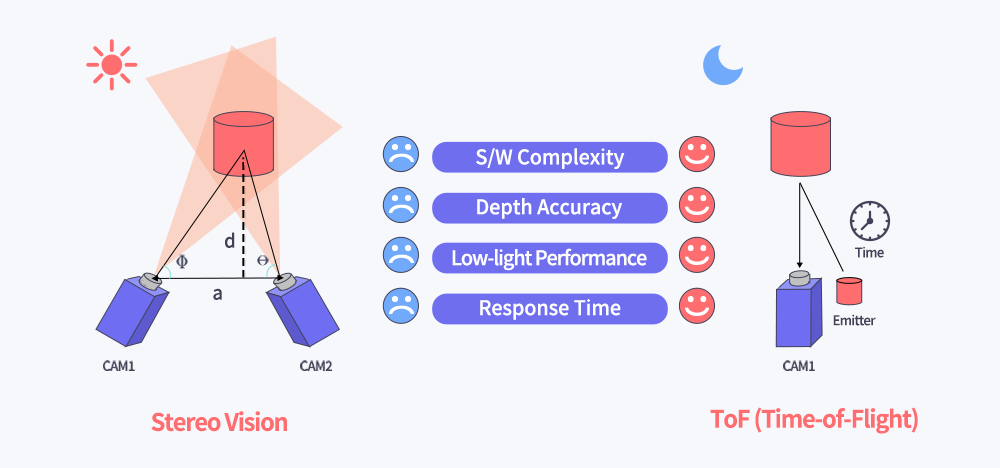

▲ (그림 3) 스테레오 비전과 ToF의 사물 인식 방법 비교

2개의 눈과 두뇌를 가진 사람은 사물을 입체적으로 인지하고 원근감을 구분할 수 있다. 이처럼 기계에도 2개의 카메라와 프로세서를 활용한 ‘스테레오 비전(Stereo vision)’과 같은 삼각 측량법(Triangulation)을 적용해, 사물을 입체적으로 인식하고 거리를 측량할 수 있다.

다만 연산이 복잡하고 평면의 거리를 정확히 측정할 수 없는 점, 밝은 곳이 아니면 정확도가 떨어지는 점 등의 단점이 있어, 응용 분야의 폭은 좁을 수 있다.

이에 최근 이를 대체할 방안으로 ToF(Time-of-Flight) 기술이 많이 거론된다. ToF는 빛이 물체에 반사돼 돌아오는 시간으로 거리를 계산하는 간단한 원리를 활용해, 회로가 단순하고 처리속도가 빠르다. 또한 별도의 광원을 사용해 조도 환경과 관계없이 정확한 거리를 측정할 수 있는 장점도 있다.

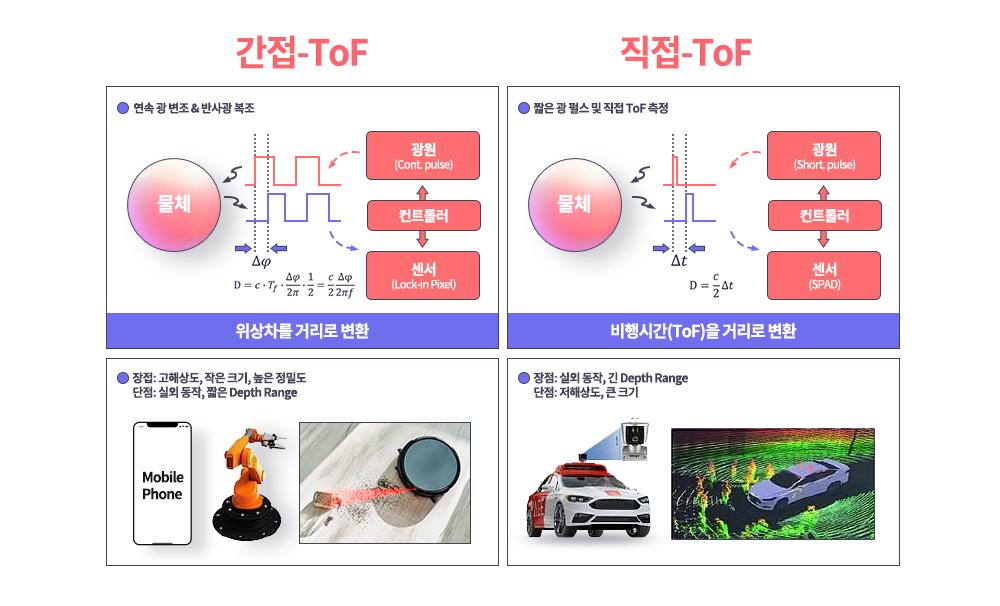

▲ (그림 4) I ToF와 D ToF 비교 분석

ToF는 빛이 물체에서 반사돼 돌아오는 시간을 기준으로 거리를 측정하는 Direct ToF(이하 D-ToF) 방식과 반사돼 돌아오는 위상 지연(Phase shift) 차이4)를 이용하여 거리를 측정하는 Indirect ToF(이하 I-ToF) 방식으로 구분된다.

미래의 로봇은 두 눈 중 하나를 근거리 및 사물 인식을 위한 I-ToF로 쓰고, 나머지를 장거리를 탐지하는 D-ToF로 사용할 수도 있다. 아니면 특정 방식 모두를 두 눈에 활용할 수도 있다. 이처럼 아직 미래의 로봇이 어떤 방식으로 사물을 인식할지 결정된 것은 아무것도 없다. 이에 SK하이닉스는 모든 가능성을 열어두는 측면에서 두 기술을 모두 개발하며, 다양한 제품에 활용될 수 있도록 준비하고 있다.

그중에서도 SK하이닉스가 개발 중인 I-ToF 기술에 대해 더 자세히 살펴보자. I-ToF 방식은 하나의 픽셀 안에 두 개 이상의 구분된 저장소를 두고, 각 저장소에 축적된 전하의 비율로 광원과의 위상 차이를 계산해 거리를 계산한다. 이때 거리가 멀어질수록 돌아오는 빛의 세기가 약해져 구분해야 할 신호가 줄어들기 때문에, 측정 거리는 D-ToF에 비해 한계가 있다. 하지만 픽셀 스스로 신호를 구분할 수 있는 만큼 회로는 단순해 픽셀 소형화에 유리하고 D-ToF에 비해 해상도가 높은 장점이 있다.

이러한 단점을 보완하고 장점을 극대화하기 위해 SNR(Signal to Noise Ratio)을 개선 중이며, 적외선(Infrared Ray, 이하 IR) 광원의 QE(Quantum Efficiency)5) 증가, 외광(BGL, Background Light) 제거 기술 등 많은 연구가 진행 중이다.

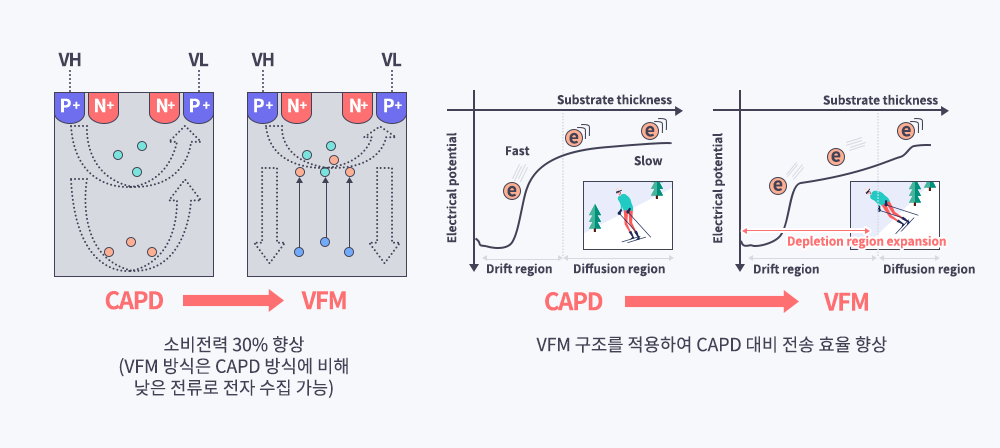

현재 I-ToF 픽셀의 구조는 크게 게이트 구조와 확산(Diffusion) 구조로 구분할 수 있다. 게이트 구조는 포토게이트에 변조 전압6)을 인가해 만들어진 전위 차이7)를 이용해 주변의 전자를 수집하는 방식이다. 확산 구조의 대표적인 방식은 CAPD(Current Assisted Photonic Demodulator)로, 기판에 변조 전압을 인가해 발생한 전류로 전자를 수집하는 방식이다. 후자의 경우 전자보다 상대적으로 더 깊은 곳에 형성된 전자들을 빠르게 검출할 수 있어 전송 효율이 높지만, 전류를 이용해야 해 전력소모가 크다는 단점이 있다. 또한 해상도를 높이기 위해 픽셀 크기가 줄고 개수가 많아져 전력소모는 더 증가하게 된다.

SK하이닉스에서는 CAPD의 장점을 극대화하고 단점을 최소화하기 위해 VFM(Vertical Field Modulator)이라는 새로운 구조로 10um QVGA8)급, 5um VGA급 픽셀 기술 개발을 완료했다.

4) 위상 지연(Phase shift) 차이: 광원에서 물체로 보낸 빛의 파장과 물체에 반사돼 센서로 돌아온 빛의 파장 사이의 차이.

5) QE: Quantum Efficiency, 흡수된 광자와 전환된 전자의 비율.

6) 변조 전압: 신호를 구분하기 위해 픽셀 내부의 노드를 스위칭시키는 전압.

7) 전위 차이: 전계에 생긴 전기적 위치 에너지 차이, 에너지가 높은 쪽으로 전자가 이동하는 성질이 있다.

8) QVGA: 픽셀의 해상도를 의미하는 표기. QVGA는 320X240, VGA는 640×480를 각각 의미한다.

VFM Pixel 기술의 장점

좋은 거리 센서의 조건은 여러 가지가 있겠지만, 무엇보다 거리를 정확히 감지해야 하고, 발열 이슈가 발생하지 않도록 전력소모를 낮추는 것도 중요할 것이다. 즉, 낮은 전력으로도 높은 효율로 빠르게 신호들을 검출할 수 있어야 하고, 검출된 신호를 위상 지연에 맞게 정확히 구분할 수 있어야 한다.

1. SK 하이닉스의 CIS 후면 조사 기술과 결합

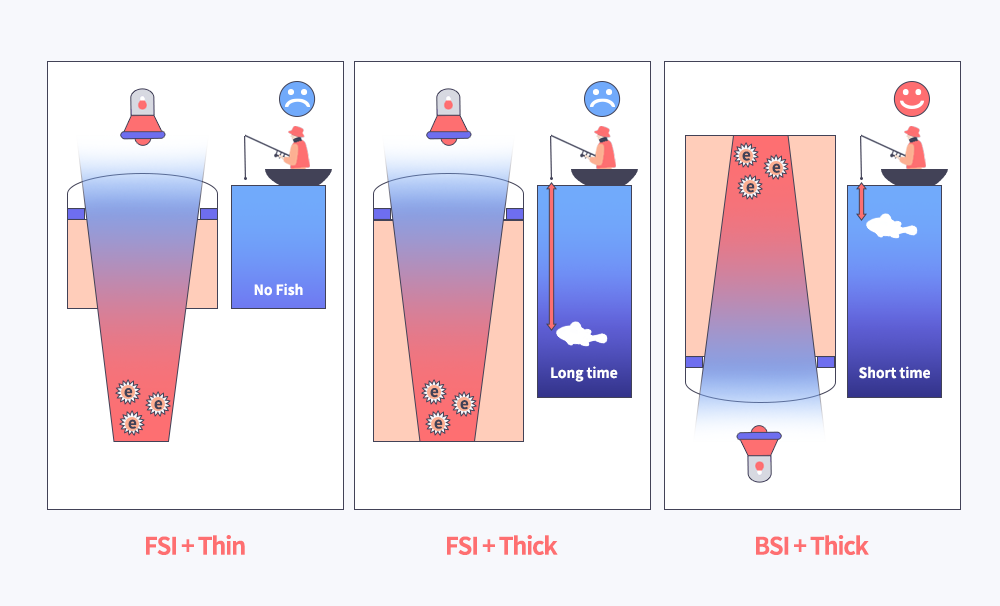

▲ (그림 5) 전면 조사와 후면 조사 비교

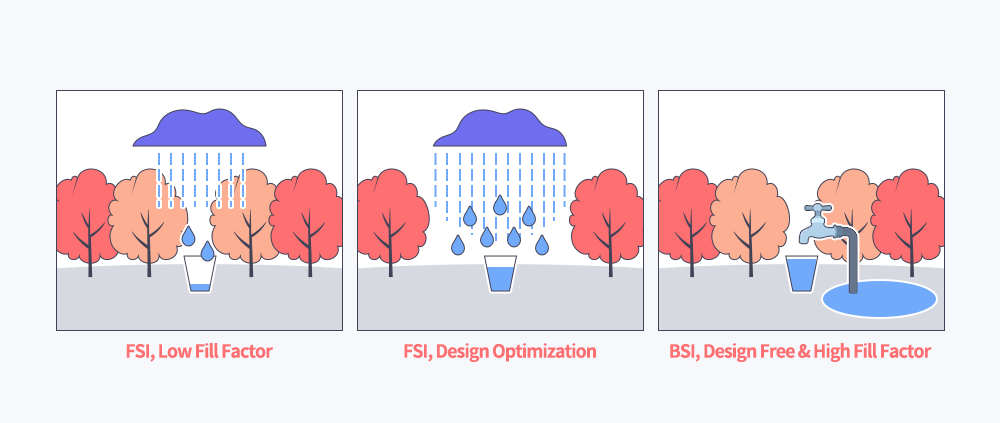

ToF도 CIS처럼 후면 조사9) 공정이 설계나 성능 면에서 장점이 많다. 비행시간 계산을 위해 사용하는 광원은 사람 눈에 보이지 않아야 하고 저조도에서도 정확히 거리를 계산할 수 있어야 해, IR을 사용한다. IR은 가시 광에 비해 장파장 대역인 만큼 CIS보다 두꺼운 웨이퍼를 사용하지 않으면 빛이 대부분 투과돼 픽셀 안에 생성되는 신호의 양이 매우 적어진다.

그렇다고 무한정 두께만 늘릴 수는 없다. 낚시터보다 심해에 사는 물고기를 잡기 힘든 것처럼 깊이 생성된 전자들을 빠르게 수집하기는 어려운 일이다. 전면 조사10) 대신 후면 조사를 하면 빛이 반대로 들어가 낚싯줄 역할을 하는 전기장이 강한 영역에 가까이 집광 돼, 쉽고 빠르게 신호를 검출할 수 있다. (그림 5 참조)

▲(그림 6) 조사 방식에 따른 I-ToF의 전하 축적 비율 원리

그리고 I-ToF의 성능은 전하 축적 비율의 원리에 따라 신호를 얼마나 잘 구분 하느냐에 있는데, 전면 조사의 경우 빛이 픽셀 표면을 지나는 과정에서 위상 차이를 무시하고 바로 검출 노드(node)에 들어갈 확률이 높아 거리 오차가 발생할 수가 있다.

또한 후면 조사가 가능해지면서 전면 조사에서 높은 Fill Factor11)를 확보하기 위해 많은 제약을 걸어 뒀던 금속 배선의 자유도가 높아졌다. 수풀이 우거진 곳에서 직접 빗물을 받기 위해 나무들을 베어내는 것보다 지하수를 퍼 올리는 것이 효과적으로 물을 얻을 수 있는 것과 같은 원리다. (그림 6 참조)

1um(1/1000mm) 이하 크기의 픽셀 기술을 보유한 SK하이닉스의 CIS 후면 조사 공정 기술을 접목함으로써 이러한 장점을 실현할 수 있었다.

9) 후면 조사: Back Side Illumination, 위에서부터 아래로 ulens – color filter – PD – metal 순으로 쌓아 CIS를 만드는 공정 방식. FSI + Light Guide를 이용하는 것보다 집광 효율이 훨씬 좋은 장점을 지닌다.

10) 전면 조사: Front Side Illumination, 위에서부터 아래로 ulens – color filter – metal – PD 순으로 쌓아 CIS를 만드는 공정 방식.

11) Fill Factor: 센서의 각 Pixel에서 전체영역에 대한 활성영역(포토다이오드)의 비율.

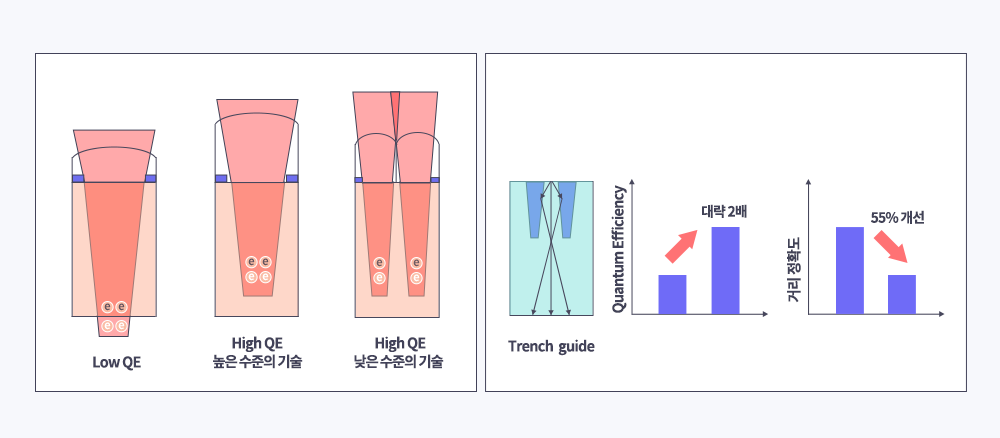

2. SLA 및 Trench guide 구조와 QE

▲ (그림 7) SLA / Trench Guide

전하 축적 비율을 이용하는 I-ToF의 원리에 맞게 더 먼 거리까지 정확한 거리 정보를 얻기 위해서는 최대한 많은 신호가 필요다. 이를 위해서는 IR 파장대12)의 높은 QE가 필수적이다.

앞선 설명과 같이 IR 광원의 높은 투과율로 인해 집광 거리가 깊어, 가시 광에 비해 상대적으로 빛의 세기가 약하다. 더 많은 양의 빛을 모으려면 일부러 마이크로 렌즈13) 구조를 높게 형성하면 되지만, 기술적인 한계로 높이에 제한이 있다.

이에 SK하이닉스는 다른 접근방식으로 단점을 보완했다. 픽셀 크기보다 작은 렌즈 여러 개를 하나의 픽셀에 올려 집광 깊이를 끌어 올림으로써 전체적으로 빛을 받는 양을 증가시킨 것. 또한 후면에 특수 패턴 구조물을 파, 입사된 빛이 구조물을 맞고 반사되도록 했다. 이를 통해 빛의 투과 경로를 길게 늘이고 빛을 변조 영역으로 집중시켜, 동일한 빛의 세기에서 집광 된 빛의 손실률을 줄이고 전송 효율을 높이는 일석이조의 효과를 얻었다.

이때 실제로 940nm 광원에서 QE가 2배 이상 상승하는 것을 확인했고, QE가 높아진 만큼 실제 거리와 측정 거리 간의 오차도 기존 대비 55% 줄였다.

12) IR 파장대: 750nm~1mm의 파장 영역에 속한 파장대. ToF에서는 850nm/940nm 광역대를 주로 이용한다.

13) 마이크로 렌즈: 카메라 렌즈 아래 픽셀 크기와 개수에 맞춰 배열된 작은 크기의 렌즈.

ToF 센서는 광원의 전력을 제외하면 동작 시간 동안 신호를 변조하는 회로에서 가장 많은 전력을 소비한다. 변조 드라이버 회로의 전력은 기판에 흐르는 전류에 비례해, 기판 전류를 줄여야 소비 전력도 감소시킬 수 있다.

▲ (그림 8) ToF 센서 전력 효율적인 소모에 CAPD보다 유리한 VFM

이에 더해 정확하고 세밀하게 거리를 계산하려면 변조 주기가 짧아야 하고, 그만큼 빠른 속도로 신호를 검출할 수 있어야 한다. 자동차(광자, Photon)가 동일한 거리(기판 두께, Si Thickness)를 더 빠르게 달리려면 엑셀을 최대한 밟아 속도를 내는 방법밖에 없는데, 그만큼 연료(전류, Current)를 많이 소비하게 된다. 또 다른 예로 깊은 우물에 물을 퍼 올리기 위해서는 많은 힘을 들여 도르래를 올려야 하지만, 펌프로 지하수를 끌어올 수 있다면 간단히 수도꼭지만 틀어 힘들이지 않고 원하는 만큼의 물을 얻을 수 있다. VFM 방식은 바로 이 펌프 같은 역할을 수행한다.

VFM 방식은 픽셀 이온 주입 조건과 구조를 최적화해 공핍영역(Depletion Region)14)을 늘리고 수직 전계(Vertical Electric Field)를 강화했다. 그 결과 전류 외에 전계의 힘이 더해져 효과적으로 전자들을 수집할 수 있게 됐고, 전류를 줄여도 충분히 빠르게 빛을 수집할 수 있게 돼 전력도 덜 소모하게 됐다.

SK하이닉스는 수많은 실험을 통해 전류가 증가할수록 오히려 성능이 열화되는 VFM 픽셀의 특성을 확인했고, VFM 픽셀은 전류를 주요 인자로 고려할 필요 없는 저전력에 특화된 구조라는 결론을 내렸다. 즉, 전류가 단순한 가이드 역할만 하도록 제어하고 강한 수직 전계를 구현할 수 있는 디자인을 확보함으로써 픽셀 성능을 향상할 수 있게 된 것. 5um VGA급 ToF 센서의 경우 픽셀 크기가 줄고 해상도가 증가했음에도 QVGA급 ToF 센서 대비 단위 픽셀당 전류의 양이 오히려 줄어 전력소모가 거의 증가하지 않았다.

14) 공핍영역: PN 접합에 역방향 전압을 걸면 P측에 있는 홀(Hole)과 N측에 있는 전자는 접합 부분에서 멀어진다. 그리고 접합 부근에는 캐리어가 매우 적은 부분이 생기는데 이것을 공핍층이라고 한다.

SK하이닉스는 ToF 기술 개발하면서 동시에 여러 모듈 업체에 기술을 지원하고 센서를 제공해 다양한 애플리케이션 시장에 진입할 수 있게 도와줌으로써 경제적/사회적 가치 창출에도 이바지하고 있다.

SK하이닉스가 Depth Solution Technology로 AR/VR 기기를 통해 세계여행을 하고, 드론이 배달한 소포를 가정용 안드로이드가 가져오고, 로봇 청소기에 집안 정리를 맡긴 후 안면인식만으로 문이 열리는 자율주행차에서 뉴스를 보면서 출근하는 미래를 우리 일상으로 가져오기를 기대하며, 이 글을 마친다.

<참고문헌 및 사이트>

R. Lange, P. Seitz, A. Biber, and R. Schwarte, “Time-of-flight range imaging with a custom solid-state image sensor,” in Proc. SPIE, Laser Metrology and Inspection, Munich, Germany, 1999, vol. 3823.

David Stoppa et al.,“A Range Image Sensor Based on 10-um Lock-In Pixels in 0.18um CMOS Imaging Technology,” IEEE J. solid-state circuit, vol. 46, no. 1, pp. 248-258, Jan. 2011.

Cyrus S. Bamji et al.,“A 0.13um CMOS System-on-chip for a 512×424 Time-of-Flight Image Sensor With Multi-Frequency Photo-Demodulation up to 130MHz and 2GS/s ADC,” IEEE J. solid-state circuit, vol. 50, no. 1, pp. 303-319, Jan. 2015.

Yuich Kato et al.,“320×240 Back-Illuminated 10-um CAPD Pixels for High-Speed Modulation Time-of-Flight CMOS Image Sensor,” IEEE J. Solid-State Circuits, VOL. 53, NO. 4, pp1071-1078, Apr. 2018.

L. Pancheri et al.,“Current Assisted Photonic Mixing Devices Fabricated on High Resistivity Silicon,” SENSORS, IEEE, pp981-983, Oct. 2008.

Y. Ebiko et al.,“Low power consumption and high resolution 1280×960 Gate Assisted Photonic Demodulator pixel for indirect Time of flight,” 2020 IEEE International Electron Devices Meeting (IEDM), 2020, pp. 33.1.1-33.1.4

JH. Jang et al.,“An Ultra-low current operating 5-μm Vertical Field Modulator Pixel for in-direct Time of Flight 3D Sensor.,” 2020 International Image Sensor Workshop(IISW), Sep. 2020.