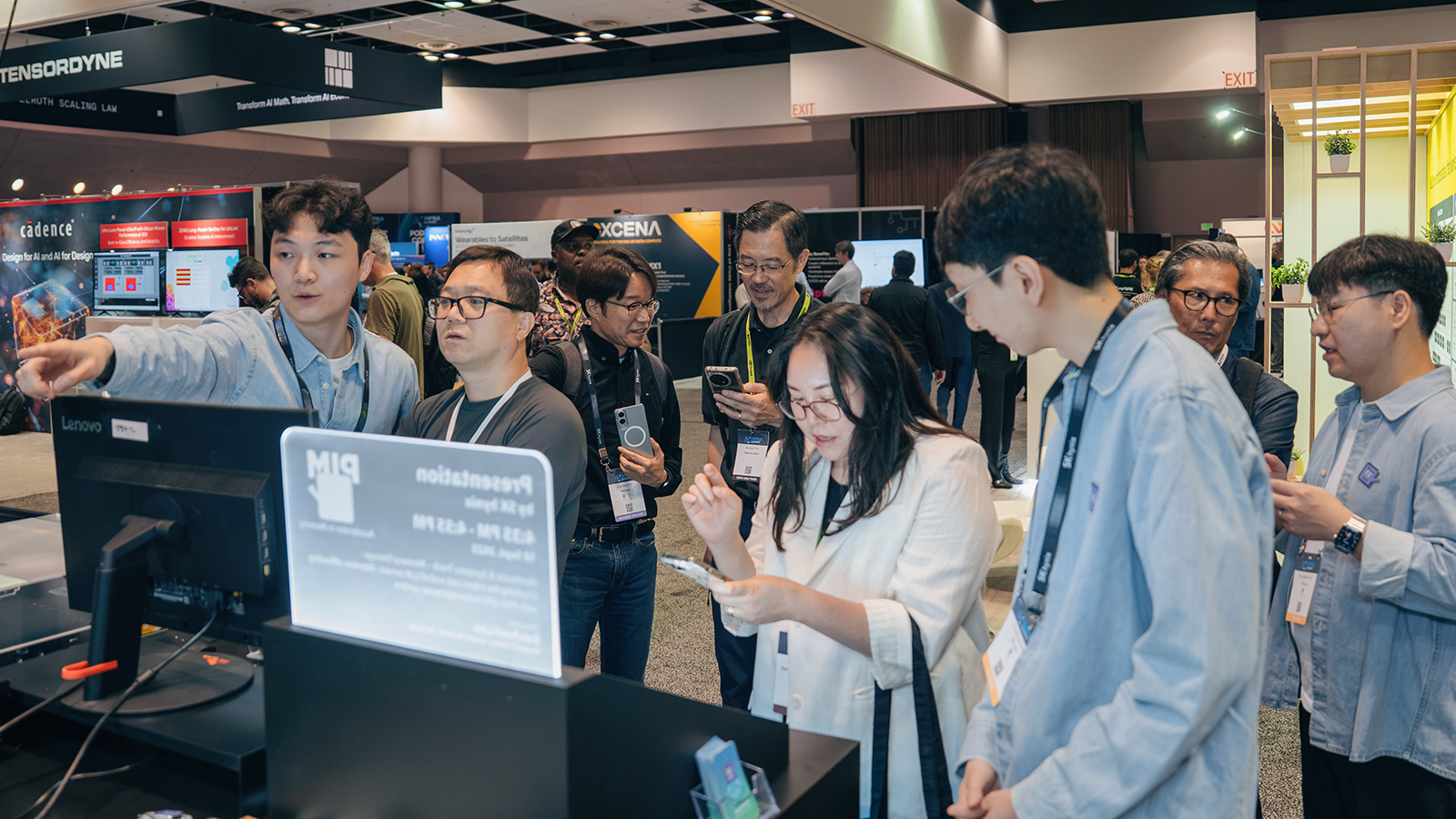

SK하이닉스가 지난 9일부터 11일까지(미국시간) 미국 캘리포니아주 산타 클라라(Santa Clara)에서 열린 AI Infra Summit 2025에 참가해 차세대 AI 메모리 ‘AiM*’ 기반 설루션을 선보이며 미래 AI 서비스를 선도할 기술력을 입증했다.

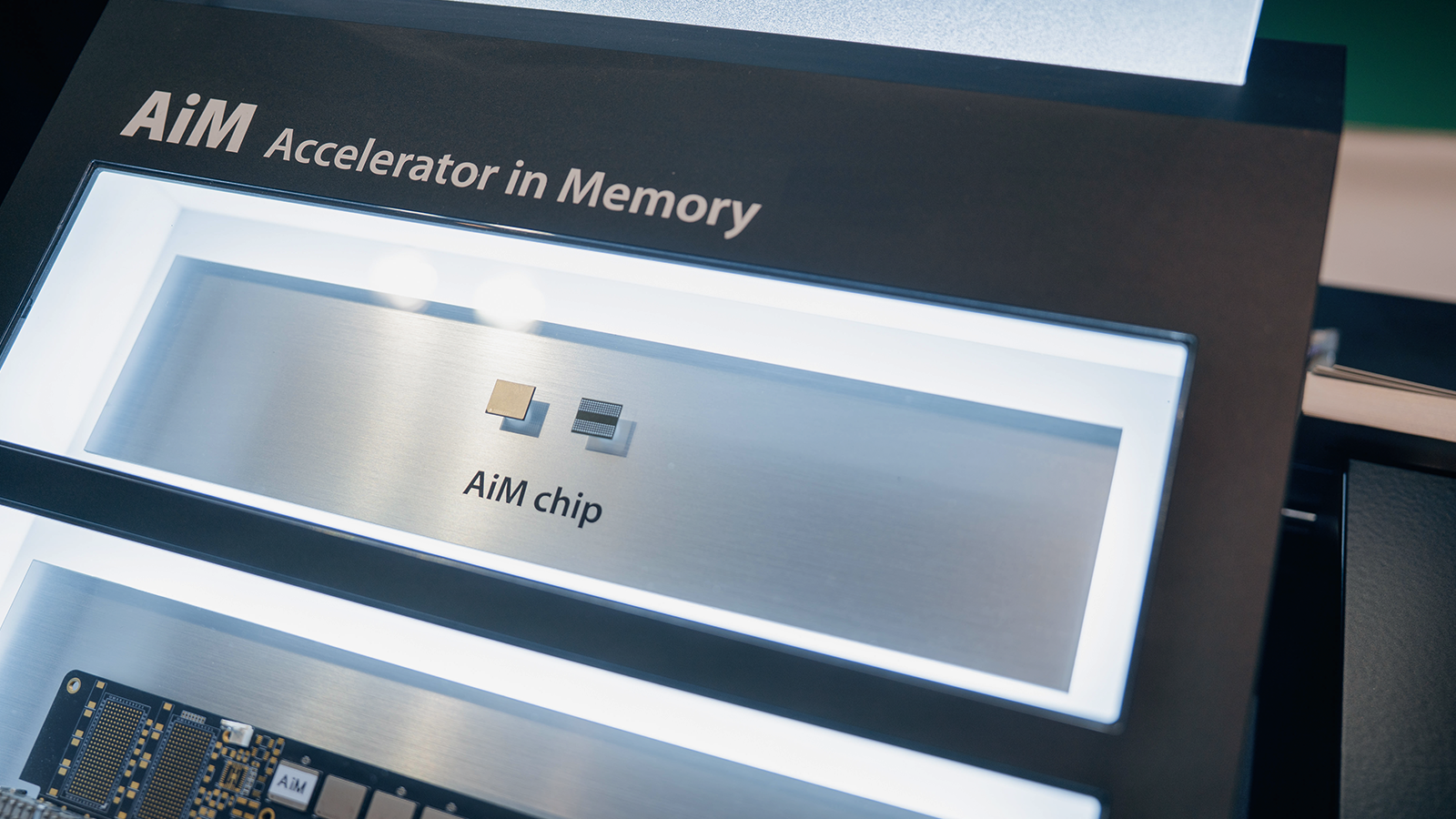

* AiM(Accelerator-in-Memory): SK하이닉스의 PIM 반도체 제품명, GDDR6-AiM이 이에 포함됨

AI Infra Summit 2025는 글로벌 AI 업계의 주요 기업과 연구 그룹이 최신 하드웨어(Hardware)와 소프트웨어(Software) 인프라 기술을 공유하고 시연하는 자리다. 기존의 AI Hardware & Edge AI Summit을 리브랜딩한 행사로, ‘Powering Fast, Efficient & Affordable AI(빠르고, 효율적이며, 경제적인 AI 구현)’란 슬로건 아래 3,500명 이상의 전문가와 100여 개 글로벌 기업이 참여했다.

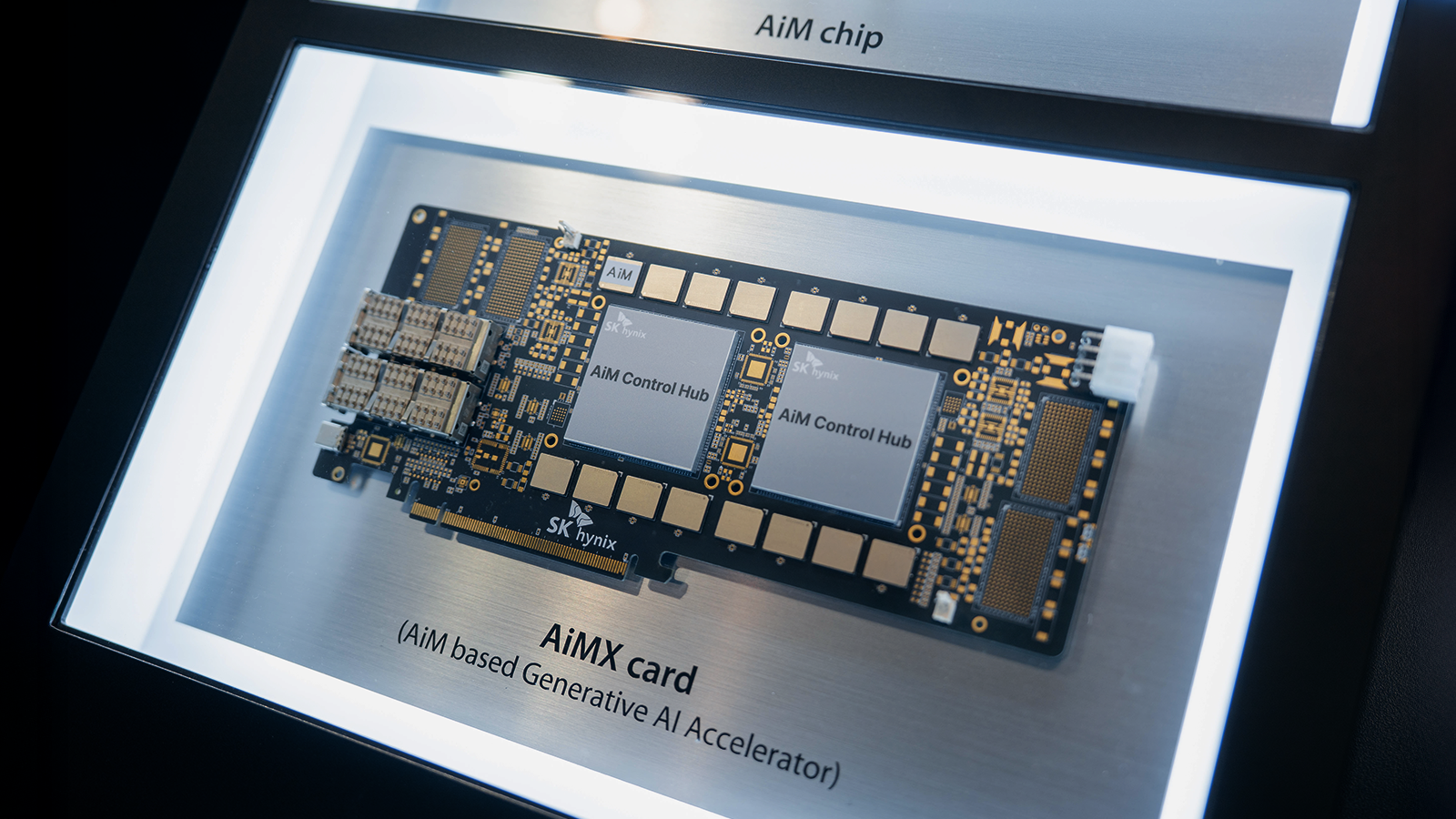

SK하이닉스는 골드 스폰서로 참가해 PIM* 기술 기반의 AiM을 이용한 설루션을 집중적으로 선보였다. 부스는 ‘Boost Your AI: AiM is What You All Need(당신의 AI를 강화하라: AiM이 바로 해답이다)’라는 주제로 구성됐으며, AiMX* 카드 4개와 엔비디아(NVIDIA) H100 GPU 2개가 장착된 슈퍼마이크로 서버(Supermicro SYS-421GE-TNRT3)를 기반으로 라이브 데모가 진행됐다. 방문객들은 실제 환경에서 시스템 성능을 직접 체험하며 AiM 제품의 기술력과 차별성을 확인했다.

* PIM(Processing-In-Memory): 메모리 반도체에 연산 기능을 더해 인공지능(AI)과 빅데이터 처리 분야에서 데이터 이동 정체 문제를 풀 수 있는 차세대 기술

* AiMX(AiM based Accelerator): GDDR6-AiM 칩을 사용해 대규모 언어 모델(Large Language Model, 대량의 텍스트 데이터로 학습하는 인공지능으로 챗GPT가 이에 해당)에 특화된 SK하이닉스의 가속기 카드 제품

▲ SK하이닉스가 전시한 AiM 솔루션 데모

데모의 핵심은 LLM* 서비스에서 발생하는 메모리 월* 현상의 해소였다. 기존 GPU 단독 시스템은 컴퓨트 바운드* 연산과 메모리 바운드 연산*을 모두 GPU에서 처리한다. 이는 시스템에 대한 사용자의 요청이 증가하고 각 요청의 문맥이 길어질수록 효율성이 떨어지는 문제로 이어진다. 그에 비해 AiMX 기반의 디스어그리게이티드 시스템*은 메모리 바운드 연산을 AiMX에서 분담해, GPU가 연산 성능에 집중할 수 있도록 설계됐다. 때문에 더 많은 요청을 동시에 처리할 수 있으며, 긴 문맥도 안정적으로 다룰 수 있다.

* LLM(Large Language Model-대규모 언어 모델): 방대한 데이터를 학습해 자연어를 이해하고 생성하는 인공지능 모델

* 메모리 월(Memory Wall): 데이터 처리 속도에 비해 메모리 접근 속도가 느려 발생하는 성능 한계

* 컴퓨트 바운드(Compute-bound): 연산 능력이 전체 처리 속도를 결정하는 상태

* 메모리 바운드(Memory-bound): 메모리 접근 속도가 전체 처리 속도를 결정하는 상태

* 디스어그리게이티드 시스템(Disaggregated System): 서로 다른 종류의 프로세싱 유닛(Processing Unit)으로 시스템을 구성해 연산 작업을 이원화하는 구조

회사는 소프트웨어 측면에서의 개선도 선보였다. AI 서비스 개발에 널리 사용되는 프레임워크 vLLM*을 활용해 AiM 기반 설루션의 기능을 강화했으며, 복잡한 추론 과정을 거치는 리즈닝 모델*에서도 긴 토큰 생성을 안정적으로 지원한다.

이러한 설계 및 최적화 덕분에 AiM 기반 설루션은 LLM 서비스 운영에서 발생하는 비용, 성능, 전력 소모 문제를 동시에 개선하며 GPU 단독 시스템 대비 운영비 절감 효과도 제공할 수 있다.

* vLLM(Virtual Large Language Model): 대규모 언어 모델 추론을 최적화하고 성능을 높이는 AI 프레임워크

* 리즈닝 모델(Reasoning Model): 단순 응답을 넘어 논리적 추론을 수행하는 고급 AI 모델

▲ AI Infra Summit 2025에서 발표를 진행하는 SK하이닉스 임의철 부사장(Solution AT 담당)

행사 둘째 날에는 SK하이닉스 임의철 부사장(Solution AT 담당)이 ‘Memory/Storage: Crushing the token cost wall of LLM service: Attention offloading with PIM-GPU heterogeneous system(LLM 서비스의 토큰 비용 벽을 허무는 메모리·스토리지 혁신: PIM-GPU 이기종 시스템의 Attention offloading*)’을 주제로 발표를 진행했다. 임 부사장은 LLM 서비스의 토큰 처리 비용을 획기적으로 줄일 수 있는 새로운 접근법을 공유하며, AI 메모리 기술이 산업 혁신의 동력이 될 수 있음을 강조했다.

* Attention offloading: LLM이나 트랜스포머 모델에서 어텐션 연산의 일부를 메모리 외부 장치로 분산하거나 캐싱하여, GPU나 메인 메모리의 부담을 줄이는 기술

SK하이닉스는 “이번 행사는 하드웨어부터 데이터센터, 엣지 AI까지 확장된 AI 인프라의 현주소를 보여준 자리였다”며 “회사는 앞으로 차세대 AI 메모리 설루션을 통해 미래의 AI 서비스가 직면한 과제를 풀어낼 수 있는 기술력을 지속적으로 선보이겠다”고 밝혔다.