SK하이닉스가 지난 12일부터 17일까지 미국 콜로라도주 덴버에서 열린 ‘슈퍼컴퓨팅 2023(Supercomputing 2023, 이하 SC23)’에 참가해 인공지능(Artificial Intelligence, AI) 및 고성능 컴퓨팅(High-Performance Computing, HPC) 솔루션을 선보였다.

미국 컴퓨터 학회(Association for Computing Machinery, ACM)와 IEEE 컴퓨터 학회(IEEE Computer Society)가 1988년부터 연례행사로 열고 있는 슈퍼컴퓨팅(SC) 콘퍼런스는 HPC, 네트워킹, 스토리지 그리고 데이터 분석 분야의 최신 기술을 공유하는 자리다.

SK하이닉스는 올해 처음으로 SC23에 참가해 제품 시연과 함께 다양한 주제로 발표를 진행했다.

▲ ‘슈퍼컴퓨팅 2023’ 행사에 마련된 SK하이닉스 부스

획기적인 HPC 및 인공지능 제품 선보여

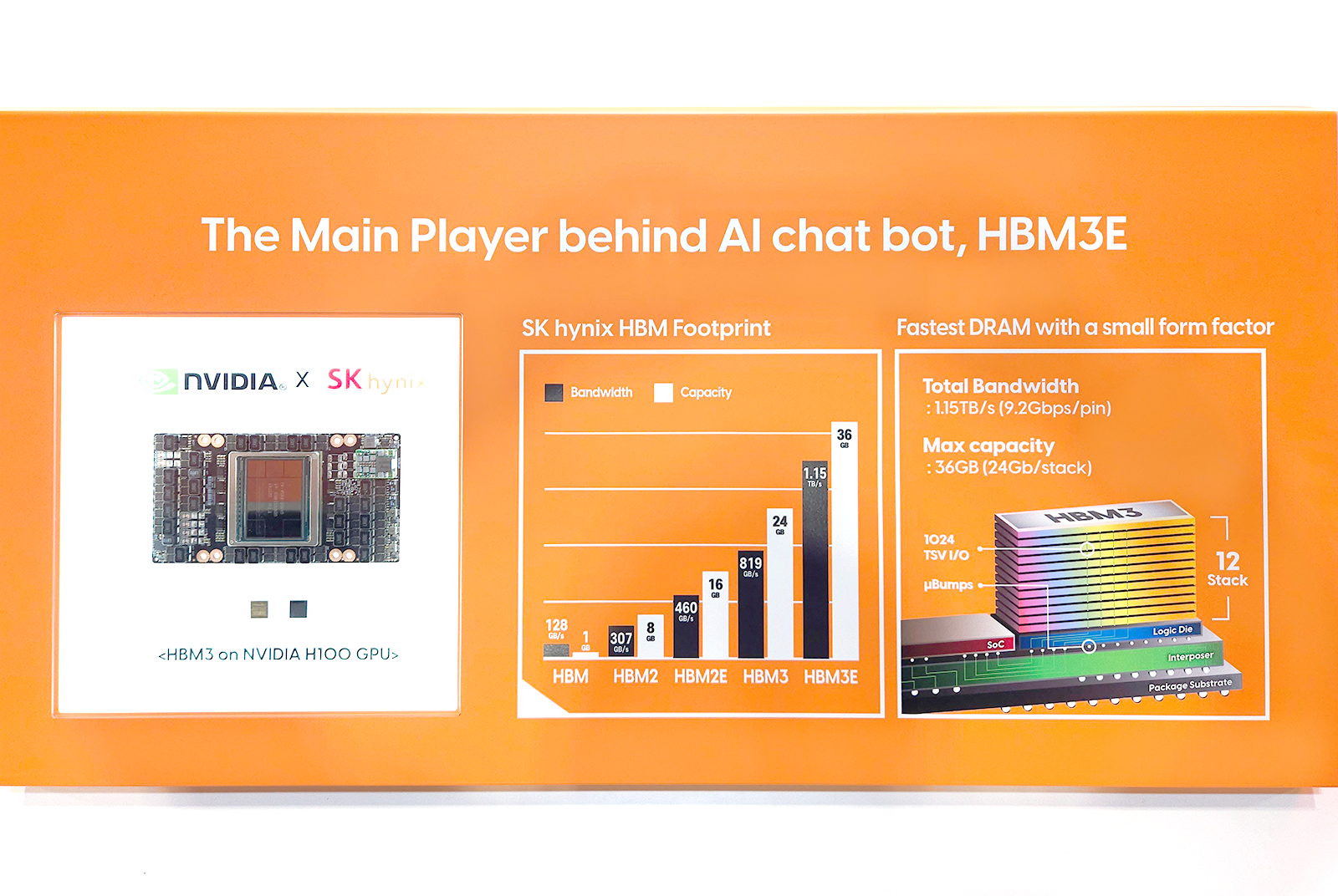

SK하이닉스 부스에는 AI 메모리 기술 리더십을 공고히 하기 위한 다양한 차세대 제품이 전시됐다. 특히, AI와 HPC에 특화된 HBM3E[관련기사]는 속도와 용량, 방열성, 전력 효율 등에서 업계 최고 수준을 구현한 고대역폭 메모리(HBM*) 솔루션으로 많은 관심을 받았다. 특히 HBM3E는 SK하이닉스의 HBM3가 적용된 AI용 고성능 그래픽처리장치(Graphic Processing Unit, GPU)인 엔비디아 H100과 함께 전시됐다.

* HBM(High Bandwidth Memory): 여러 개의 D램을 수직으로 연결해 기존 D램보다 데이터 처리 속도를 혁신적으로 끌어올린 고부가가치, 고성능 제품. HBM은 1세대(HBM)-2세대(HBM2)-3세대(HBM2E)-4세대(HBM3)-5세대(HBM3E) 순으로 개발됐다. HBM3E는 HBM3의 확장(Extended) 버전

▲ ‘슈퍼컴퓨팅 2023’ 행사 내 SK하이닉스 부스에 전시 중인 HBM3E

이와 함께, SK하이닉스는 생성형 AI 가속기*인 AiMX(AiM based Accelerator)*[관련기사]도 시연했다. AiMX는 대규모 언어모델(Large Language Model, LLM) 구현에 특화된 제품으로 PIM* 기반 GDDR6-AiM* 칩을 탑재했다. 이 제품은 기존 GPU 중심의 생성형 AI 시스템보다 AI 데이터 추론 시간을 대폭 단축하는 동시에 더 낮은 전력으로 구동 가능하다는 장점이 있다. 때문에 데이터 집약적인 생성형 AI 추론 시스템 발전에 핵심적인 역할을 할 것으로 기대되고 있다.

* 가속기(Accelerator): 각종 정보 처리와 연산에 특화 설계한 칩(Chip)을 사용해 만든 특수 목적의 하드웨어(Hardware) 장치를 통칭

* AiMX(AiM based Accelerator): GDDR6-AiM 칩을 사용해 대규모 언어 모델(Large Language Model, 대량의 텍스트 데이터로 학습하는 인공지능으로 챗GPT가 이에 해당)에 특화된 SK하이닉스의 가속기 카드 제품

* PIM(Processing-In-Memory): 메모리 반도체에 연산 기능을 더해 인공지능(AI)과 빅데이터 처리 분야에서 데이터 이동 정체 문제를 풀 수 있는 차세대 기술

* AiM(Accelerator-in-Memory): SK하이닉스의 PIM 반도체 제품명. GDDR6-AiM이 이에 포함된다.

▲ ‘슈퍼컴퓨팅 2023’ 행사 내 SK하이닉스 부스에 시연 중인 AiMX

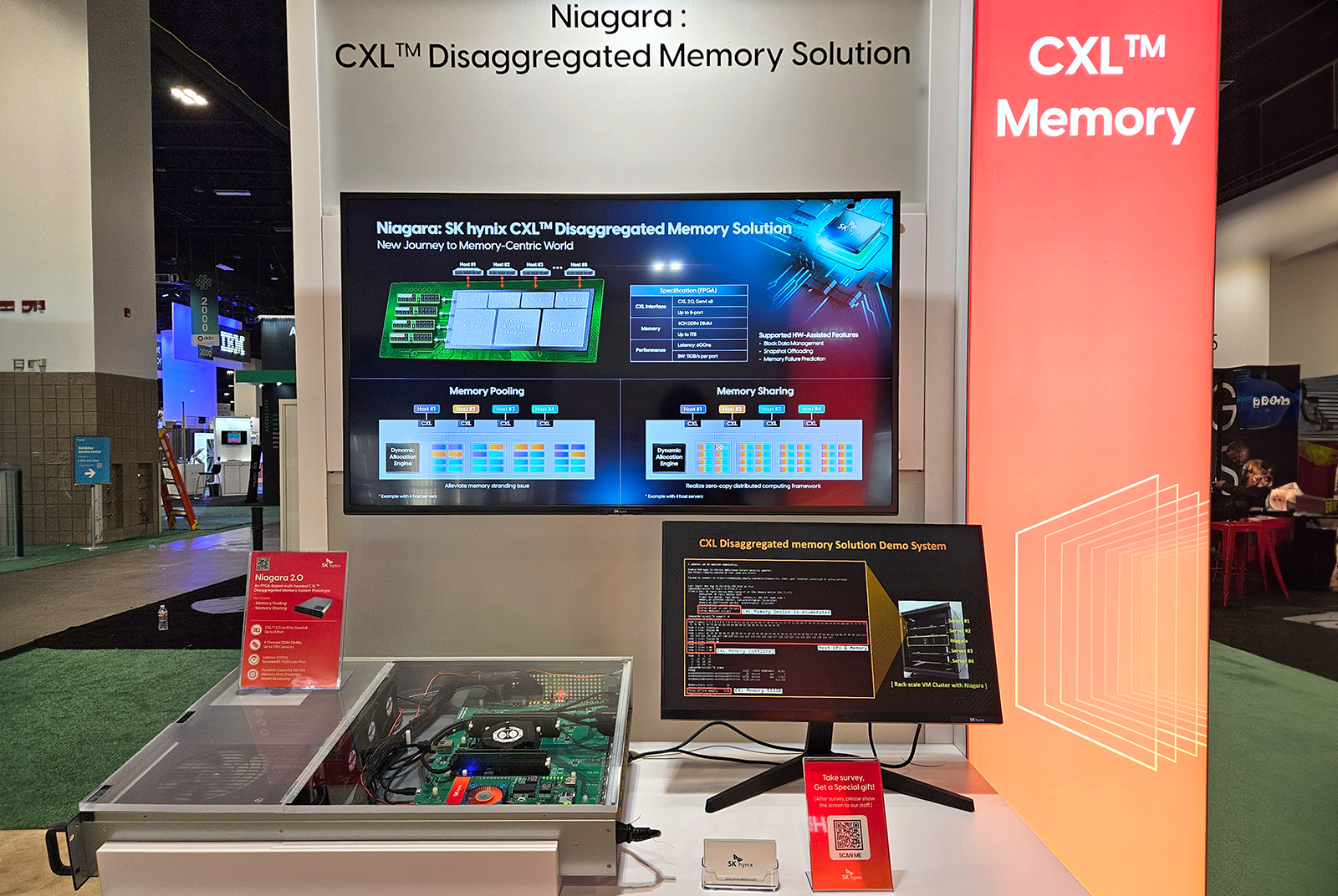

SK하이닉스의 CXL(Compute Express Link)* 역시 큰 관심을 받았다. CXL은 PCIe*를 기반으로 표준화된 인터페이스인데, 유연한 메모리 확장 기능을 통해 AI와 데이터 분석 등에 활용되는 HPC 시스템의 효율성을 극대화할 수 있다. 특히, 이번 SC23에서 공개한 ‘나이아가라(Niagara): CXL 분리형 메모리 솔루션’ 플랫폼 시제품은 AI와 빅데이터 분산처리 시스템에서 높은 수준의 성능 향상을 기대할 수 있는 풀드 메모리 솔루션(Pooled Memory Solution)*으로 호응을 얻었다.

* CXL(Compute Express Link): 고성능 컴퓨팅 시스템을 효율적으로 구축하기 위한 PCIe 기반 차세대 인터커넥트 프로토콜. 기존 D램 제품과 함께 서버 시스템의 메모리 대역폭을 늘려 성능을 향상하고, 쉽게 메모리 용량을 확대할 수 있는 차세대 메모리 솔루션

* PCIe(Peripheral Component Interconnect Express): 디지털 기기의 메인보드에서 사용되는 직렬 구조의 고속 입출력 인터페이스

* 풀드 메모리 솔루션(Pooled Memory Solution): 여러 개의 CXL 메모리를 묶어 풀(Pool)을 만들어 여러 호스트가 효과적으로 용량을 나누어 사용할 수 있도록 해 유휴 메모리가 없도록 사용량을 최적화하면서도 전력 소모를 줄여 비용 절감을 가능하게 하는 기술

▲ ‘슈퍼컴퓨팅 2023’ 행사 내 SK하이닉스 부스에 시연되고 있는 CXL 풀드 메모리 솔루션과 CXL 기반 CMS

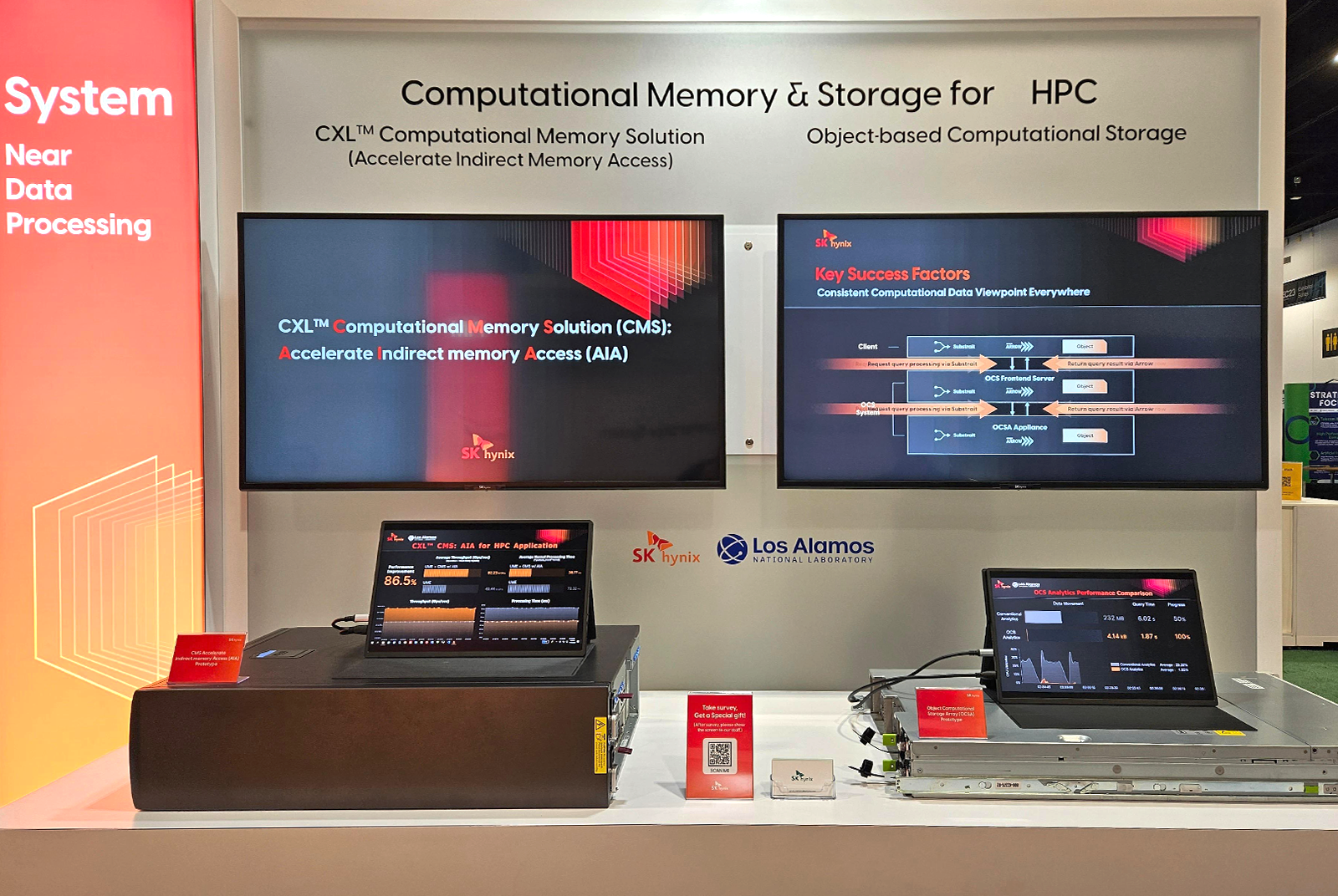

또, 회사는 CXL 기반 CMS(Computational Memory Solution)*도 선보였다. CMS는 미국 로스앨러모스 국립연구소(Los Alamos National Laboratory, LANL)*와 협업해 개발된 솔루션으로, HPC 물리 서버에 활용되는 응용 프로그램의 성능을 개선하고 에너지 사용량을 줄여준다. 또, 이 솔루션은 간접 메모리 접근을 가속화하는 동시에 데이터 이동을 크게 줄일 수 있는 기능을 갖추고 있다. 이 기술은 AI, 그래프 분석* 등 메모리 집약적인 다양한 영역에도 적용 가능할 것으로 회사는 기대하고 있다.

* LANL(Los Alamos National Laboratory): 미국 에너지부 산하 국립연구소로 국가안보와 핵융합 분야를 비롯해 우주탐사 등 다양한 분야의 연구를 하는 곳으로 특히 2차 세계대전 당시 맨해튼 프로젝트에 참여해 세계 최초로 핵무기를 개발한 곳으로 유명하다.

* CMS(Computational Memory Solution): 고용량 메모리를 확장할 수 있는 CXL의 장점에 빅데이터 분석 응용 프로그램이 자주 수행하는 머신러닝 및 데이터 필터링 연산 기능이 포함된 메모리 솔루션

* 그래프 분석(Graph Analytics): 개체 간의 관계구조로부터 개체들의 위치 특성을 추출하는 분석기법으로 빅데이터 대부분을 차지하는 이벤트 데이터와 시맨틱 네트워크 데이터를 처리하는 범용 기술

이와 함께, SK하이닉스는 LANL 등 여러 파트너와 함께 데이터 분석 성능을 높여주는 스토리지 장비인 객체 기반 컴퓨팅 스토리지(Object Based Computational Storage, OCS) 시스템도 전시했다. 이 시스템은 기존 데이터 분석을 위해 불러왔던 방대한 데이터를 줄이기 위해 스토리지 자체에서 데이터를 분석하고 그 결과를 서버에 전송하여 데이터 이동량을 최소화한다. 또, SK하이닉스는 이번 시연을 통해 회사의 인터페이스 기술이 OCS에서 데이터 처리 능력을 어떻게 향상할 수 있는지 보여주었다.

▲ ‘슈퍼컴퓨팅 2023’ 행사 내 SK하이닉스 부스에 시연 중인 객체 기반 스토리지 시스템(OCS)

혁신적인 데이터센터를 위한 eSSD 솔루션

또, SK하이닉스는 이번 행사에서 DDR5 RDIMM(Registered Dual In-line Memory Module)을 포함해 다양한 데이터센터 솔루션도 선보였다. DDR5 RDIMM은 5세대 10nm(나노미터) 공정 기술인 1b를 적용한 제품으로 업계 최고 수준인 초당 6,400Mb(메가비트)의 전송 속도를 지원한다. 이와 함께 최대 초당 8,800Mb의 데이터 처리 속도를 구현한 MRDIMM(Multiplexer Combined Ranks Dual In-line Memory Module)[관련기사]도 함께 전시되며 관심을 받았다.

마지막으로 최신 기업용 SSD(eSSD) 제품인 PCIe Gen5 기반 PS1010 E3.S와 PS1030 등의 제품도 만나볼 수 있었다. 이중 PS1030은 빅데이터와 머신러닝 등에 특화된 제품으로 초당 1만 4,800MB(메가바이트)의 순차 읽기 속도가 구현되며 이는 업계 최고 속도다.

▲ ‘슈퍼컴퓨팅 2023’ 행사 내 전시 중인 SK하이닉스의 MCR DIMM, PS1010, PS1030 등 최신형 데이터센터 솔루션 제품들

SK하이닉스 메모리 솔루션 기술력 공유

이번 행사에서는 전시 부스 외에도 SK하이닉스 구성원들이 발표를 통해 AI와 HPC용 메모리 솔루션의 기술력을 공유하는 시간을 가졌다. 우선 Solution개발 권용기 팀장이 ‘SK하이닉스의 AiM을 활용한 대규모 언어모델(LLM) 추론 솔루션으로 비용 효율 향상’을 주제로 발표했다. 권 팀장은 “오픈 AI의 GPT-3 모델의 대안으로 활용되고 있는 Meta의 OPT(Open Pretraining Transforer) 언어 모델에 AiM을 활용할 경우, 최신형 GPU를 활용한 시스템보다 최대 10배 빠른 속도를 달성함과 동시에 비용과 에너지 소비를 줄일 수 있다”고 밝혔다.

▲ AiM을 활용한 솔루션의 성능, 비용 절감, 에너지 소비 측면에서의 우수성에 대해 발표하고 있는 Solution개발 권용기 팀장

이어서 메모리시스템연구소 이호균 팀장이 ‘CXL 기반 AI와 HPC 서버의 작업량 분산을 위한 메모리 분리’를 주제로 발표를 진행했다. 이 팀장의 발표에 따르면 SK하이닉스의 나이아가라(Niagara) CXL 솔루션은 엘라스틱 메모리(Elastic Memory)* 기능으로 각각의 서버가 다른 서버에서 사용할 수 없었던 사용되지 않는 메모리(Stranded Memory)를 공유할 수 있어 기존 분산 컴퓨팅의 과도한 네트워크 트래픽을 해소하는 솔루션을 제공하게 된다. 또, 이 팀장은 챗GPT에서 사용되는 분산 AI 프레임워크인 레이(Ray)를 사용해 메모리 공유 기능을 시연하며 이 기술의 효율성을 보여줬다.

* 엘라스틱 메모리(Elastic Memory): 풀링된 메모리 등 여러 호스트에서 메모리를 공유할 때 서버에 필요한 용량을 조정해 주는 메모리 유형.

▲ 나이아가라(Niagara) CXL 솔루션의 효율성에 관해 설명하고 있는 이호균 팀장

마지막으로 메모리시스템연구소 김종률 팀장이 ‘HPC 서버에서 객체 기반 컴퓨팅 스토리지를 이용한 데이터 분석 가속화’에 관해 발표했다. 김 팀장은 SK하이닉스와 미국 로스앨러모스 국립연구소(LANL)의 협업 사례인 객체 기반 컴퓨팅 스토리지(Object-based Computational Storage, OCS)를 소개했다. 김 팀장은 “OCS는 HPC의 데이터 분석을 위한 새로운 컴퓨팅 스토리지 플랫폼으로, 높은 확장성과 데이터 인식 성능 덕분에 기존 데이터 처리 역할을 하는 컴퓨팅 노드의 도움 없이 스토리지가 스스로 데이터 분석을 수행하고 결과값만 전송할 수 있게 된다”고 강조했다.

▲ 객체 기반 컴퓨팅 스토리지(OCS)의 개념과 활용 가능성에 관해 설명하고 있는 김종률 팀장