SK하이닉스가 3일부터 양일간 서울 삼성동 코엑스에서 열린 ‘SK AI Summit 2025(이하 AI 서밋)’에 참가했다. ‘AI Now & Next(지금의 AI, 그리고 다음)’를 주제로 열린 이 행사에서 회사는 지난해 발표했던 ‘풀 스택 AI 메모리 프로바이더’ 비전을 ‘풀 스택 AI 메모리 크리에이터(Full Stack AI Memory Creator)’로 한 단계 확장하며, 차세대 AI 메모리 기술 전략과 로드맵을 공유했다.

AI 서밋은 SK그룹이 매년 개최해 온 ‘SK 테크 서밋’을 AI 중심으로 확대한 행사다. 올해 행사에서는 글로벌 AI 전문가와 산업 관계자들이 모여 AI 기술의 현재와 미래, 그리고 산업 전반의 활용 방안을 논의했다.

특히 SK 최태원 회장, SK하이닉스 곽노정 대표이사 사장, SK텔레콤 정재헌 대표이사 사장을 비롯해 오픈 AI CEO 샘 올트먼(Sam Altman), 아마존 CEO 앤디 재시(Andy Jassy) 등 글로벌 빅테크 리더들이 연설과 영상 메시지로 참여해 의미를 더했다. 엔비디아(NVIDIA), 아마존웹서비스(AWS), 구글(Google), TSMC, 메타(Meta) 등 글로벌 테크 기업과 국내 K-AI 얼라이언스 회원사들이 대거 참여해 AI 생태계 협력 방향을 공유했다.

올해 AI 서밋은 키노트 세션, 세션 발표, 전시 등으로 구성돼 AI 기술의 현재와 미래를 다각도로 논의하는 자리로 마련됐다. 이 가운데 SK하이닉스는 AI 인프라 혁신을 주도하는 기업으로서 AI 확산 시대에 요구되는 메모리 기술의 방향성과 산업 전반의 협력 비전을 제시하며 기술 리더십을 강조했다.

곽노정 대표이사 사장은 기조연설을 통해 AI 확산 속에서 변화하는 메모리 산업의 역할과 발전 방향을 짚으며 큰 주목을 받았다. 이와 함께 김호식 부사장(Memory System Research 담당)은 키노트 세션 내 패널 토의에 참여해 AI 인프라 병목의 해법과 메모리 중심 아키텍처의 중요성에 대해 논의했다. 또, 박경 부사장(Biz. Insight 담당)과 주영표 부사장(System Architecture 담당), 외부 연사인 버지니아대학교 이규상 교수는 각각 SK하이닉스가 주관한 세션 발표를 통해 차세대 AI 메모리 기술과 인사이트를 공유하며 회사의 기술 리더십을 입증했다.

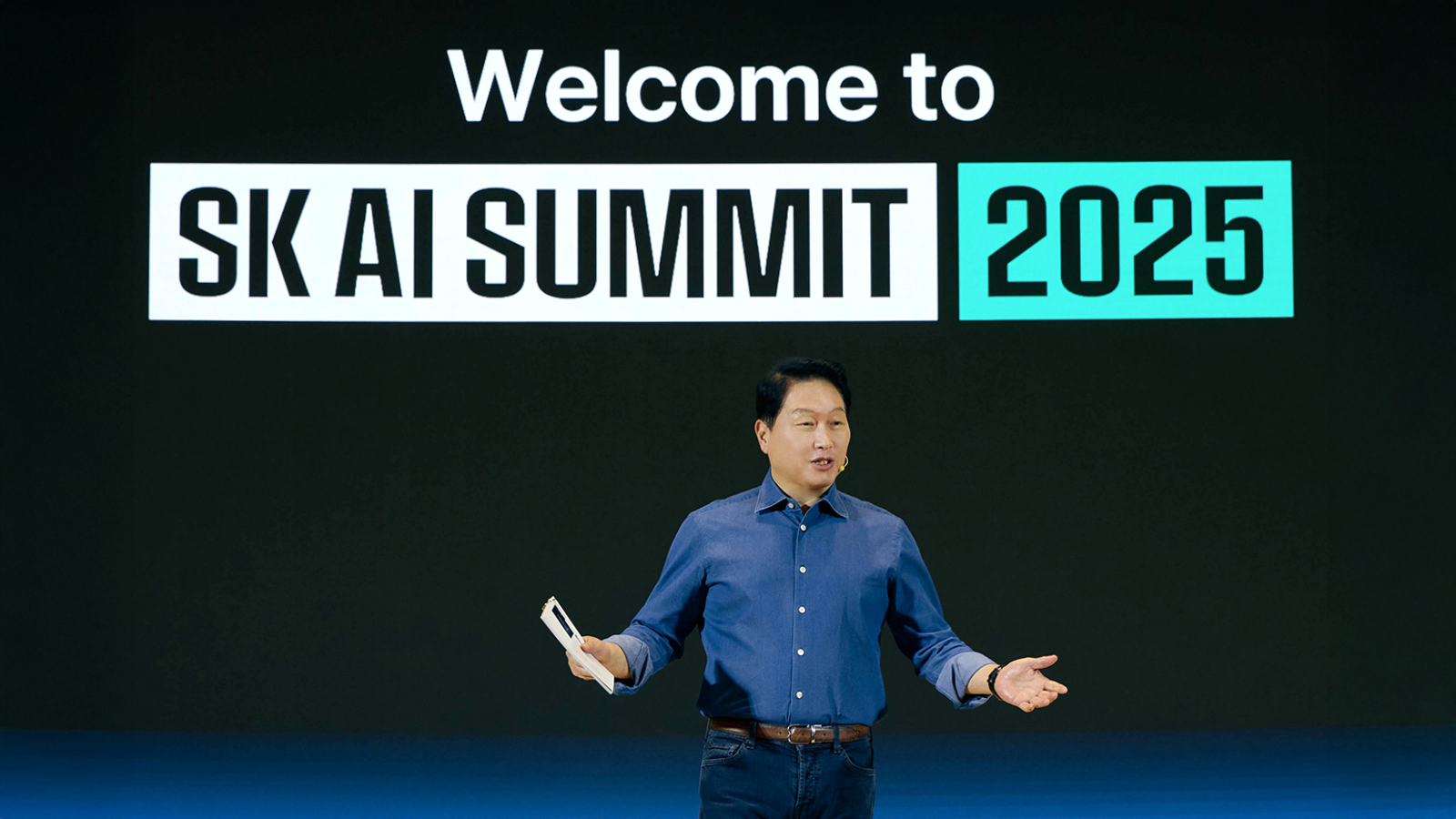

이날 최태원 회장은 ‘AI Now & Next’라는 주제를 통해 AI 시대의 다음 단계를 향한 담론을 제시하며 행사의 포문을 열었다. 최 회장은 “AI 산업은 이제 확장의 경쟁을 넘어 효율의 경쟁 단계로 접어들었다”며 폭발적인 AI 수요에 대응하기 위한 SK의 역할로 ‘가장 효율적인 AI 설루션 제공’을 꼽았다. 이어 최 회장은 “SK AI 전략의 핵심은 파트너와 공동으로 설루션을 설계하고 발전해 가는 것”이라며 “SK는 파트너와 경쟁하지 않고, 빅테크와 정부, 스타트업 등 여러 파트너와 AI 사업 기회를 만들어 최고 효율의 AI 설루션을 찾을 것”이라고 강조했다.

곽노정 사장, AI 생태계 확장을 위한 메모리 비전과 기술 전략 제시

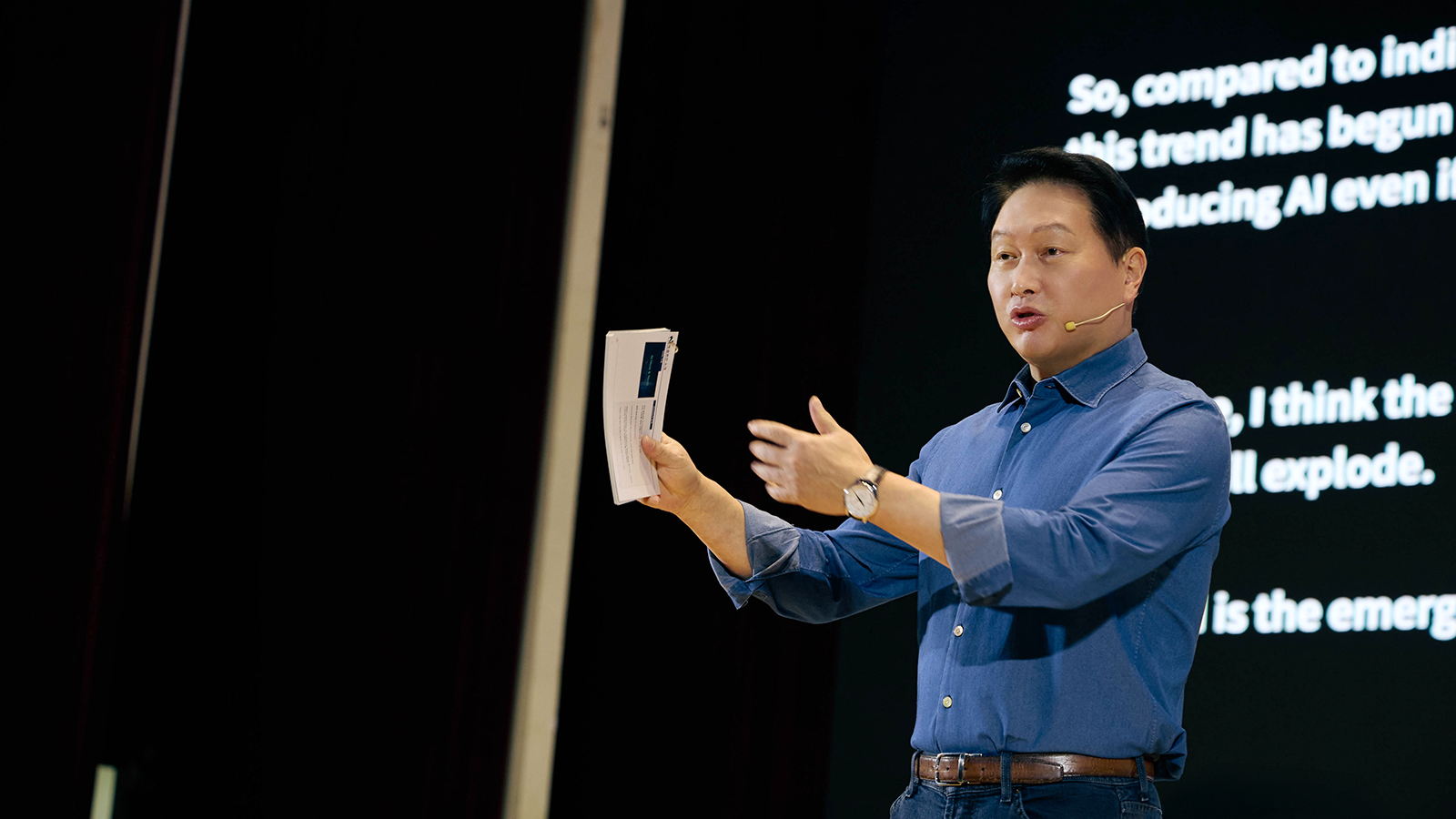

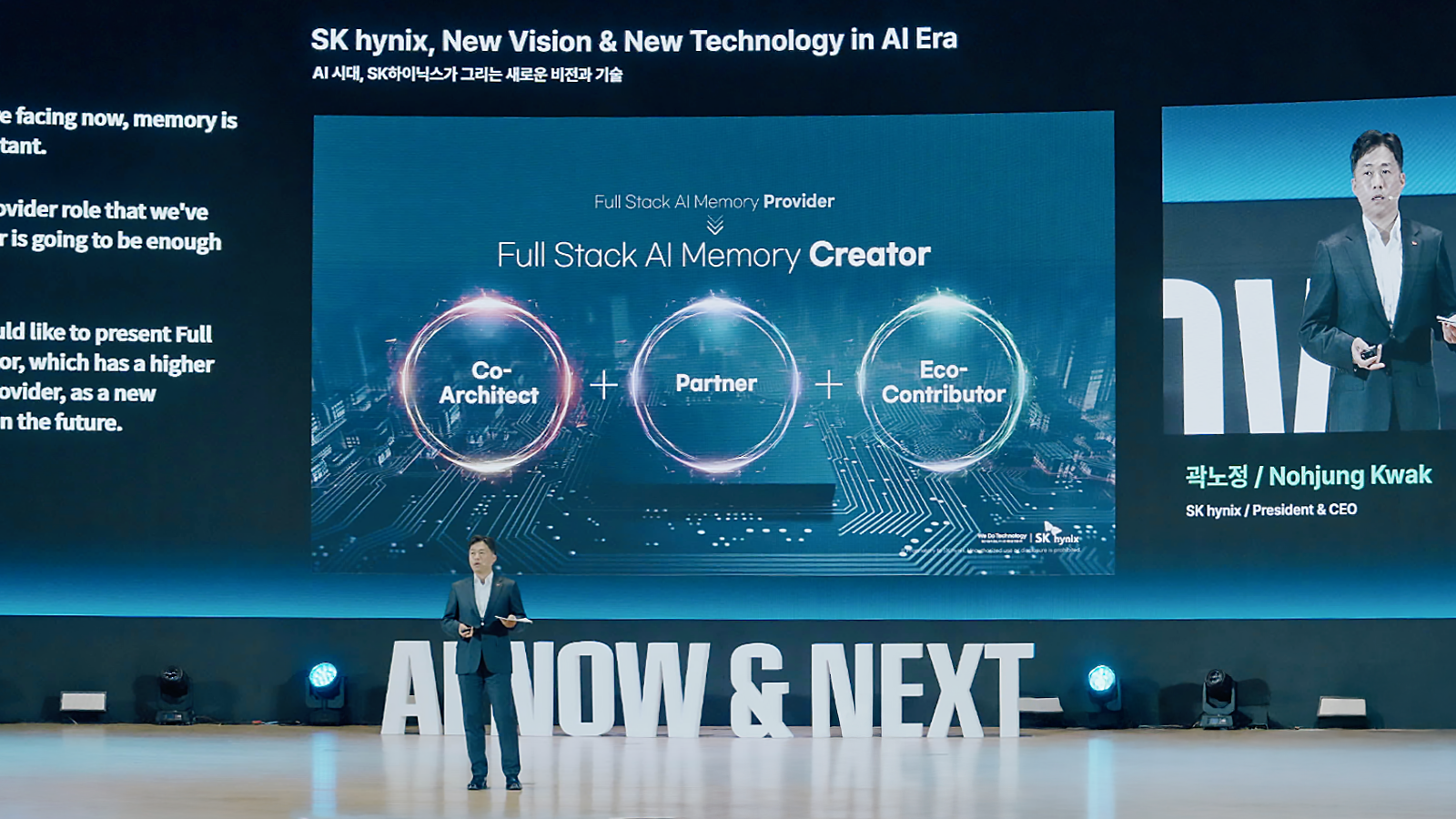

3일 ‘AI 시대, SK하이닉스가 그리는 새로운 비전과 기술(SK hynix, New Vision & New Technology in AI Era)’을 주제로 기조연설을 펼친 곽노정 대표이사 사장은 지난해 제시한 비전을 토대로 AI 확산 시대에 맞게 고도화하며, 기술 혁신과 생태계 협력의 방향을 한층 구체화했다.

곽 사장은 “AI 확산으로 데이터 이동량이 급격히 늘어나면서 이를 처리할 하드웨어의 성능 향상이 중요해지고 있지만, 메모리 속도가 프로세서의 발전 속도를 따라가지 못하는 ‘메모리 월(Memory Wall)*’ 현상이 기술 발전의 걸림돌로 지적되고 있다”고 말했다. 이어 “메모리는 더 이상 단순한 부품이 아닌, AI 산업의 핵심 가치 상품(Key Value Product)으로 그 중요성이 커지고 있다”며, “기존과 같은 수준의 성능 개선만으로는 더 이상 시장의 요구를 충족시킬 수 없다”고 덧붙였다.

* 메모리 월(Memory Wall): 프로세서와 메모리의 성능 차이로 생기는 데이터 병목 현상

이어 곽 사장은 “SK하이닉스는 고객이 원하는 제품을 적시에 공급하는 ‘풀 스택 AI 메모리 프로바이더(Full Stack AI Memory Provider)’의 역할을 해왔지만, 앞으로는 고객의 문제를 함께 해결하고 생태계와 협력해 더 큰 가치를 만드는 풀 스택 AI 메모리 크리에이터(Full Stack AI Memory Creator)로 거듭나고자 한다”고 밝히며, “공동 설계자(Co-Architect)이자 파트너, 그리고 생태계 기여자(Eco-Contributor)로서 AI 인프라의 미래를 함께 설계해 나가겠다”고 강조했다.

이와 함께 곽 사장은 커스텀(Custom) HBM, AI-D(AI D램), AI-N(AI 낸드)을 세 축으로 한 ‘풀 스택 AI 메모리’ 전략을 공개했다. 먼저, 커스텀 HBM은 AI 시장의 요구가 범용성에서 추론 효율성과 TCO(총소유비용) 최적화로 확대됨에 따라, GPU와 ASIC에 탑재되던 일부 연산 기능을 HBM 베이스 다이(Base-Die)로 옮겨 성능을 극대화한 제품이다. 이를 통해 GPU와 ASIC의 연산 효율을 높이고, 통신 전력을 줄여 시스템 효율을 개선한다.

AI-D(AI D램)는 기존의 범용 D램을 넘어 AI 시대의 요구에 맞게 세분화된 제품군이다. ▲TCO 절감과 운영 효율화를 지원하는 저전력·고성능 D램 ‘AI-D O(Optimization)*’, ▲초고용량·고유연성 메모리 구조로 ‘메모리 월(Memory Wall)’ 한계를 극복하는 ‘AI-D B(Breakthrough)*’, ▲로보틱스·모빌리티·산업 자동화 등 응용 분야로 확장 가능한 ‘AI-D E(Expansion)*’을 개발하고 있다.

* AI-D Optimization: 데이터센터 최적화 설루션 제품으로 MRDIMM, SOCAMM2, LPDDR5R 등이 있음

* AI-D Breakthrouth: 메모리 월을 뛰어넘기 위한 설루션 제품으로 CMM, PIM 등이 있음

* AI-D Expansion: 데이터센터 뿐만 아니라 다른 용처에서 사용이 가능한 설루션 제품으로 HBM 등이 있음

AI-N(AI 낸드)은 AI 시스템의 고성능·고대역폭·초고용량을 아우르는 차세대 스토리지 설루션이다. ▲작은 Chunk Size를 통해 IOPS 성능을 크게 높인 초고성능 SSD ‘AI-N P(Performance)*’ ▲HBM 적층 구조를 적용해 대역폭을 넓힌 ‘AI-N B(Bandwidth)*’ ▲QLC 기반으로 PB(페타바이트)급 용량을 구현해 SSD의 속도와 HDD의 경제성을 동시에 확보한 ‘AI-N D(Density)*’ 등 세 방향으로 기술을 고도화하고 있으며, 이를 통해 AI 향 스토리지 경쟁력을 한층 강화하고 있다.

*AI-N Performance: 대규모 AI 추론 환경에서 발생하는 방대한 데이터 입출력을 효율적으로 처리하는 설루션으로 AI 연산과 스토리지 간 병목 현상을 최소화해 처리 속도와 에너지 효율을 대폭 향상시킴. SK하이닉스는 낸드와 컨트롤러를 새로운 구조로 설계 중이며, 2026년 말 샘플 출시 계획임

* AI-N Bandwidth: 낸드를 적층해 대역폭을 확대한 설루션으로 대용량, 저비용의 낸드에 HBM 적층 구조를 결합한 것이 핵심임

* AI-N Density: 저전력, 저비용으로 대용량 데이터를 저장하는 데 초점을 맞춘 고용량 설루션으로 AI 데이터 보관에 적합. 기존 QLC 기반 TB(테라바이트)급 SSD보다 용량을 최대 PB(페타바이트)급으로 높이고, SSD의 속도와 HDD의 경제성을 동시에 구현한 중간 계층 스토리지를 목표로 하고 있음

곽 사장은 기조연설을 마무리하며 “SK하이닉스는 계속해서 AI 산업 내 글로벌 플레이어들과 ‘원팀(One Team)’ 협업을 통해 차세대 AI 시대를 선도하는 메모리 기업으로 역할을 확장해 나가겠다”고 강조했다.

AI 인프라의 미래를 논하다… 메모리 중심 기술 인사이트 공유

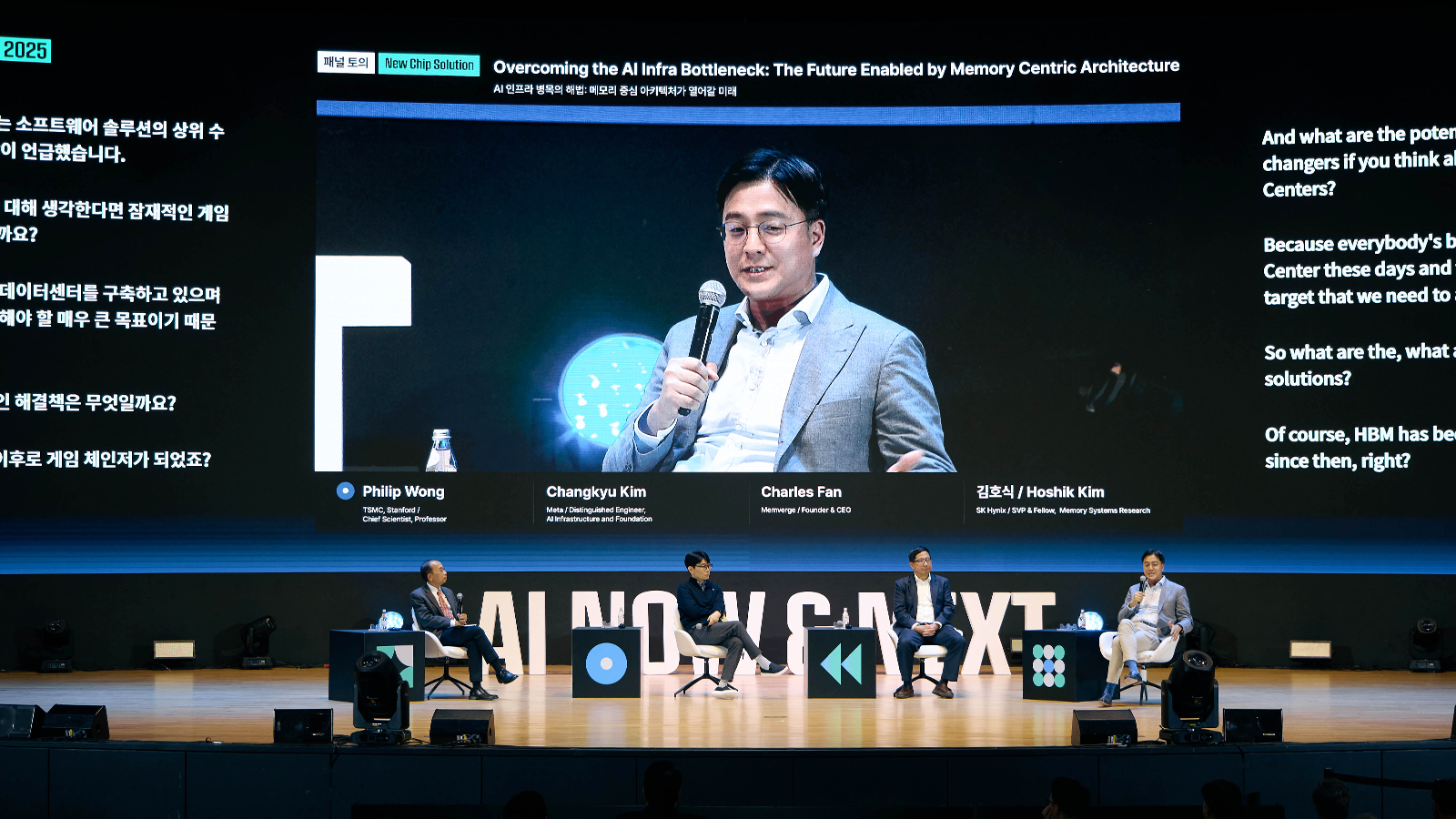

김호식 부사장(Memory System Research 담당)은 UC버클리 데이비드 패터슨(David A. Patterson) 명예교수, 스탠퍼드대학교 필립 웡(Philip Wong) 교수, 메타(Meta) 창규 김(Changkyu Kim) 디스팅귀시드 엔지니어(Distinguished Engineer), 멤버지(MemVerge) CEO 찰스 팬(Charles Fan)과 함께 ‘AI 인프라 병목의 해법: 메모리 중심 아키텍처가 열어갈 미래(Overcoming the AI Infra Bottleneck : The Future Enabled by Memory Centric Architecture)’를 주제로 한 키노트 세션 내 패널 토의 세션에 참석했다. 김 부사장은 AI 연산 성능 확장을 위한 메모리 중심 아키텍처의 필요성과 산업 전반의 협력 생태계 구축 방안을 논의했다.

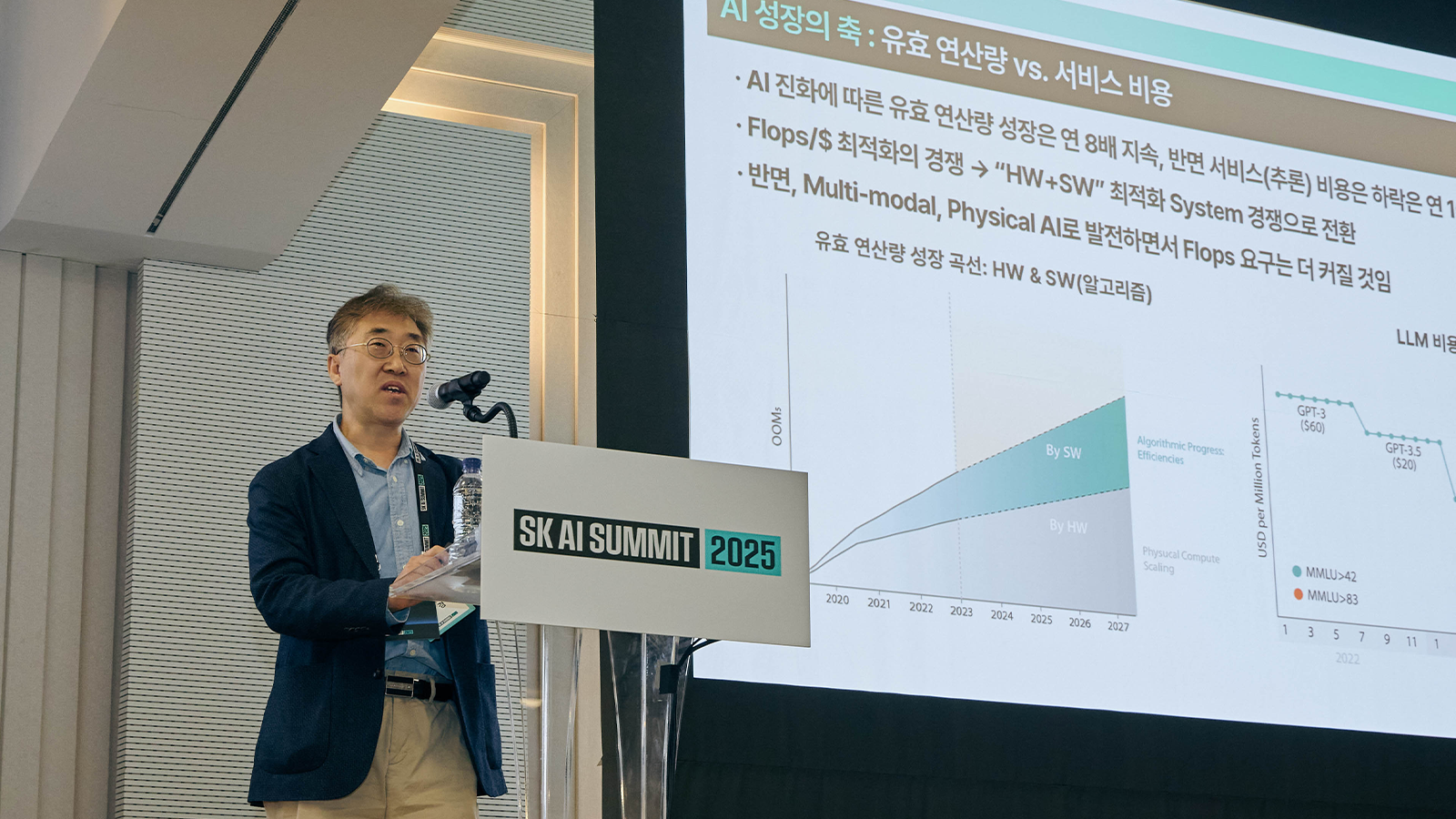

박경 부사장(Biz. Insight 담당)은 ‘AI Service Infra의 진화와 메모리의 역할’을 주제로 세션 발표를 진행했다. 박 부사장은 “AI 서비스는 초거대 모델 기반의 클라우드 추론부터 엣지 서버·디바이스의 경량화 모델까지 빠르게 다양회되고 있다”며, 메모리가 단순한 저장소를 넘어 AI 시스템의 성능을 좌우하는 핵심 자원으로 부상하고 있음을 강조하고, 메모리 기술이 AI 인프라의 혁신을 주도하는 핵심 역할을 하게 될 것이라고 분석했다.

주영표 부사장(System Architecture 담당)은 ‘메모리 기업 입장에서 바라본 시스템 업체와의 협업 필요성과 방향’을 주제로 발표하며, 워크로드별 요구에 최적화된 메모리 구조 구현을 위해서는 ASIC* 및 시스템 업체와의 긴밀한 협업이 필요하다고 강조했다. 또, 구조 설계, 인터페이스, 전력과 열 특성을 고려한 통합적 접근 방안을 제시했다.

* ASIC(Application Specific Integrated Circuit): 특정 목적을 위해 설계된 집적 회로. 주문형 반도체라고도 함

외부 연사인 버지니아대학교 이규상 교수는 ‘거대 연산망 구현을 위한 CPO 기반 차세대 연결 기술로의 진화’를 주제로 발표를 이어갔다. 이 교수는 “기존 전기적 인터커넥트가 대규모 AI 연산 환경에서 대역폭과 에너지 효율 측면의 한계에 직면해 있다”며, 이를 극복할 핵심 기술로 CPO(Co-Packaged Optics)를 제시했다. 또, 레이저 광원의 발열과 파장 변동 문제의 대안으로 마이크로 LED 기반 광원 채택의 가능성을 언급했다.

주요 발표와 연계한 AI 메모리 라인업도 선보여

▲ SK 공동 부스

‘The Next Depth’를 콘셉트로 구성된 SK 공동 부스에서 SK하이닉스는 AI 인프라의 성능과 효율을 극대화할 다양한 혁신 기술을 선보였다.

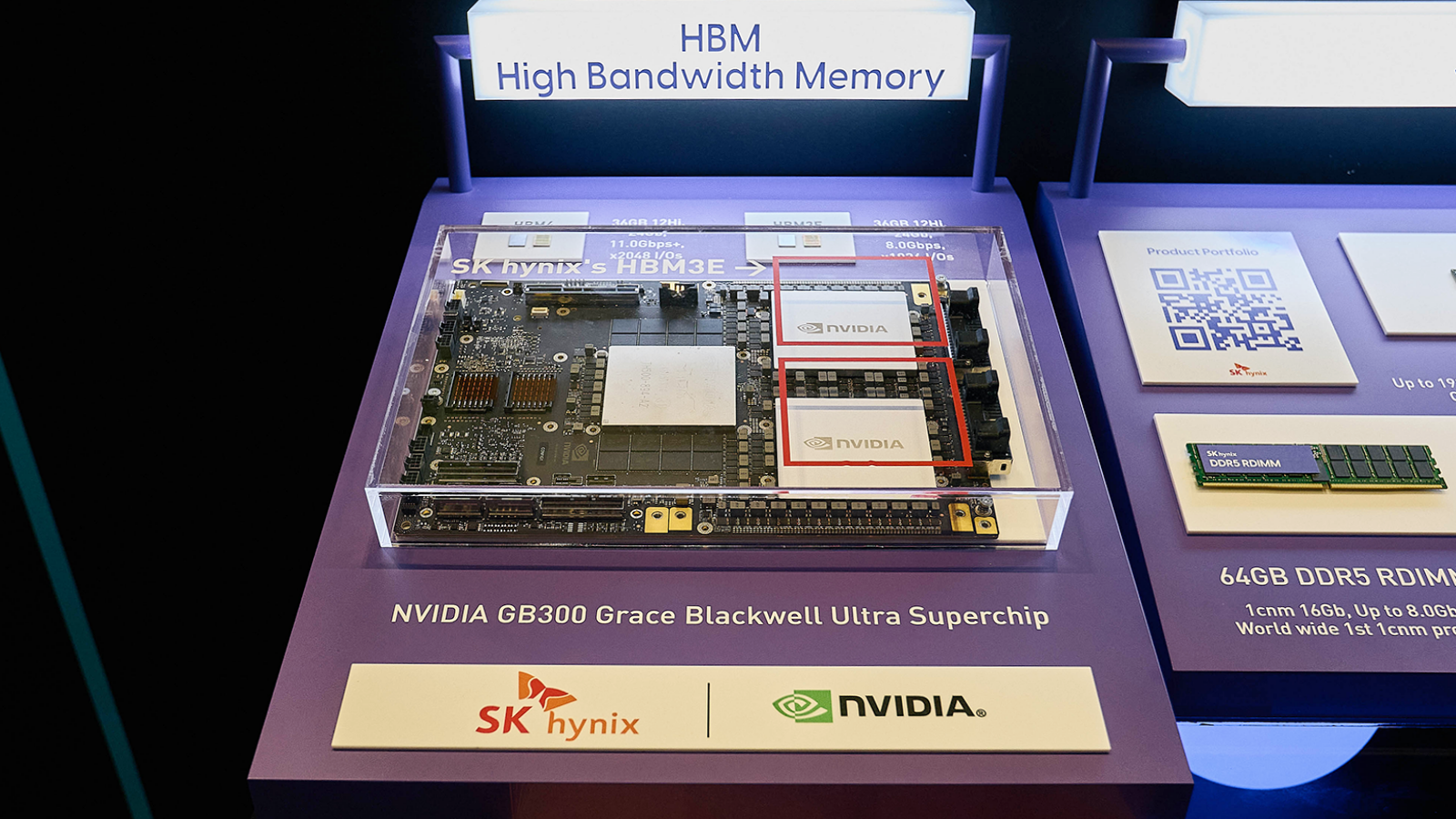

이번 행사에서 SK하이닉스는 ‘HBM4* 12단’과 ‘HBM3E 12단’을 선보였다. HBM4는 이전 세대의 두 배인 2,048개의 데이터 출입 통로(I/O)를 적용해 대역폭이 늘어났으며, 전력 효율은 40% 이상 개선되어 초고성능 AI 연산 시스템에 최적화된 설루션으로 평가받고 있다. 이와 함께 현존 최고 성능과 용량을 갖춘 HBM3E 36GB(기가바이트)가 탑재된 엔비디아의 차세대 GPU 모듈인 ‘GB300 (Grace™ Blackwell Superchip)’이 전시됐다.

* HBM(High Bandwidth Memory): 여러 개의 D램을 수직으로 연결해 기존 D램보다 데이터 처리 속도를 혁신적으로 끌어올린 고부가가치, 고성능 제품. HBM은 1세대(HBM)-2세대(HBM2)-3세대(HBM2E)-4세대(HBM3)-5세대(HBM3E)-6세대(HBM4) 순으로 개발됨

▲ SK하이닉스의 다양한 D램 제품

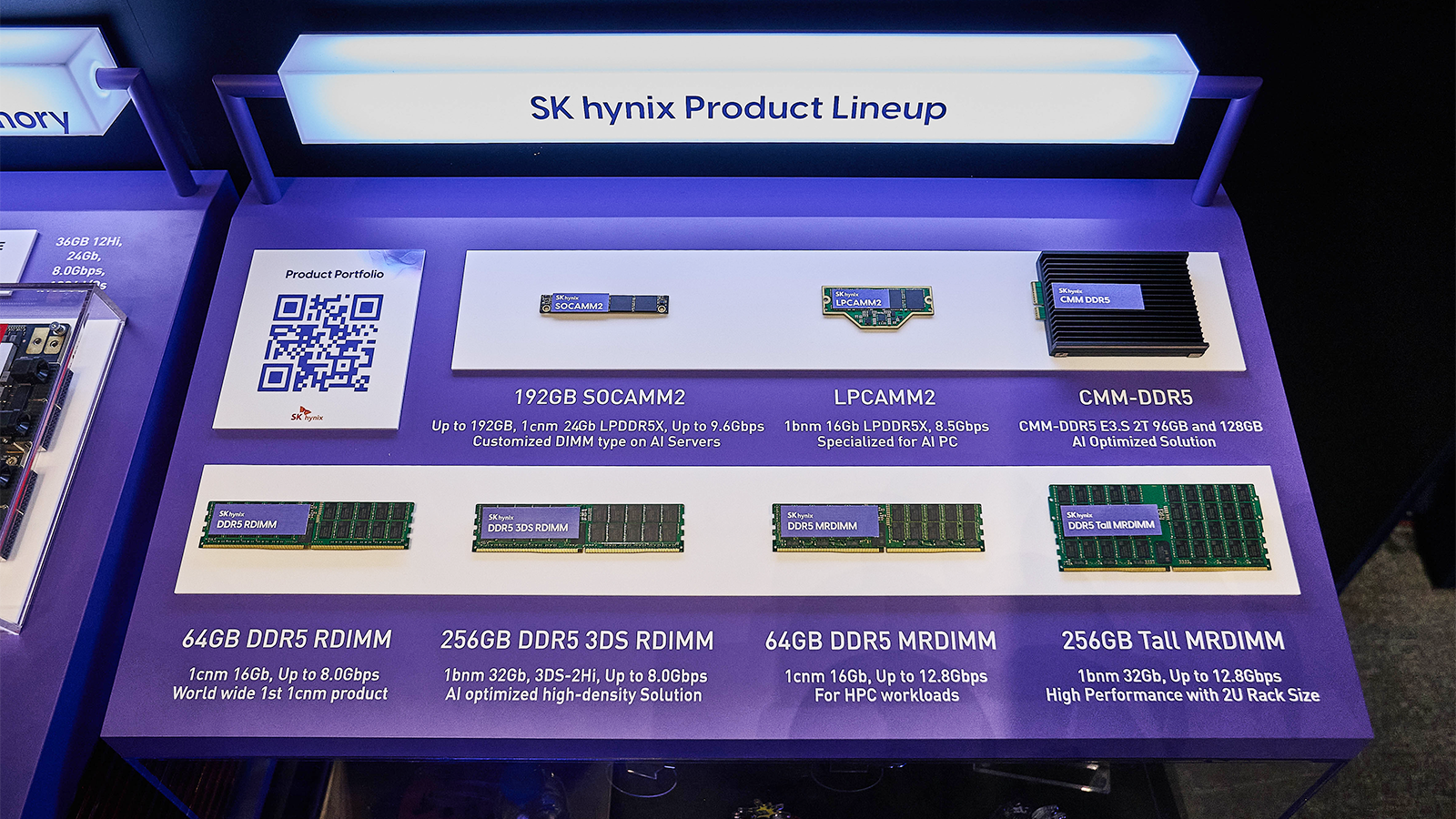

D램 모듈 라인업에서는 글로벌 AI 메모리 시장을 선도할 차세대 제품을 대거 선보였다. 10나노(nm)급 6세대(1c)* 미세공정 기술을 적용한 ▲RDIMM* ▲ MRDIMM*을 비롯해 ▲3DS* RDIMM(256GB) ▲Tall MRDIMM(256GB)* ▲SOCAMM2* ▲CMM(CXL* Memory Module)-DDR5 등의 제품군을 통해 PC부터 AI 서버까지 다양한 애플리케이션에 적용될 수 있는 기술력을 드러냈다. 또, 여러 개의 LPDDR5X를 하나의 모듈로 묶어 저전력·고성능을 동시에 실현한 ‘LPCAMM2*’도 메모리 혁신을 이끌 차세대 설루션으로 주목받았다.

* 10나노(nm)급 D램 미세공정 기술은 1x-1y-1z-1a-1b-1c(6세대) 순으로 개발되어 왔으며, SK하이닉스는 2024년 8월 세계 최초로 1c 기술 개발에 성공했다.

* RDIMM(Registered Dual In-line Memory Module): 여러 개의 D램이 기판에 결합된 서버용 모듈 제품

* 3DS(3D Stacked Memory): 2개 이상의 D램 칩을 TSV(수직관통전극)로 연결해 패키징 간 고성능 메모리 설루션

* MRDIMM(Multiplexed Rank Dual In-line Memory Module): 모듈의 기본 동작 단위인 랭크(Rank) 2개가 동시 작동해 속도가 향상된 서버용 모듈 제품

* SOCAMM(Small Outline Compression Attached Memory Module): 저전력 D램 기반의 AI 서버 특화 메모리 모듈

* CXL(Compute Express Link): 고성능 컴퓨팅 시스템에서 CPU/GPU, 메모리 등을 효율적으로 연결해 대용량, 초고속 연산을 지원하는 차세대 인터페이스. 기존 메모리 모듈에 CXL을 적용하면 용량을 10배 이상 확장할 수 있음

* LPCAMM2(Low-Power Compression Attached Memory Module): LPDDR5X 기반의 모듈 제품으로, 기존 DDR5 기반의 SODIMM(노트북/소형PC용 모듈) 2개를 대체하는 성능 효과를 가지면서 공간 절약과 저전력/고성능 특성을 구현

또, Pooled Memory*를 활용하여 복수의 서버와 GPU들을 연결한 분산 LLM 추론 시스템 Memory Centric AI Machine도 공개됐다. 네트워크 통신을 이용하는 LLM 추론 시스템 대비 CXL Pooled Memory 기반 데이터 통신을 사용할 경우 LLM 추론 시스템의 성능이 대폭 향상될 수 있음을 입증하며, CPU 중심 구조를 넘어 메모리가 중심이 되는 새로운 AI 컴퓨팅 패러다임을 제시했다.

* Pooled Memory: 여러 개의 CXL 메모리를 묶어 풀(Pool)을 만들어 여러 호스트가 효과적으로 용량을 나누어 사용하여 전반적인 메모리 사용률을 높이는 기술

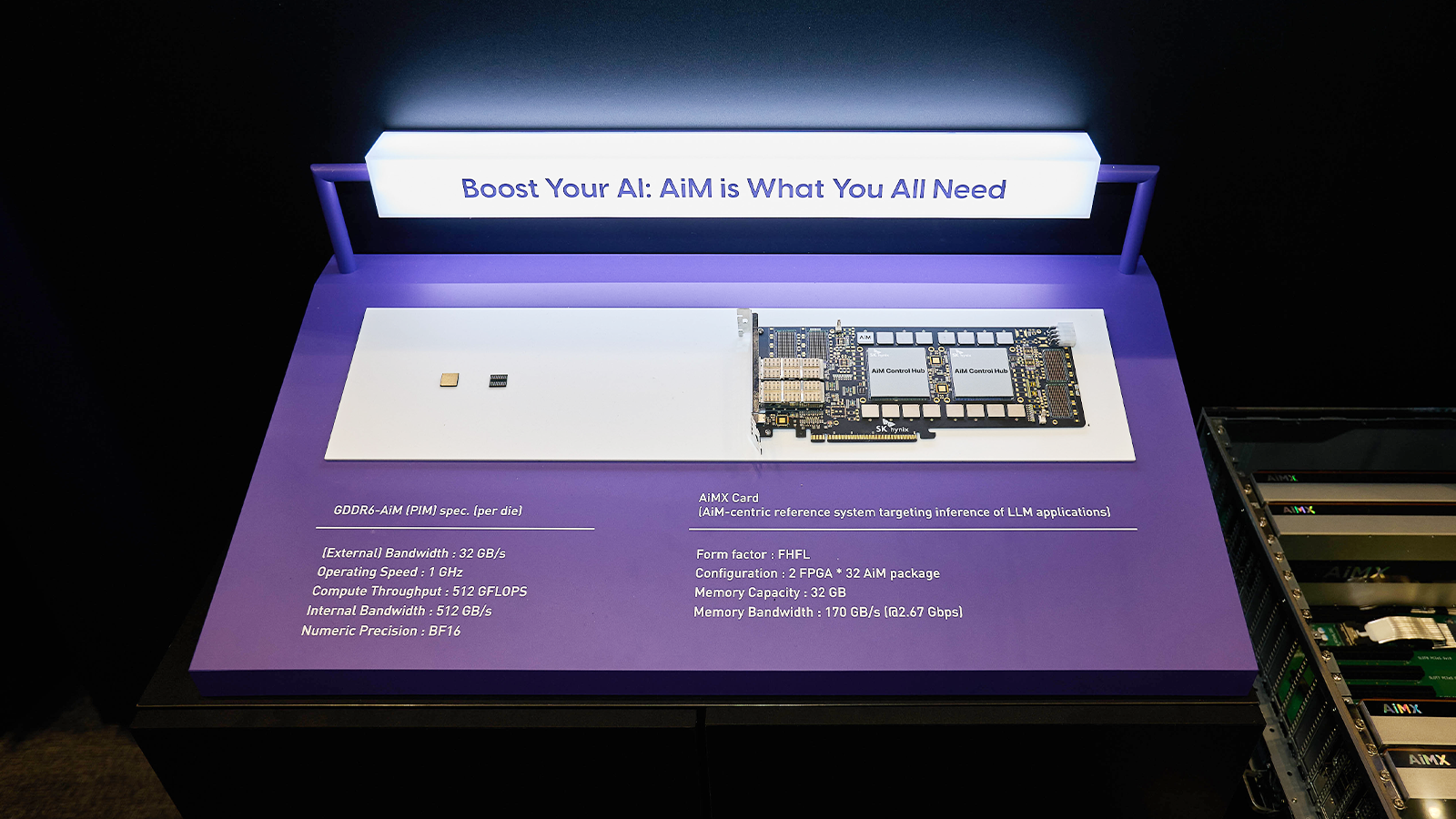

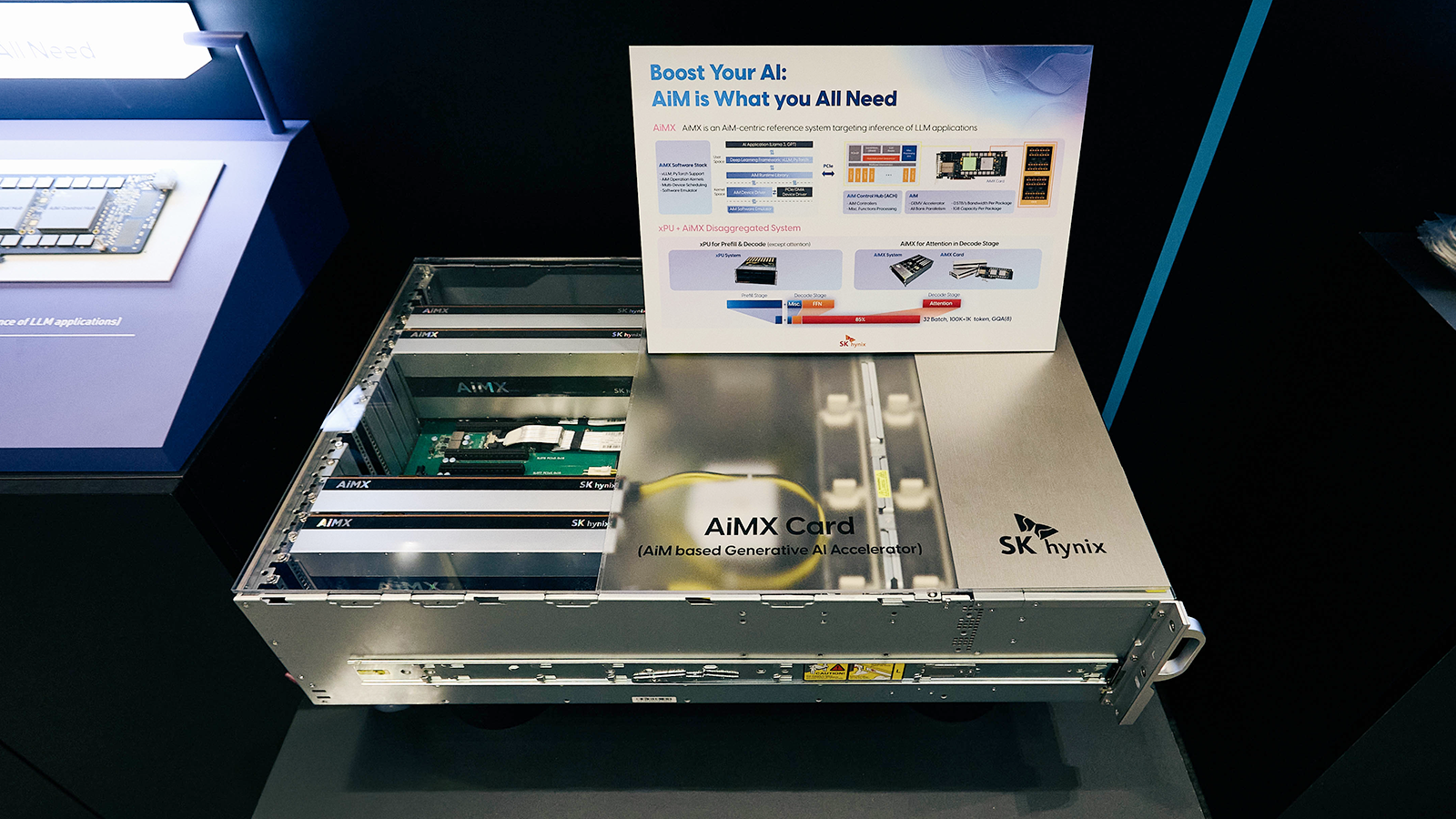

이와 함께 ‘GDDR6-AiM*’ 칩과 이를 여러 개 탑재한 ‘AiMX*’ 가속기 카드도 공개됐다. AiMX 카드와 엔비디아(NVIDIA)의 GPU(H100)가 장착된 서버에서 AiMX는 LLM(거대언어모델)의 핵심인 어텐션* 연산에 최적화되어 메모리 바운드* 작업의 속도와 효율을 크게 개선했으며, 긴 질문·답변 과정에서 발생하는 KV 캐시* 데이터 이동과 연산 효율성을 높여 메모리 병목 문제를 완화했다.

* AiM(Accelerator-in-Memory): SK하이닉스의 PIM 반도체 제품명으로, GDDR6-AiM이 이에 포함됨

* AiMX(AiM based Accelerator): 대규모 언어 모델 처리에 특화된 SK하이닉스의 GDDR6-AiM 기반 가속기 카드 제품

* 어텐션(Attention): 입력 데이터에서 어떤 정보에 가장 집중해야 하는지를 동적으로 결정하는 알고리즘 기법

* 메모리 바운드(Memory Bound): 전체 시스템 성능이 프로세서의 계산 능력이 아닌, 메모리 대역폭으로 제한되어 정보 처리 시 메모리로의 접근을 기다려야 하는 상태

* KV 캐시(KV Cache): 이전에 쓰인 Key(키)와 Value(값) 벡터를 저장하고 재활용해 이전 계산을 반복하는 비효율성을 줄여주는 기술

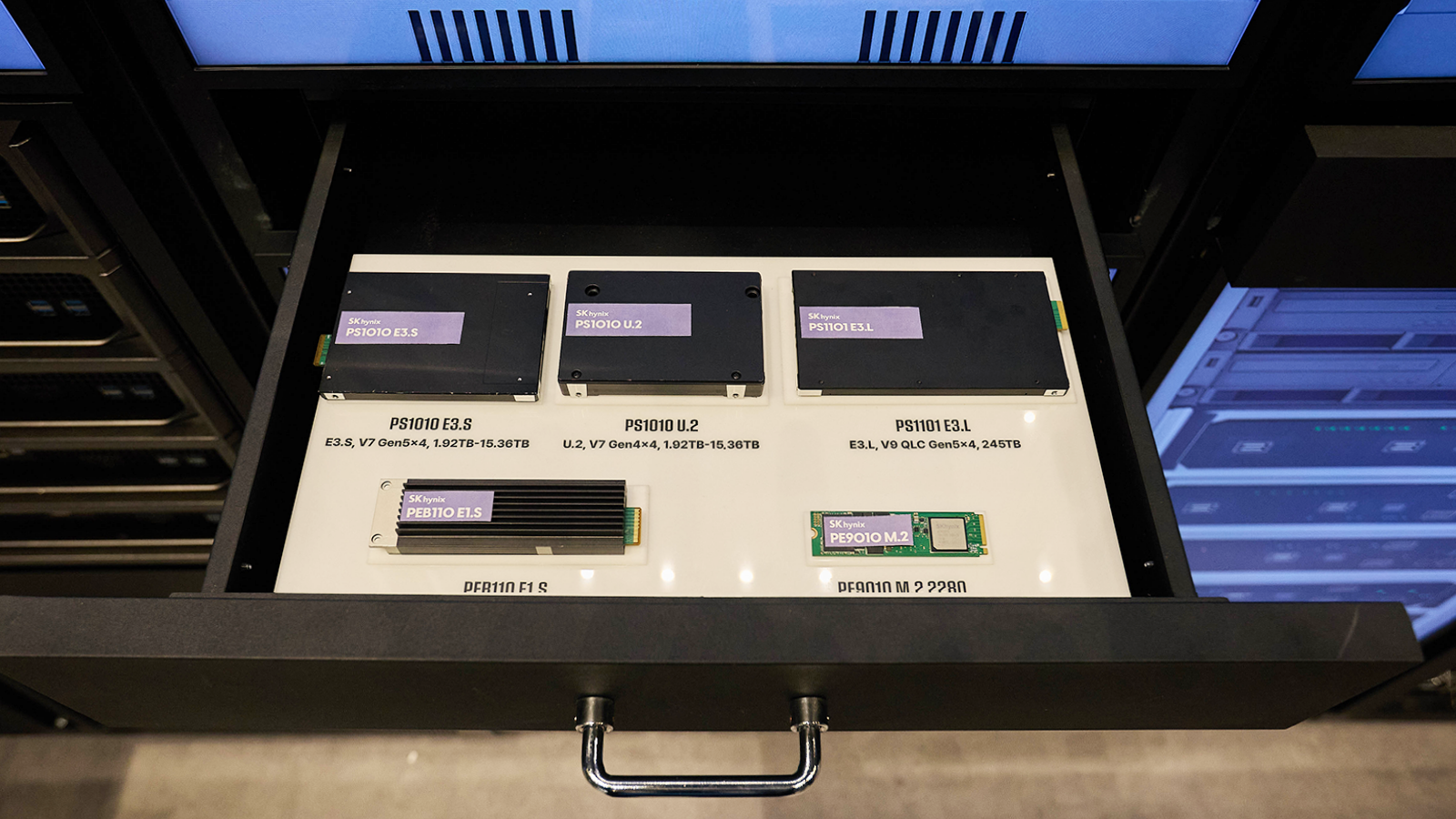

▲ SK하이닉스의 다양한 eSSD 제품

이번 행사에서 176단 4D 낸드 기반의 데이터센터 eSSD*인 ▲PS1010 E3.S(1.92-15.36TB)를 비롯해 238단 4D 낸드 기반의 ▲PEB110 E1.S(1.92-7.68TB), 그리 최고층인 321단 QLC* 기반 초고용량 제품인 ▲PS1101 E3.L(245TB) 등 압도적인 성능의 eSSD도 만나볼 수 있었다. 해당 제품군은 Computing 서버용 TLC SSD부터 Storage 서버용 QLC SSD까지 아우르는 포트폴리오로, AI 서비스 인프라의 데이터 처리 효율을 높이고 대규모 연산 환경에서의 저장장치 활용성을 극대화한다.

* eSSD(Enterprise Solid State Drive): 서버나 데이터센터에 탑재되는 기업용 SSD

* QLC: 낸드플래시는 한 개의 셀(Cell)에 몇 개의 정보(비트 단위)를 저장하느냐에 따라 SLC(Single Level Cell, 1개)-MLC(Multi Level Cell, 2개)-TLC(Triple Level Cell, 3개)-QLC(Quadruple Level Cell, 4개)-PLC(Penta Level Cell, 5개) 등으로 규격이 나뉨

▲ 웨이퍼 노치 각도 탐지 시스템(Wafer Notch Angle Detection System)

AIX 존에서는 ‘웨이퍼 노치 각도 탐지 시스템’도 살펴볼 수 있었다. 이 시스템은 반도체 챔버* 내에 딥러닝 모델 YOLOv8-OBB를 적용해 웨이퍼 노치를 실시간으로 정밀 감지하며, 기존 센서 방식의 한계를 보완해 공정 불량을 사전에 차단하고 장비 유지보수 비용 절감이 가능한 기술로 주목받았다.

* 챔버(Chamber): 반도체 제조 공정에서 특정 작업이 이뤄지는 밀폐된 공간. 식각 공정을 예로 들면 반도체 웨이퍼를 가공하고 처리하는 공간이 된다. 반도체 제조 공정은 여러 개의 챔버가 결합된 장비를 사용해 다양한 작업을 수행한다.

이번 행사에서 곽노정 대표이사 사장은 “SK하이닉스는 고객과 파트너, 생태계와 함께 AI 메모리의 미래를 개척해 나가겠다”며 “고객 만족을 최우선 가치로 삼고, 글로벌 파트너들과 더 큰 시너지를 내며 넥스트 AI 시대를 이끌어 나가겠다”고 밝혔다.